Das HubSpot SEO Desaster und die Erkenntnisse daraus

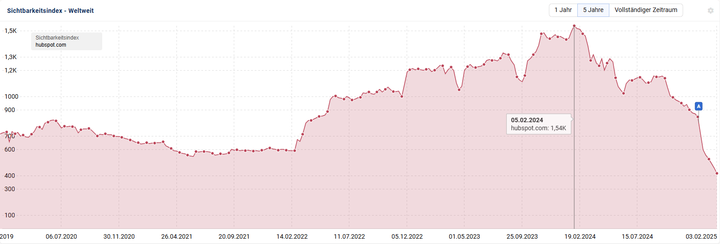

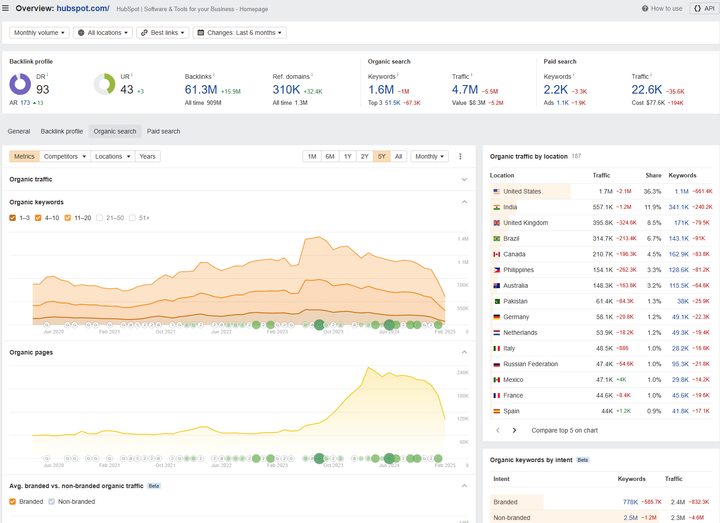

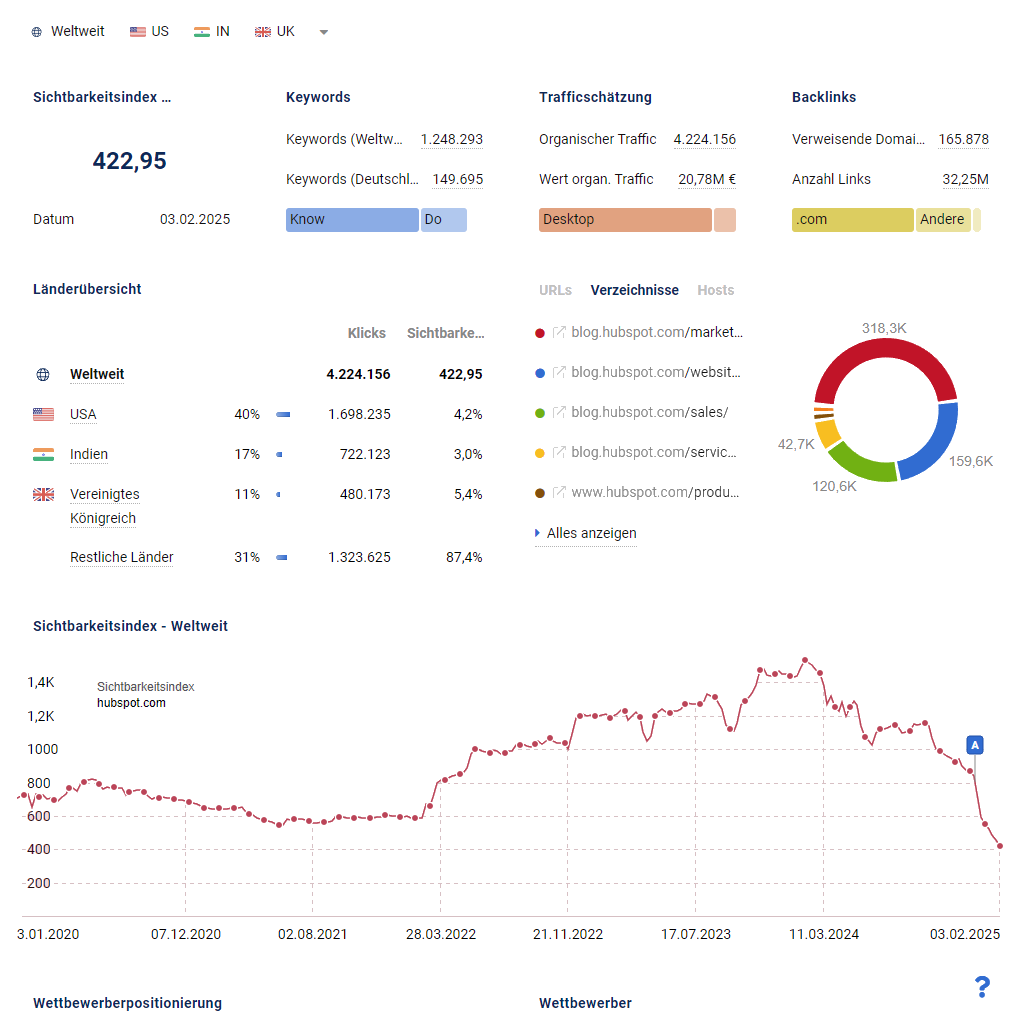

HubSpot, ein führender Anbieter im Bereich Inbound-Marketing, hat seit Frühjahr 2024 erhebliche Sichtbarkeitsverluste in den Suchmaschinen hinnehmen müssen. Diese Entwicklung hat weitreichende Implikationen für die SEO-Strategien von Unternehmen, die ähnliche Ansätze verfolgen.

Was ist passiert?

Seit dem Frühjahr 2024 verzeichnete HubSpot einen signifikanten Rückgang der Sichtbarkeit und des organischen Traffics.

Berichten zufolge sank der organische Traffic von etwa 13,5 Millionen Besuchen im November 2024 auf weniger als 7 Millionen im Dezember 2024, was einem Rückgang von über 50 % entspricht.

Quelle: Mittlerweile gelöschter Blogpost von Ryan Law, Director of Content bei Ahrefs.

Andere Quellen berichten von Traffic Verlusten zwischen 25 und fast 80 %.*

Top of the Funnel Inhalte können zum Problem werden!

Besonders betroffen sind in diesem Fall Top of the Funnel Inhalte zu allgemeineren Themen wie Zitaten oder Emojis, während transaktionsorientierte Keywords z. B. "HubSpot CRM" und "Marketing Automation Software" stabil blieben.

Analysen zeigen eine Verlagerung von Top-of-Funnel Keywords zur Konkurrenz:

- Microsoft Support Center Inhalte bei Excel Themen

- Adobe bei Design-Tutorials

- Reddit / UGC Plattformen bei nutzergenerierten Lösungen

Beispielsweise sank Hubspots Anteil an organischen Klicks bei auf Excel bezogenen Suchbegriffen von 7% auf 3%, während Microsofts Anteil von 4% auf 7% stieg.*

Der hier beobachtete Sichtbarkeitsverlust von hubSpot.com ist ein Paradebeispiel für die Herausforderungen moderner SEO Strategien im Zeitalter von KI-generiertem Content und strengeren Google-Richtlinien und wirft ein Schlaglicht auf die kommenden Herausforderungen einer modernen SEO Strategie.

*Quellen: Hier, hier und hier.

Die Ursachen für HubSpots Sichtbarkeitsverluste

Diese Entwicklung kann weitreichende Folgen für die SEO-Strategien von Unternehmen haben, die ähnliche Ansätze verfolgen.

1. Algorithmische Änderungen bei Google:

- Google hat seine Algorithmen angepasst, um qualitativ hochwertige und thematisch fokussierte Inhalte zu bevorzugen. HubSpots in Teilen breit gefächerte Content Strategie, die auch auf allgemeine Themen wie Zitate oder Kündigungsvorlagen setzte, wurde abgestraft, da es an thematischer Tiefe mangelte. Viele Blog Inhalte dienten eben primär nur der Generierung von hohem Traffic, ohne die Nutzerintention oder die Lead-Qualität ausreichend zu berücksichtigen.

- Das "Helpful Content System" von Google bewertet Inhalte stärker basierend auf Nutzersignalen wie Verweildauer und Absprungrate. HubSpot scheint hier durch negative Signale benachteiligt worden zu sein.

- Mangelnde E-E-A-T (Expertise, Erfahrung, Autorität, Vertrauenswürdigkeit)

Inhalte ohne erkennbare Expertenautoren oder ohne tiefergehende Expertise wurden von Google zunehmend abgewertet. Dies betrifft besonders generische Themen, die nicht direkt mit HubSpots Kernkompetenzen verknüpft sind. - Google priorisiert zunehmend hochwertige, von Menschen verfasste und geprüfte Inhalte gegenüber massenhaft generiertem KI-Content. HubSpot hatte auf skalierte Content-Produktion gesetzt und geriet hier ins Hintertreffen.

2. Negative Nutzersignale

Google misst immer stärker, wie Nutzer mit Inhalten interagieren, und nutzt diese Signale, um die Relevanz und Qualität einer Website zu bewerten:

- Klickrate (CTR): Eine niedrige CTR deutet darauf hin, dass der Titel oder die Meta-Beschreibung wenig attraktiv für die Suchintention ist.

- Long Clicks: Nutzer, die längere Zeit auf einer Seite verweilen, signalisieren Google, dass die Inhalte relevant und hilfreich sind.

- Longest Clicks: Wenn eine Seite der letzte besuchte Eintrag in der Suchsitzung ist, deutet dies auf eine zufriedenstellende Nutzererfahrung hin.

- Interaktionen mit Inhalten: Seiten mit hoher Engagement-Rate (z. B. durch Kommentare, Scrolltiefe oder das Anklicken interner Links) erzielen bessere Rankings. HubSpots generische Blogartikel wiesen in diesen Bereichen Defizite auf.

3. KI generierte Antworten in Suchergebnissen:

- Die Einführung von KI-gestützten "AI Overviews" durch Google reduziert die Notwendigkeit für Nutzer, auf externe Websites wie HubSpot zu klicken. Dies hat den Traffic auf informationsbasierten Blogbeiträgen erheblich verringert.

4. Skalierte Content Produktion:

- HubSpot veröffentlichte Tausende von Blogartikeln als Teil einer skalierbaren SEO Strategie. Diese Massenproduktion wurde jedoch zunehmend als "Low Quality Content" wahrgenommen, was zu einer seitenweiten Neubewertung führte.

Technische Analyse der Content-Probleme:

Eine detaillierte Untersuchung von über 10.000 HubSpot-Blogbeiträgen offenbarte mehrere kritische strukturelle Schwächen des KI-Contents:

- Gleichförmige Absatzlängen und Textstrukturen

- Wiederholende Phrasenstrukturen

- Standardisierte Überschriftenhierarchien

- Mangelnde thematische Tiefenvernetzung

Quelle hier

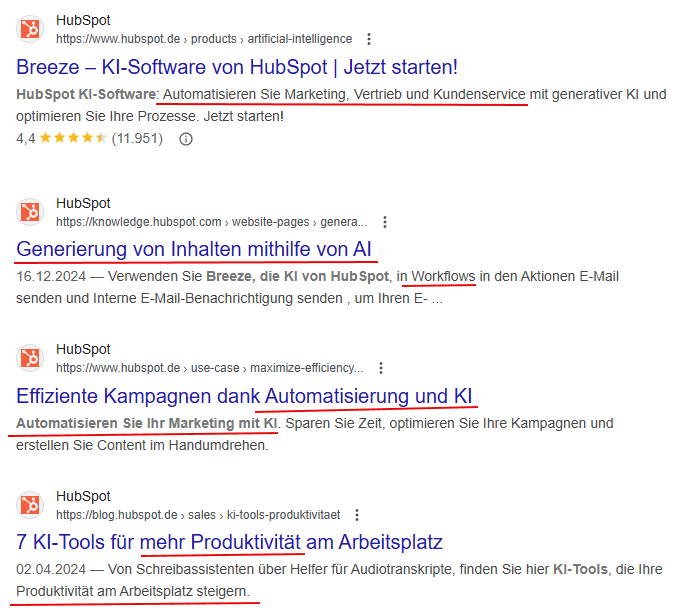

Vorsicht bei zu starker Nutzung der HubSpot eigenen KI-Tools! Es drohen ähnliche Konsequenzen.

5. Konkurrenz durch alternative Plattformen:

- Nutzer suchen verstärkt direkt auf Social-Media-Plattformen oder nutzen KI-Tools wie ChatGPT, was den organischen Suchverkehr weiter schmälert.

- UGC Konkurrenz: Reddit-Threads zu HubSpot-Themen verzeichnen enormen Traffic Zuwachs von über 100 %.

Die Rolle der Google Core Updates von März und Dezember 2024

Das Jahr 2024 markiert einen weiteren Wendepunkt in Googles Bewertung von Website Content. Die Core Updates, insbesondere die Versionen von März und Dezember 2024 mit den Schwerpunkten Qualität und Relevanz von Inhalten, zielten auf drei zentrale Missbrauchsmuster ab:

Missbrauch abgelaufener DomainsWebsites, die das Potenzial alter Domains zur Manipulation von Rankings nutzten, wurden stark abgewertet.Hier nicht relevant.- Skalierte KI-Content-Produktion

Mit der zunehmenden Verfügbarkeit von KI-Tools hat die Produktion von generischen und oft minderwertigen Inhalten massiv zugenommen. Google reagierte mit einer Verschärfung seiner Algorithmen, um KI-generierten Content ohne klare Qualität und Expertise zu identifizieren und abzuwerten.

Dies traf auch HubSpot, da dort automatisiert erstellte Bloginhalte bei generischen Keywords im Fokus standen. - Manipulative Content-Strategien ("Site-Reputation-Abuse", hier geht es eben nicht nur um Inhalte von Drittanbietern!)

Inhalte, die lediglich auf Traffic Generierung ausgelegt waren und keine thematische Relevanz für die Website aufwiesen, verloren stark an Sichtbarkeit. HubSpot ist da ein prominentes Beispiel: Blogartikel zu Themen wie "berühmte Zitate" oder "Lebenslaufvorlagen" wurden als nicht relevant für ein CRM-Unternehmen eingestuft und durch Googles Updates abgestraft.

Wer ist sonst noch betroffen?

Die Entwicklungen betreffen nicht nur HubSpot, sondern auch andere Unternehmen und Branchen:

- B2B / SaaS Unternehmen: Viele dieser Firmen setzen auf ähnliche SEO-Strategien mit Top of Funnel Inhalten und sind daher ebenfalls gefährdet.

- Publisher und Content-Plattformen: Nachrichtenseiten und allgemeine Content-Portale haben 2024 ebenfalls massive Verluste erlitten, da Google zunehmend spezialisierte Inhalte bevorzugt.

- KMU mit starkem Fokus auf SEO: Besonders kleinere Unternehmen, die stark auf organischen Traffic angewiesen sind, müssen ihre Strategien anpassen.

Implikationen für zukunftssichere SEO Strategien

Die Sichtbarkeitsverluste von HubSpot verdeutlichen die Notwendigkeit eines Paradigmenwechsels in der Suchmaschinenoptimierung:

1. Qualität vor Quantität:

- Unternehmen sollten weniger Artikel produzieren, dafür aber Inhalte mit höherer Qualität und Mehrwert erstellen. Dies umfasst tiefgehende Analysen, Expertenmeinungen und First-Hand-Experience-Inhalte.

Setzen Sie das E-E-A-T Konzept um:

- Inhalte sollten von Experten mit nachweislicher Fachkompetenz erstellt werden. Autorenprofile mit Zertifizierungen, Praxis-Cases und branchenspezifischer Erfahrung sind ein Muss.

- Kundenreferenzen und Anwendungsbeispiele können die Glaubwürdigkeit weiter stärken.

- Verknüpfung von Content mit konkreten Fallstudien

- Einbindung von Branchenexperten und deren Fachwissen

2. Fokus auf Nutzersignale:

- Bei Leads geht Qualität über Quantität

- Die Optimierung der Verweildauer und Reduzierung der Absprungrate durch Inhalte mit hohem Mehrwert werden entscheidend. Inhalte müssen klar strukturiert sein und die Nutzerintention präzise erfüllen.

- Attraktive Snippets: Aussagekräftige Titel und Meta-Beschreibungen erhöhen die CTR.

- Interaktive Inhalte: Tools wie Rechner, Quizze oder Videos regen zur Interaktion an und verbessern die Engagement-Rate.

- Optimierung der internen Verlinkung: Relevante interne Links führen Nutzer tiefer in die Website und signalisieren Google die Bedeutung verschiedener Inhalte.

Das betrifft auch ihr Monitoring bzw. Analytics: Metriken wie Conversion Rates und Pipeline Influence sollten Sessions und Pageviews als KPI ablösen.

3. Diversifizierung der Content Strategie:

- Die Content-Strategie sollte auf die Qualität der Leads abzielen. Weniger, aber dafür hochqualifizierte Besucher sind wertvoller als eine große Anzahl irrelevanter Nutzer.

- Neben klassischem SEO sollten Unternehmen verstärkt auf Social SEO (z.B. Optimierung für TikTok oder Instagram) setzen und alternative Kanäle wie Newsletter oder Community-Plattformen nutzen.

4. Technische Optimierungen:

- Core Web Vitals (Ladegeschwindigkeit, Interaktivität) sowie mobile-first Indexing müssen priorisiert werden, um technische Nachteile zu vermeiden.

LCP (Largest Contentful Paint) sollte deutlich unter 2,5 Sekunden bleiben,

FID (First Input Delay) unter 100 Millisekunden und

CLS (Cumulative Layout Shift) unter 0,1 Sekunden!

- Implementierung erweiterter strukturierter Daten für Expertise-Signale (Produktfeatures und Preise)

- Eine klare Subdomain-Strategie, die Produkt- und Bloginhalte trennt, hilft außerdem auch noch, Crawling-Budgets effizienter zu nutzen.

5. Themenautorität stärken:

- Der Aufbau von Topic Clustern bleibt relevant, jedoch mit stärkerem Fokus auf spezifische Nischen und Expertise innerhalb eines Themenbereichs.

6. KI Integration und Anpassung:

- Unternehmen sollten KI-Technologien nutzen, um Inhalte effizienter zu erstellen und gleichzeitig sicherzustellen, dass diese den neuen Anforderungen von Google entsprechen (z.B. E-E-A-T: Experience, Expertise, Authoritativeness, Trustworthiness).

Fazit

Der Sichtbarkeitsverlust von HubSpot zeigt deutlich, dass klassische SEO-Ansätze nicht mehr ausreichen. Die Entwicklungen bei Google erfordern einen Paradigmenwechsel hin zu nutzerzentrierten Strategien mit hohem Mehrwert und technischer Exzellenz. Unternehmen sollten ihre SEO-Playbooks überdenken und sich an die veränderten Anforderungen anpassen, um langfristig wettbewerbsfähig zu bleiben.

Die Sichtbarkeitsverluste von HubSpot verdeutlichen die Notwendigkeit, sich von überholten SEO-Praktiken wie massenhaftem KI-Content und generischen Keywords zu verabschieden. Qualität, Relevanz, Expertise und positive Nutzersignale sind die neuen Währungen im Google-Algorithmus. Für HubSpot-Partner bietet diese Entwicklung die Chance, ihre Kunden durch fundierte Beratung und innovative Ansätze auf den neuen Kurs einzustimmen und messbaren Mehrwert zu schaffen.

Exkurs 1 - Chancen für Hubspot Partner Agenturen

Für jedes Web-Projekt gilt: Die Inhalte sollten auf die Unternehmensziele und die Brand des Betreibers ausgerichtet werden. Generische Keywords sind in den meisten Fällen wenig bis gar nicht relevant; stattdessen sollte der Fokus auf die Fragen und Bedürfnisse der potentiellen Interessenten ausgerichtet werden. Es muss klar kommuniziert werden: "Was können wir (Firma xyz) tun, um Ihr ganz persönliches Problem/ Bedürfnis/ Frage zu lösen."

Die aktuelle Situation bietet Agenturen eine gute Gelegenheit, sich strategisch neu zu positionieren:

- Beratung auf ROI-Basis

Kunden sollten weniger auf Traffic-Zahlen, sondern auf messbare Geschäftsergebnisse fokussiert werden. Dies erfordert häufig ein Umdenken in der Kundenberatung. - Technische Exzellenz als USP

Agenturen können sich durch technische SEO Kompetenz und innovative Content-Strategien von der Konkurrenz abheben. - E-E-A-T-Training und Content-Qualität

Die Investition in hochwertigere Inhalte und die Schulung von Teams, um den neuen Qualitätsstandards von Google gerecht zu werden, wird sich langfristig auszahlen.

Exkurs 2 - Kritische Betrachtung der HubSpot-internen und aller anderen KI-Tools

Die zunehmende Integration von KI-gestützten Funktionen in HubSpot – etwa zur automatisierten Erstellung von Texten, Titeln oder Meta Descriptions – eröffnet spannende Möglichkeiten, birgt aber auch Risiken, die bedacht werden müssen.

Vorteile der KI-Tools

- Zeitersparnis: KI-Tools können bei der Erstellung grundlegender Inhalte, wie Textgliederungen, Inhaltsverzeichnissen oder Blogskizzen, erheblich Zeit sparen und den kreativen Prozess beschleunigen.

- Inspiration und Struktur: Sie liefern wertvolle Vorschläge, die als Ausgangspunkt für menschliche Anpassungen dienen können.

- Skalierbarkeit: Gerade für Unternehmen mit begrenzten Ressourcen können diese Tools eine skalierbare Lösung für verschiedene Prozesse sein.

Vorsicht bei der Content Generierung!

Nachteile, Risiken und Herausforderungen

- Qualitätsrisiken: KI generierte Inhalte sind häufig generisch und können die nötige Tiefe oder Originalität vermissen lassen. Gerade bei komplexeren Themen kann dies zu einer Abwertung durch Google führen.

- Mangelnde E-E-A-T Konformität: KI Tools können keine Expertise, Autorität oder Vertrauenswürdigkeit nachweisen, die für Google zunehmend entscheidend sind. Bei Inhalten, die ausschließlich von KI erstellt werden, riskiert man, dass Google diese als minderwertig einstuft.

- Gefahr von Duplicate Content: Automatisch generierte Meta Descriptions oder Titles können ähnliche Formulierungen verwenden, was zu Duplicate-Content-Problemen führen kann.

Exkurs 3 - Intelligente Integration von KI-Tools

Best Practices im Umgang mit KI Tools

- Nutzung: Nur als Recherche- und Strukturierungswerkzeug

- Nutzung mit eigenen Inhalten: Die Integration eigener Datensätze in KI Tools ermöglicht präzisere, auf Ihren spezifischen Kontext zugeschnittene Analysen und Vorhersagen, sowie Generierung von Inhalten, da das System mit Ihren realen, branchenspezifischen und einzigartigen Informationen arbeitet statt mit generalisierten Daten, die im Prinzip allen Nutzern zur Verfügung stehen.

- Menschliche Überprüfung: Jeder KI generierte Inhalt sollte von einem Experten geprüft und, falls nötig, überarbeitet werden, um die inhaltliche Tiefe und die Relevanz für die Zielgruppe zu gewährleisten.

- Individuelle Anpassungen: Meta Descriptions und Titles sollten an die spezifische Suchintention der Zielgruppe und die Differenzierung vom Wettbewerb angepasst werden, statt ausschließlich auf KI Vorschläge zu vertrauen.

- Ergänzung durch datenbasierte Insights: Kombinieren Sie die KI-Tools mit Analysen aus HubSpot und anderen SEO-Tools, um sicherzustellen, dass Inhalte strategisch sinnvoll sind.

Es braucht hier unbedingt einen Prozess der Qualitätssicherung und eine redaktionelle Kontrolle!