OnPage-SEO durch Logfile-Analyse optimieren

Die Analyse von Logfiles ist ein wichtiger Bestandteil der Website-Optimierung für Suchmaschinen und LLMs. Durch die detaillierte Auswertung dieser Serverprotokolle lassen sich wertvolle Einblicke in das Verhalten von Suchmaschinen-Crawlern gewinnen.

Carsten Feller

Carsten Feller

Durch die Analyse der Access-Logs einer Website kann man mit etwas Hintergrundwissen technische SEO-Probleme identifizieren, die Crawling-Effizienz optimieren und letztendlich die Sichtbarkeit einer Website in den Suchergebnissen nachhaltig verbessern.

Wie genau funktionieren Logfiles und warum sind sie für SEO so wichtig? Ich erkläre Ihnen die Grundlagen der Logfile-Analyse und zeige, wie sie strategisch eingesetzt werden kann, um das volle SEO-Potenzial einer Website auszuschöpfen.

Was ist ein Logfile, in diesem Fall ein Access-Log?

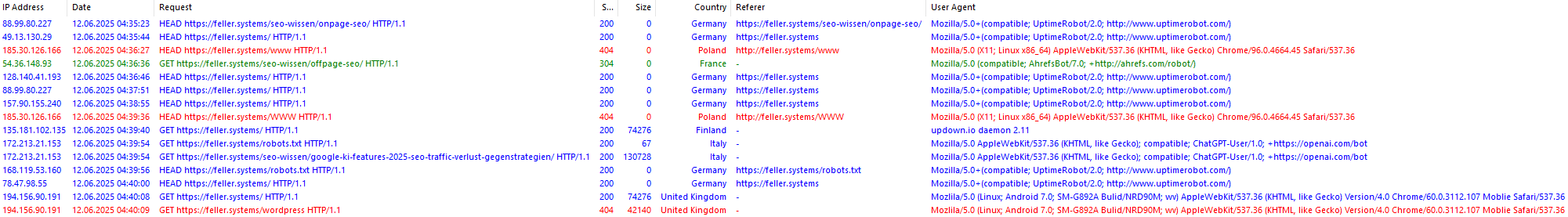

Ein Logfile, auch bekannt als Server-Logdatei oder Access-Log, ist eine automatisch erstellte Textdatei, die jede Aktivität auf einem Webserver protokolliert. Es zeichnet detailliert jeden Zugriff auf eine Website auf, unabhängig davon, ob dieser von einem menschlichen Besucher oder einem Suchmaschinen-Bot wie dem Googlebot stammt.

Unterscheidung Access Log / Error Log: Access Logs dokumentieren alle HTTP-Anfragen an den Server (einschließlich erfolgreicher Requests und Crawler-Aktivitäten), während Error Logs ausschließlich Server-Fehler, Warnungen und Probleme aufzeichnen - für SEO-Analysen ist das Access Log primär relevant, da es das vollständige Crawler-Verhalten zeigt.

Ein Beispiel für einen anonymisierten Log-Eintrag:

000.000.000.000 - - [11/Jul/2017:08:04:41 +0200] "GET /logo.jpg HTTP/1.0" 200 285 "https://www.beispiel.de/" "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"Ein typischer Logfile-Eintrag enthält folgende Informationen:

- IP-Adresse: Die Adresse des Clients (Besucher oder Bot), der die Anfrage gestellt hat

- Zeitstempel: Der genaue Zeitpunkt des Zugriffs.

- Angeforderte URL: Die spezifische Seite oder Ressource, die angefordert wurde.

- HTTP-Statuscode: Der Code, der die Antwort des Servers auf die Anfrage beschreibt (z. B. 200 für "OK", 404 für "Nicht gefunden").

- Übertragene Datenmenge: Die Größe der übertragenen Daten in Byte.

- User-Agent-String: Informationen über den verwendeten Browser oder Bot.

- Referrer-URL: Die interne oder externe Seite, von der der Besucher kam (falls vorhanden).

Logfiles sind für die Suchmaschinenoptimierung (SEO) von erheblichem Wert, da sie einen direkten und ungefilterten Einblick in das Verhalten der Suchmaschinen-Crawler auf einer Website bieten.

Im Gegensatz zu Tools wie Google Analytics oder der Google Search Console, die aggregierte oder gefilterte Daten liefern, erfassen Logfiles jede einzelne Interaktion in Echtzeit. Dies ermöglicht eine detaillierte Analyse, die mit anderen Tools nicht möglich wäre.

Die Bedeutung von Logfiles für SEO

Wir bekommen einen unmittelbaren, teilweise sogar live und in Echtzeit, Eindruck davon, was innerhalb unserer Webprojekte passiert.:

- Verständnis des Crawling-Verhaltens: Welche Seiten werden von Suchmaschinen wie oft besucht? Werden wichtige Inhalte priorisiert?

- Identifizierung von Crawling-Problemen: Gibt es Seiten, die nicht oder nur selten gecrawlt werden? Gibt es Faktoren, die das Crawling behindern?

- Optimierung des Crawl-Budgets: Werden Ressourcen durch das Crawlen unwichtiger Seiten verschwendet? Kann das Crawl-Budget im SEO effizienter eingesetzt werden?

- Aufdeckung technischer SEO-Probleme: Treten häufig 404-Fehler, Serverfehler oder andere Statuscodes auf, die die Nutzererfahrung und das Crawling beeinträchtigen?

- Überwachung der Indexierungsgeschwindigkeit: Wie schnell werden neue Inhalte von Suchmaschinen erfasst und indexiert?

- Verifizierung von Bot-Aktivitäten: Handelt es sich bei den Bots tatsächlich um legitime Suchmaschinen-Crawler oder um schädliche Imitationen?

Bei umfangreichen Websites mit einer großen Anzahl von Seiten ist die Logfile-Analyse hilfreich, um das volle SEO-Potenzial auszuschöpfen. Sie hilft, die Seitenarchitektur zu optimieren, sicherzustellen, dass wichtige Inhalte effizient gecrawlt und indexiert werden, und technische Fehler zu beheben, die die Sichtbarkeit in den Suchergebnissen beeinträchtigen könnten.

Herausforderungen bei der Logfile-Analyse

Die Logfile-Analyse bietet wertvolle Einblicke, es gibt aber auch einige Herausforderungen, die in der Praxis bewältigt werden müssen:

- Datenmenge: Logfiles können sehr schnell sehr groß werden und mehrere Gigabyte an Daten umfassen. Dies erfordert spezielle Tools und Techniken zur Verarbeitung und Analyse.

- Technisches Know-how: Die Interpretation der Rohdaten erfordert ein fundiertes technisches Verständnis und Erfahrung in der SEO-Analyse.

- Zugriff: Nicht alle Hosting-Anbieter gewähren einen einfachen und direkten Zugriff auf die Logfiles.

- Datenschutz: Bei der Analyse von Logfiles müssen die geltenden Datenschutzbestimmungen beachtet werden, insbesondere im Hinblick auf personenbezogene Daten wie IP-Adressen.

Trotz dieser Herausforderungen und einer, für die meisten Anwender, recht steilen Lernkurve, bietet die Logfile-Analyse einzigartige und unverzichtbare Einblicke für eine umfassende technische Optimierung. Sie ermöglicht es, datenbasierte Entscheidungen zu treffen und die Sichtbarkeit in Suchmaschinen nachhaltig zu verbessern.

Durch die Identifizierung und Behebung technischer Probleme, die Optimierung des Crawling-Verhaltens und die Überwachung der Indexierungsgeschwindigkeit können wir sicherstellen, dass unsere Websites optimal für Suchmaschinen zugänglich sind.

Logfile-Analyse: Für SEO relevante Methoden und Tools

Wie stellen wir diese große Menge an wertvollen Daten nun dar und analysieren sie effektiv und effizient? Ich stelle Ihnen einige Methoden und Tools vor, die für diesen Zweck zur Verfügung stehen.

Die Art und Weise, wie ein Hosting-Anbieter den Zugriff auf Logfiles gestaltet, kann als Indikator für die technische Flexibilität und Kontrolle gewertet werden, die dem Website-Betreiber zur Verfügung steht. Ein unkomplizierter und direkter Zugriff auf Roh-Logfiles, nicht nur auf bereits aufbereitete Statistiken, ist für eine detaillierte und aussagekräftige SEO-Analyse sehr wichtig. Hoster, die diesen Zugriff erschweren, nur stark limitierte Daten bereitstellen oder für den Zugriff auf bestimmte Log-Typen zusätzliche Gebühren erheben, schränken die Analysemöglichkeiten des Webmasters ein. Die Möglichkeit, Logfile-Einstellungen wie Anonymisierungsoptionen, Speicherformate oder die Aufbewahrungsdauer direkt serverseitig zu beeinflussen, zeugt von einem höheren Grad an technischer Souveränität, die das jeweilige Hosting-Paket bietet. Für SEO-bewusste Projekte kann die Handhabung des Logfile-Zugriffs somit ein relevantes Kriterium bei der Auswahl des Hosting-Anbieters darstellen.

Vorbereitung der Logfile-Analyse

Bevor Sie mit der eigentlichen Analyse beginnen, sind einige vorbereitende Schritte erforderlich, um sicherzustellen, dass die Daten korrekt und aussagekräftig sind:

- Datenzugriff sicherstellen: In Zusammenarbeit mit dem Hosting-Anbieter oder dem IT-Team muss ein regelmäßiger und zuverlässiger Zugriff auf die Logfiles gewährleistet werden.

- Datenbereinigung: Irrelevante Einträge, wie beispielsweise interne Zugriffe von Mitarbeitern oder Zugriffe bekannter Spam-Bots, sollten herausgefiltert werden, um die Analyse zu vereinfachen und zu präzisieren.

- Bot-Verifizierung: Um sicherzustellen, dass die analysierten Daten von echten Suchmaschinen-Bots stammen, sollte ein Reverse-DNS-Lookup durchgeführt werden, um diese von potenziellen Imitationen zu unterscheiden.

Kernmethoden der Logfile-Analyse für SEO

Die folgenden Analysemethoden sollten im Zentrum der Logfile-Analyse für SEO stehen:

- Crawl-Frequenz-Analyse: Diese Analyse identifiziert, welche Seiten wie oft von Suchmaschinen-Bots besucht werden. Sie gibt Aufschluss darüber, wie Google die Inhalte priorisiert und welche Seiten möglicherweise vernachlässigt werden.

- Crawl-Tiefe-Untersuchung: Die Untersuchung der Crawl-Tiefe zeigt, wie tief Suchmaschinen-Bots in die Seitenstruktur einer Website eindringen. Dies kann Hinweise auf Probleme in der Informationsarchitektur geben, beispielsweise wenn wichtige Seiten nicht ausreichend verlinkt sind.

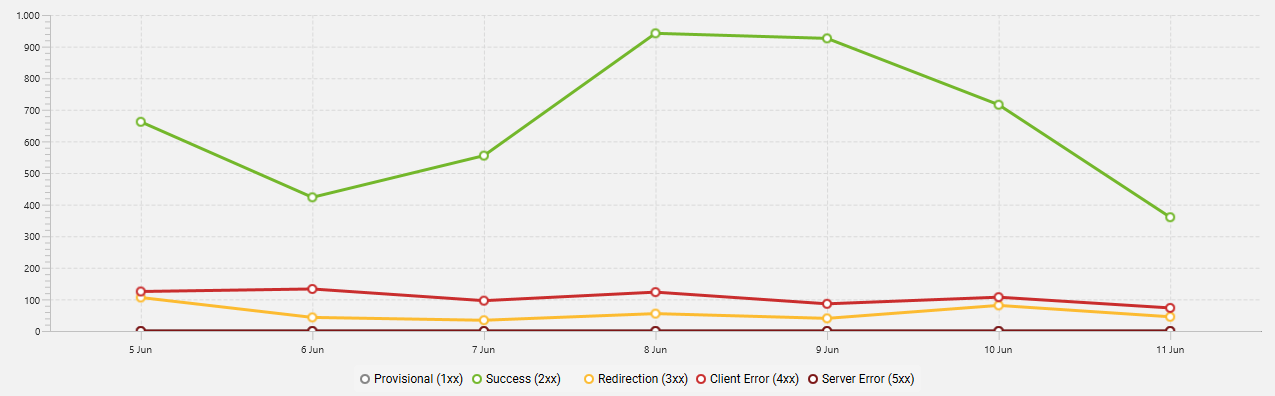

- Statuscode-Auswertung: Die Analyse der Häufigkeit verschiedener HTTP-Statuscodes, wie z.B. 404-Fehler (Nicht gefunden) oder 500-Fehler (Serverfehler), deckt technische Probleme auf, die das Crawling und die Nutzererfahrung beeinträchtigen können.

- Crawl-Budget-Optimierung: Diese Methode identifiziert Seiten, die unverhältnismäßig oft gecrawlt werden, aber wenig SEO-Wert haben. Durch die Optimierung des Crawl-Budgets können Ressourcen auf wichtigere Seiten konzentriert werden.

Eine oft unterschätzte Komplexitätsfalle bei der Logfile-Analyse sind fragmentierte Logdaten. Moderne Web-Architekturen setzen häufig auf Content Delivery Networks (CDNs) und verteilte Server-Systeme, um die Performance und Ausfallsicherheit zu erhöhen. Wenn Logfiles auf diesen verschiedenen Systemen - dem Ursprungsserver und den CDN-Knoten - getrennt voneinander gespeichert werden, müssen sie für eine vollständige und akkurate Analyse erst mühsam zusammengeführt und konsolidiert werden. Dieser Prozess erhöht nicht nur den manuellen Aufwand erheblich, sondern birgt auch das Risiko von Datenlücken oder Fehlinterpretationen, falls nicht alle relevanten Log-Quellen berücksichtigt und korrekt synchronisiert werden. Die Notwendigkeit, Logdaten aus unterschiedlichen Quellen zu kompilieren, kann die Komplexität der Logfile-Analyse signifikant steigern und erfordert eine sorgfältige Planung und Ausführung.

Fortgeschrittene Analysetechniken

Für tiefere Einblicke in das Crawling-Verhalten und die Website-Performance können die folgenden fortgeschrittenen Analysetechniken angewendet werden:

- Crawl-Muster-Erkennung: Die Untersuchung, ob es zeitliche Muster im Crawling-Verhalten gibt, die auf Indexierungszyklen hindeuten, kann helfen, die Effektivität der SEO-Strategie besser zu verstehen.

- Bot-Vergleichsanalyse: Der Vergleich des Verhaltens verschiedener Suchmaschinen-Bots (z.B. Google, Bing, Yandex) auf einer Website kann Aufschluss darüber geben, wie unterschiedliche Suchmaschinen die Inhalte bewerten.

- Ressourcen-Crawling-Analyse: Die Überprüfung, ob wichtige Ressourcen wie CSS- oder JavaScript-Dateien regelmäßig gecrawlt werden, ist entscheidend, um sicherzustellen, dass Suchmaschinen die Website korrekt darstellen und interpretieren können.

Tools für die Logfile-Analyse

Es gibt eine Vielzahl von Tools für die Logfile-Analyse, die sich in ihren Funktionen, ihrer Benutzerfreundlichkeit und ihrem Preis unterscheiden. Hier ein detaillierterer Blick auf einige der wichtigsten Lösungen:

Wer programmieren kann oder entsprechende Ressourcen einkauft, ist hier, wie auch in vielen anderen Bereichen der Suchmaschinenoptimierung, klar im Vorteil. Alle unten beschriebenen "fertigen" Lösungen zwingen dem Anwender einen bestimmten Workflow auf bzw. bieten jeweils unterschiedliche, aber festgelegte Reportings, die sich nicht unbedingt weiter anpassen lassen. Eine Software-Lösung, die speziell auf die eigenen, oder die Bedürfnisse Ihrer Kunden zugeschnittenen ist, wird aber immer wesentlich bessere und für den Anwendungszweck sinnvollere Ergebnisse produzieren. Positivbeispiel: Der Screaming Frog Log File Analyser z. B. stammt von einer SEO Agentur und ist schon auf die Bedürfnisse von Suchmaschinenoptimierern ausgerichtet.

Screaming Frog Log File Analyser

Vorteile: Der Screaming Frog Log File Analyser ist benutzerfreundlich, speziell für SEO-Zwecke entwickelt und bietet gute Visualisierungen der Daten. Es lassen sich zusätzlich CSV oder Excel Dateien aus anderen SEO Tools wie dem Screaming Frog SEO Spider oder Majestic u. a. importieren und mit den Logdaten vergleichen. So lassen sich schnell URLs identifizieren, die in den Access Logs vorhanden, aber z. B. nicht durch Menüs oder intern verlinkt werden = verwaiste Seiten. Das Tool ermöglicht es SEO-Experten, schnell wichtige Erkenntnisse zu gewinnen und Probleme zu identifizieren.

Nachteile: Das Tool ist kostenpflichtig und kann bei sehr großen Logfiles an seine Grenzen stoßen.

ELK Stack (Elasticsearch, Logstash, Kibana)

Vorteile: Der ELK Stack ist eine hochskalierbare und flexibel anpassbare Open-Source-Lösung, die Echtzeit-Analysen ermöglicht. Er eignet sich besonders gut für große Websites mit komplexen Anforderungen.

Nachteile: Die Einrichtung und Konfiguration des ELK Stack ist ziemlich komplex und erfordert technisches Know-how.

Google BigQuery

Vorteile: Google BigQuery ist ein cloudbasierter Datenspeicher und Analysedienst, der die Verarbeitung enormer Datenmengen ermöglicht. Er ist eng in andere Google-Tools integriert und bietet leistungsstarke SQL-Funktionen.

Nachteile: Die Nutzung von Google BigQuery kann bei großen Datenmengen kostspielig werden. Zudem sind SQL-Kenntnisse erforderlich, um die Daten effektiv zu analysieren.

R oder Python mit spezialisierten Bibliotheken

Hier wird es richtig interessant! Das ist leider nichts für Anfänger, die Möglichkeiten sind aber fast grenzenlos.

Vorteile: Die Verwendung von Programmiersprachen wie R oder Python mit spezialisierten Bibliotheken bietet maximale Flexibilität und ermöglicht die Erstellung benutzerdefinierter Analysen. Diese Option ist kostenlos und ideal für SEO-Experten mit Programmierkenntnissen.

Nachteile: Die Implementierung erfordert Programmierkenntnisse und einen höheren Zeitaufwand.

HTTP Logs Viewer (früher Apache Logs Viewer)

Vorteile: Solides, einfach zu bedienendes Tool, gut für die gröberen Überblicke geeignet.

Nachteile: Wird relativ selten aktualisiert, überwiegend festgelegte Reportings, sehr altbackene Optik.

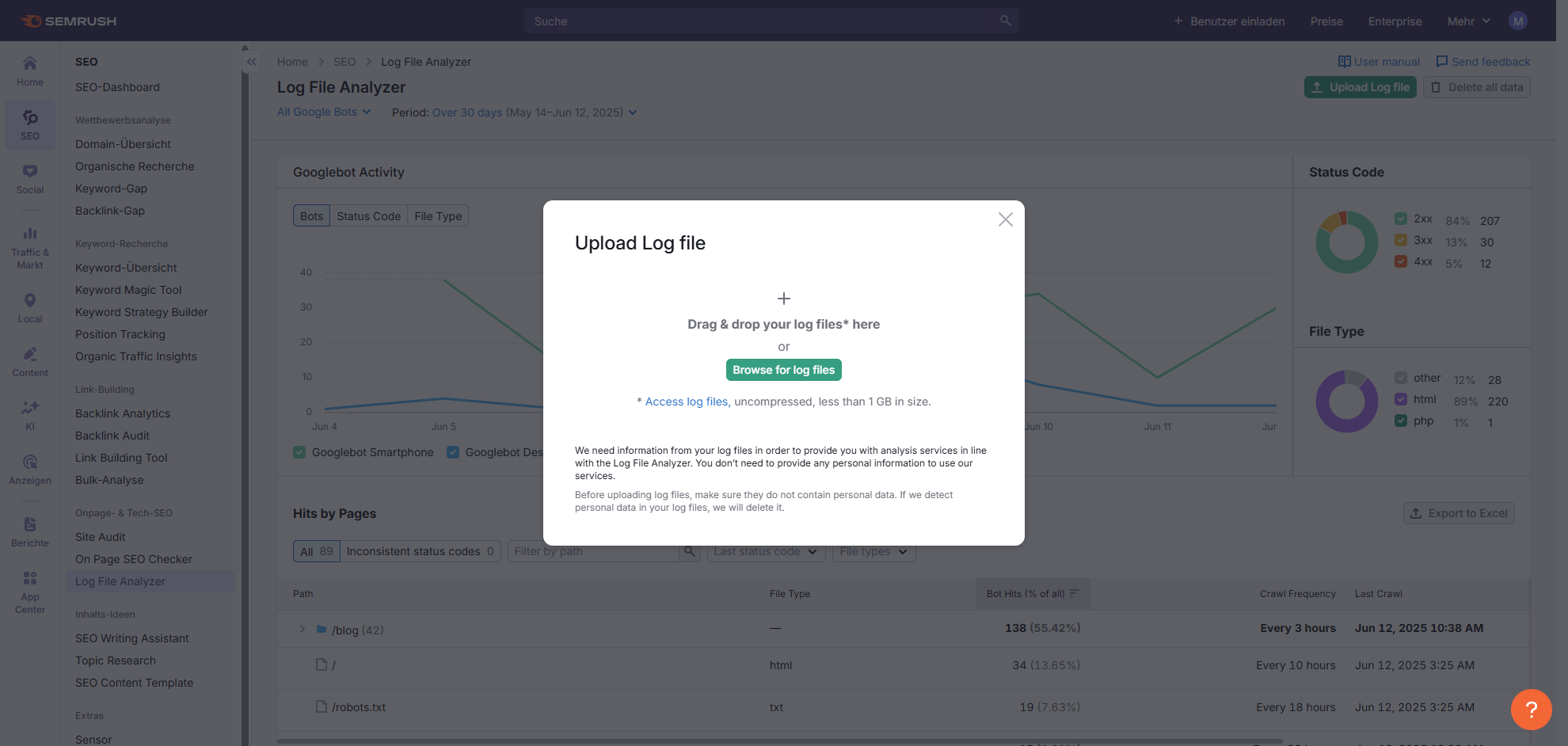

Semrush Log File Analyzer

Vorteile: Teil der Semrush Suite, es fallen keine Extrakosten an. Verarbeitet Logfiles bis 1 GB. Zeigt sofort und übersichtlich wichtige Kennzahlen wie den Status-Code, die Crawl Frequenz und den Zeitpunkt des letzten Zugriffs. Einfacher Export nach Excel.

Nachteile: Berücksichtigt nur Googlebot Smartphone und Googlebot Desktop. Es gibt keine weitergehenden Analysen, die Auswertung ist immer nur für eine Website möglich.

Semrush weist beim Upload zwar darauf hin, aber hier nochmal und das gilt für alle Dienste, die nicht lokal auf ihrer eigenen Infrastruktur laufen: Achten Sie darauf, dass die Access Logs, die Sie an Drittanbieter übermitteln, keine persönlichen Daten enthalten.

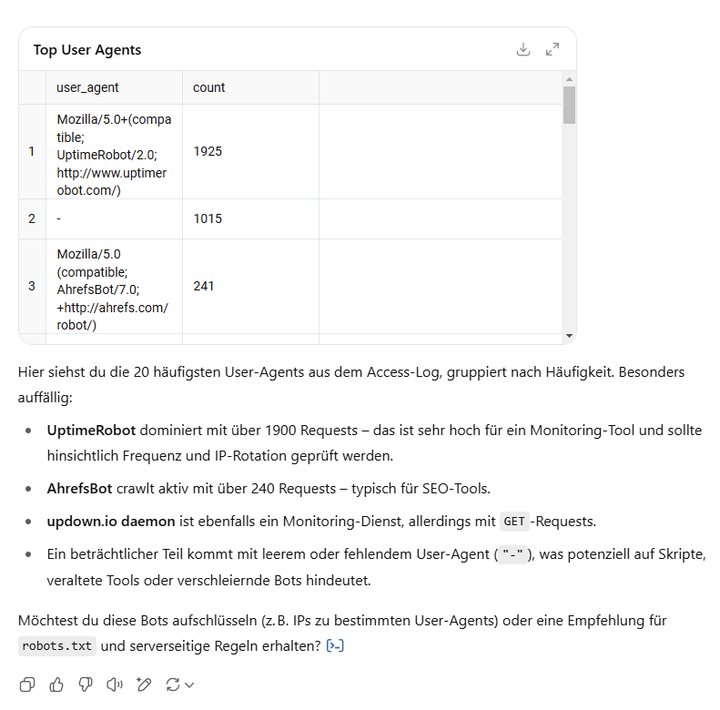

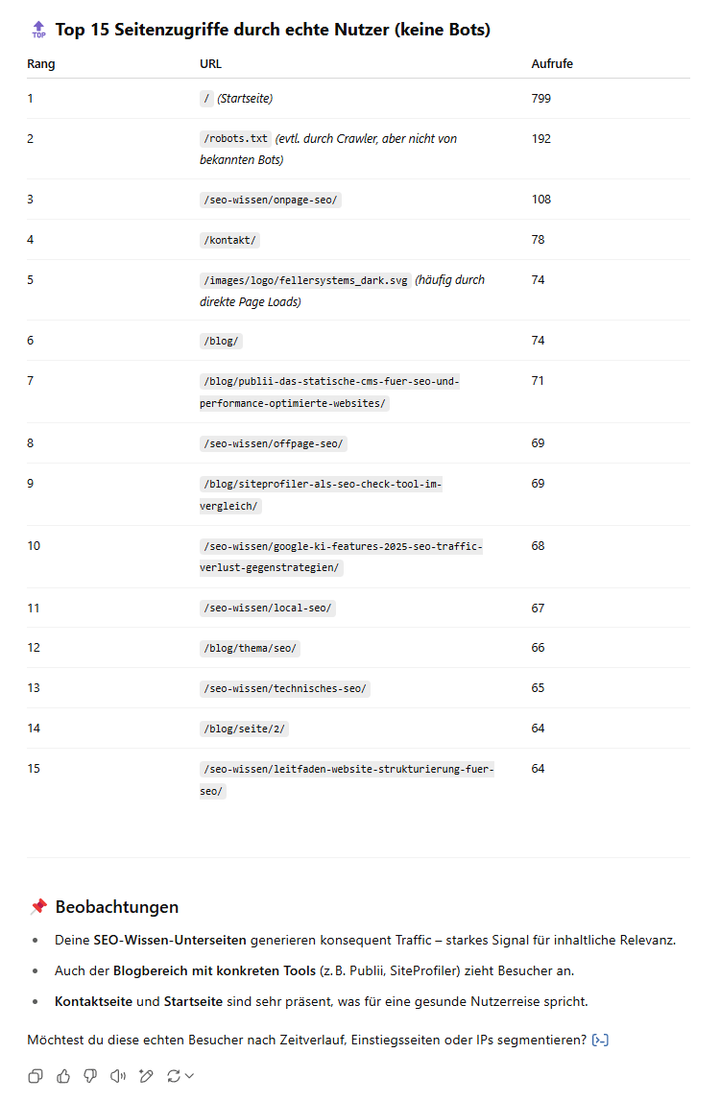

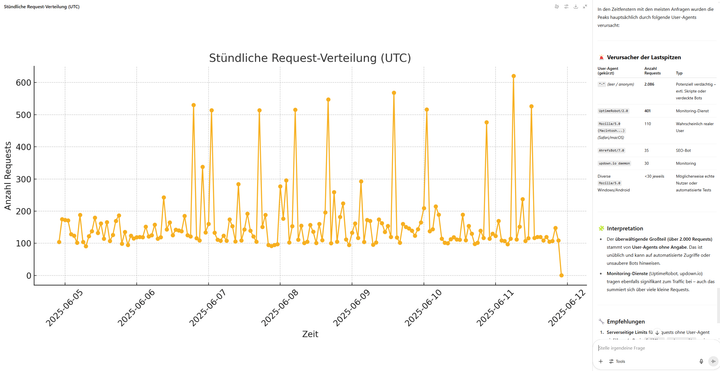

Exkurs: Loganalyse mit ChatGPT

Füttern Sie doch einfach mal das LLM Ihres Vertrauens mit den Access-Logs ihrer Webpräsenz.

ChatGPT akzeptiert .zip, .tar.gz oder .tar.bz2 Dateien, bis zu 100 MB pro Upload in standardisierten Formaten wie "Common" oder "Combined Log".

Mit dem entsprechenden Prompting lassen sich dort ebenfalls Analysen fahren, ganz ohne zusätzliche Software. Ob das vom Ergebnis her ausreicht, muss jeder selbst entscheiden.

Bitte beachten: Ein LLM ist ein Sprachmodell, das auf maschinellem Lernen basiert und implizit semantische und linguistische Muster aus großen Textdatenmengen extrahiert, verarbeitet und davon "lernt". Genauso wenig, wie es ein LLM bis zum heutigen Tage schafft, Page Titles und Meta Descriptions korrekt innerhalb von Googles Zeichenbegrenzung zu erzeugen, werden auch nicht alle Bots korrekt als solche erkannt oder User Agents immer richtig interpretiert. Aber was noch nicht ist, kann ja noch werden...

Integration der Logfile-Analyse in den SEO-Workflow

Um den maximalen Nutzen aus der Logfile-Analyse zu ziehen, sollte sie regelmäßig durchgeführt und vorzugsweise auch eng mit anderen SEO-Maßnahmen verknüpft werden:

- Die Erkenntnisse aus Logfiles sollten mit Daten aus der Google Search Console und Google Analytics kombiniert werden, um ein umfassendes Bild der Website-Performance zu erhalten.

- Logfile-Daten können verwendet werden, um die Effektivität von technischen SEO-Maßnahmen zu messen und den Erfolg von Optimierungsmaßnahmen zu überprüfen.

- Die Erstellung automatisierter Berichte, die regelmäßig über kritische Metriken informieren, hilft, den Überblick zu behalten und schnell auf Probleme zu reagieren.

- Die aus der Logfile-Analyse gewonnenen Erkenntnisse sollten verwendet werden, um die Crawl-Optimierungsstrategie kontinuierlich anzupassen und zu verbessern.

Die Logfile-Analyse ist insgesamt ein leistungsstarkes Werkzeug für SEOs. Sie ermöglicht tiefe Einblicke in das Verhalten von Suchmaschinen auf einer Website und hilft, technische Optimierungen präzise und datenbasiert umzusetzen.

Durch die richtige Kombination von Methoden und Tools kann sichergestellt werden, dass eine Website optimal für Suchmaschinen zugänglich und indexierbar ist, was zu einer verbesserten Sichtbarkeit und mehr organischem Traffic führt.

Bitte immer daran denken: Ohne solide technische Grundlage verpuffen alle weiteren Optimierungen an Content oder Usability!

Wie können nun die gewonnenen Erkenntnisse konkret genutzt werden, um die Effizienz des Crawlings zu verbessern?

Crawling-Effizienz optimieren: Erkenntnisse aus der Logfile-Analyse

Nach den Grundlagen der Logfile-Analyse und ihre Bedeutung für SEO dargelegt, richte ich nun den Fokus darauf, wie diese Erkenntnisse genutzt werden können, um die Crawling-Effizienz einer Website zu optimieren. Dies ist ein entscheidender Schritt, um sicherzustellen, dass Suchmaschinen die Website effektiv durchsuchen und indexieren können, was wiederum die Sichtbarkeit in den Suchergebnissen verbessert.

Identifizierung von Crawling-Mustern

Die Logfile-Analyse ermöglicht es, detaillierte Crawling-Muster zu erkennen, die Aufschluss über die Priorisierung der Inhalte durch Suchmaschinen geben:

- Crawl-Frequenz nach Seitentyp: Die Untersuchung, ob bestimmte Seitentypen (z.B. Produktseiten, Blogbeiträge, Kategorieseiten) häufiger gecrawlt werden als andere, hilft, die Inhaltsstrategie zu optimieren und sicherzustellen, dass wichtige Seiten priorisiert werden.

- Zeitliche Muster: Die Identifizierung von Tageszeiten oder Wochentagen, an denen das Crawling besonders intensiv ist, kann helfen, Serverressourcen optimal zu planen und Lastspitzen zu vermeiden.

- Crawl-Tiefe: Die Analyse, wie tief Suchmaschinen-Bots in die Seitenstruktur einer Website vordringen, gibt Aufschluss darüber, ob alle wichtigen Seiten erreichbar sind und ob die interne Verlinkung effektiv ist.

Diese Erkenntnisse helfen dabei, die Seitenarchitektur und die interne Verlinkung so anzupassen, dass wichtige Seiten leichter erreichbar sind und unwichtige Seiten weniger Ressourcen verbrauchen.

Optimierung des Crawl-Budgets

Das Crawl-Budget, also die Ressourcen, die Suchmaschinen für das Crawlen einer Website aufwenden, ist begrenzt. Die Logfile-Analyse hilft, dieses Budget effektiver zu nutzen und sicherzustellen, dass die wichtigsten Seiten gecrawlt werden:

- Identifizierung von Crawl-Verschwendung: Durch das Auffinden von Seiten, die häufig gecrawlt werden, aber keinen SEO-Wert haben (z.B. alte Versionen, Testseiten, unwichtige Archivseiten), können Ressourcen freigesetzt werden, die für wichtigere Seiten genutzt werden können.

- Priorisierung wichtiger Seiten: Es muss sichergestellt werden, dass SEO-relevante Seiten, wie z.B. Produktseiten oder Blogbeiträge mit relevanten Keywords, häufiger gecrawlt werden als unwichtige Seiten.

- Optimierung der robots.txt: Die robots.txt-Datei kann gezielt angepasst werden, um unwichtige Bereiche vom Crawling auszuschließen und sicherzustellen, dass Suchmaschinen ihre Ressourcen auf die wichtigsten Inhalte konzentrieren.

Das Google Crawl Budget wird typischerweise erst bei größeren Websites mit mehreren tausend Seiten (ab circa 10.000 Seiten) zu einem relevanten Faktor, da Google bei kleineren Websites meistens alle Seiten crawlen kann. Besonders kritisch wird das Crawl Budget bei sehr großen Websites mit 100.000+ Seiten oder bei Seiten mit häufigen Content-Updates, wo eine strategische Priorisierung der wichtigsten Inhalte erforderlich wird.

Verbesserung der Indexierungsgeschwindigkeit

Die Logfile-Analyse kann auch genutzt werden, um die Geschwindigkeit zu erhöhen, mit der neue oder aktualisierte Inhalte von Suchmaschinen indexiert werden:

- Analyse der Indexierungslatenz: Die Messung der Zeit zwischen der Veröffentlichung eines neuen Inhalts und dem ersten Crawl durch Suchmaschinen gibt Aufschluss darüber, wie schnell neue Inhalte erfasst werden.

- Optimierung interner Links: Die interne Verlinkung zu neuen Inhalten sollte basierend auf den Crawling-Mustern optimiert werden, um sicherzustellen, dass Suchmaschinen diese schnell finden und indexieren.

- Einsatz von XML-Sitemaps: Die Überprüfung, ob Seiten, die in der XML-Sitemap enthalten sind, schneller gecrawlt werden, und die entsprechende Anpassung der Sitemap kann die Indexierungsgeschwindigkeit verbessern.

Technische SEO-Probleme aufdecken und beheben

Die Logfile-Analyse ist ein mächtiges Werkzeug, um technische SEO-Probleme zu identifizieren, die das Crawling und die Indexierung einer Website beeinträchtigen können:

- Statuscode-Analyse: Die Untersuchung häufiger 4xx- oder 5xx-Fehler und deren Behebung sollte priorisiert werden, da diese Fehler das Crawling behindern und die Nutzererfahrung beeinträchtigen können.

- Redirect-Ketten: Lange Weiterleitungsketten, bei denen eine Seite auf eine andere weiterleitet, die wiederum auf eine dritte Seite weiterleitet, können das Crawling verlangsamen und sollten vermieden werden.

- Ressourcen-Blockierung: Es muss überprüft werden, ob wichtige CSS- oder JavaScript-Dateien versehentlich durch die robots.txt-Datei oder andere Mechanismen blockiert werden, da dies die Darstellung und Funktionalität der Website beeinträchtigen kann.

Fortgeschrittene Optimierungstechniken

Für erfahrene SEO-Experten bietet die Logfile-Analyse noch tiefergehende Optimierungsmöglichkeiten, die über die grundlegenden Maßnahmen hinausgehen:

- Bot-spezifische Optimierung: Die Strategie kann basierend auf dem Verhalten verschiedener Suchmaschinen-Bots (z.B. Google, Bing, Yandex) angepasst werden, um die spezifischen Anforderungen jeder Suchmaschine zu erfüllen.

- Lastverteilung: Erkenntnisse über Crawling-Spitzen können genutzt werden, um Serverressourcen optimal zu verteilen und sicherzustellen, dass die Website auch bei hoher Last schnell und zuverlässig erreichbar ist.

- A/B-Testing für Crawling: Es können Experimente mit verschiedenen Seitenstrukturen und internen Verlinkungsstrategien durchgeführt werden, um deren Einfluss auf das Crawling-Verhalten zu messen und die effektivste Struktur zu ermitteln.

Integration mit anderen SEO-Datenquellen

Um den maximalen Nutzen aus der Logfile-Analyse zu ziehen, sollten die Erkenntnisse mit anderen SEO-Datenquellen kombiniert werden, um ein umfassendes Bild der Website-Performance zu erhalten:

- Google Search Console: Die Crawling-Daten aus den Logfiles sollten mit dem Indexierungsstatus und der Suchleistung in der Google Search Console verglichen werden, um potenzielle Probleme zu identifizieren und die Effektivität der SEO-Maßnahmen zu überprüfen.

- Analytics-Daten: Die Crawling-Häufigkeit sollte mit dem tatsächlichen Nutzerverhalten und den Conversion-Raten korreliert werden, um zu verstehen, welche Seiten nicht nur von Suchmaschinen, sondern auch von Nutzern als wertvoll erachtet werden.

- On-Page-SEO-Faktoren: Es sollte untersucht werden, ob gut optimierte Seiten mit relevanten Keywords und hochwertigem Content häufiger gecrawlt werden als weniger gut optimierte Seiten.

Durch die gezielte Optimierung der Crawling-Effizienz basierend auf den Erkenntnissen aus der Logfile-Analyse kann sichergestellt werden, dass die wichtigsten Inhalte schnell und regelmäßig von Suchmaschinen erfasst werden. Dies legt den Grundstein für eine verbesserte Sichtbarkeit in den Suchergebnissen, mehr organischen Traffic und eine effektivere Nutzung des SEO-Potenzials.

Als nächstes folgt nun ein Abschnitt über die Identifizierung und Behebung technischer SEO-Probleme mithilfe von Logfiles.

Identifizierung und Behebung von technischen SEO-Problemen

Es bieten sich hier bestimmte Einblicke, die über die Möglichkeiten herkömmlicher SEO-Tools hinausgehen und es ermöglichen, subtile Probleme aufzudecken, die die Website-Performance beeinträchtigen können.

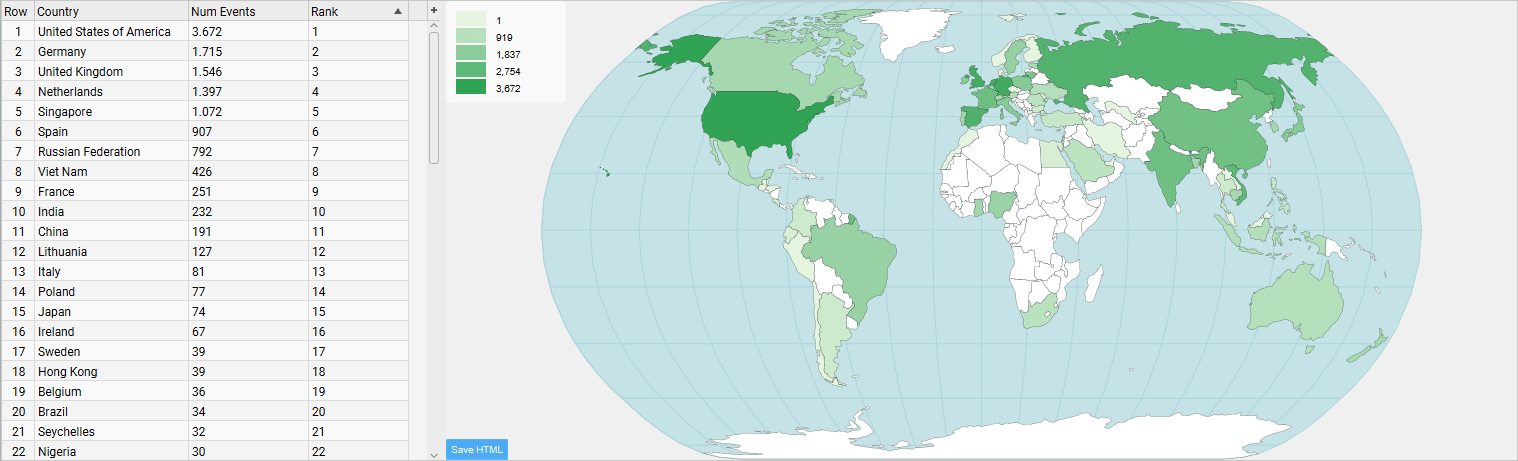

Kurze Zwischenfrage: Erhält Ihre Website eigentlich die meisten Zugriffe aus der für Sie wichtigsten Zielregion?

Erkennung von Indexierungsproblemen

Wie bereits erwähnt, zeigt die Logfile-Analyse das tatsächliche Crawling-Verhalten von Suchmaschinen. Dies ermöglicht es, subtile Indexierungsprobleme zu erkennen, die mit anderen Tools möglicherweise übersehen werden:

- Orphan Pages: Seiten, die nicht intern verlinkt sind, aber dennoch von Suchmaschinen gefunden werden. Diese können durch alte externe Links, fehlerhafte Sitemaps oder andere Quellen entstehen und sollten identifiziert und entweder in die interne Verlinkung integriert oder entfernt werden.

- Überindexierung: Die Erkennung von Bereichen einer Website, die unverhältnismäßig oft gecrawlt werden, obwohl sie wenig SEO-Wert haben, hilft, das Crawl-Budget zu optimieren und Ressourcen auf wichtigere Seiten zu konzentrieren.

- Unterindexierung: Die Identifizierung wichtiger Seiten, die seltener gecrawlt werden als erwartet, ermöglicht es, die interne Verlinkung und die Seitenarchitektur zu verbessern, um sicherzustellen, dass diese Seiten von Suchmaschinen besser gefunden und indexiert werden.

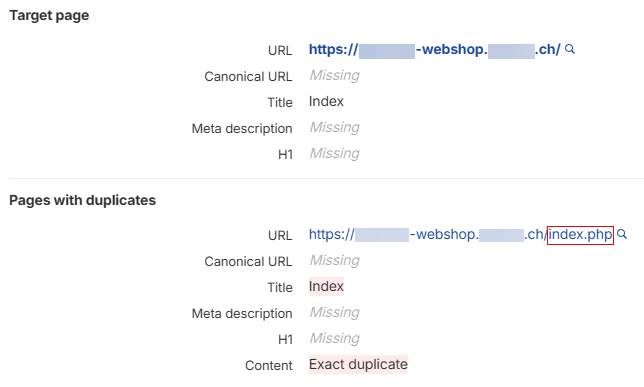

Aufdeckung von Duplicate Content

Duplicate Content, also doppelter Inhalt, ist ein häufiges Problem, das die SEO-Leistung einer Website beeinträchtigen kann. Die Logfile-Analyse hilft bei der Erkennung verschiedener Formen von Duplicate Content:

- URL-Variationen: Die Erkennung, wenn dieselbe Seite unter verschiedenen URLs gecrawlt wird (z.B. mit und ohne abschließenden Schrägstrich, mit "www" und ohne "www"), ermöglicht es, Canonical-Tags zu implementieren oder 301-Weiterleitungen einzurichten, um Suchmaschinen auf die bevorzugte Version der Seite hinzuweisen.

- Parameterbasierter Duplicate Content: Die Identifizierung, wenn Seiten mit unterschiedlichen URL-Parametern (z.B. für Tracking oder Sortierung) als separate Inhalte gecrawlt werden, ermöglicht es, diese Parameter in der Google Search Console zu konfigurieren oder Canonical-Tags zu verwenden, um Duplicate Content zu vermeiden.

- Fehlerhafte Canonical-Implementierung: Die Überprüfung, ob trotz gesetzter Canonical-Tags alle Varianten einer Seite gecrawlt werden, deutet auf eine fehlerhafte Implementierung hin, die behoben werden muss, um sicherzustellen, dass Suchmaschinen die richtigen Seiten indexieren.

Analyse von Serverantworten und Ladezeiten

Die Logfile-Analyse bietet tiefe Einblicke in die serverseitige Performance einer Website, die direkte Auswirkungen auf das SEO hat:

- Häufige 5xx-Fehler: Die Identifizierung von Serverproblemen, die das Crawling behindern können, ist entscheidend, um sicherzustellen, dass Suchmaschinen auf alle wichtigen Seiten zugreifen können.

- Langsame Serverantwortzeiten: Die Erkennung von Seiten oder Ressourcen, die besonders lange Ladezeiten aufweisen und das Crawl-Budget verschwenden, ermöglicht es, Performance-Optimierungen vorzunehmen, um die Nutzererfahrung und das Crawling zu verbessern.

- Fehlerhafte Weiterleitungen: Das Aufdecken von Redirect-Loops (Weiterleitungsschleifen) oder langen Weiterleitungsketten, die das Crawling ineffizient machen, ermöglicht es, diese zu beheben und die Website-Architektur zu optimieren.

Achtung: Standard Access Logs enthalten keine Client- oder Serverseitigen Ladezeiten.

Ein erweiterter Eintrag könnte so aussehen:

192.168.1.100 - - [13/Jun/2025:10:30:45 +0200] "GET /products/laptop.html HTTP/1.1" 200 15234 "https://example.com/search" "Mozilla/5.0..." 0.245Der letzte Eintrag "0.245" ist in diesem Fall die Server-Response-Time.

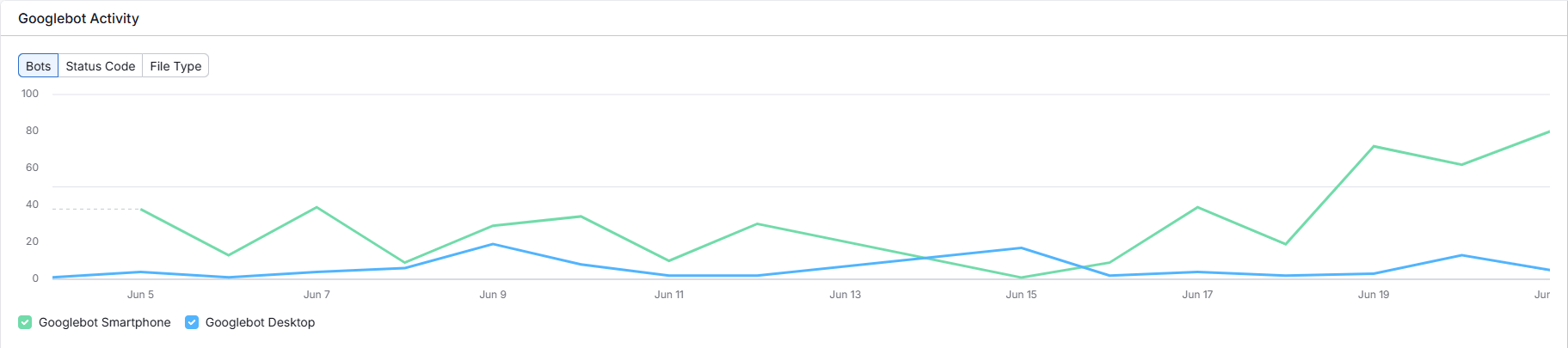

Mobile-First-Indexierung überprüfen

Mit der zunehmenden Bedeutung der Mobile-First-Indexierung ist es wichtig, das Crawling-Verhalten für mobile User-Agents zu analysieren und sicherzustellen, dass die Website für mobile Geräte optimiert ist:

- Mobile vs. Desktop Crawling: Der Vergleich der Häufigkeit und Tiefe des Crawlings zwischen mobilen und Desktop-Bots gibt Aufschluss darüber, wie Google die mobile Version der Website bewertet.

- Ressourcenzugriff: Es muss sichergestellt werden, dass mobile Bots auf alle wichtigen Ressourcen zugreifen können, insbesondere bei dynamischem Rendering, bei dem Inhalte erst im Browser geladen werden.

- AMP-Implementierung: Die Überprüfung, ob AMP-Seiten (Accelerated Mobile Pages) korrekt gecrawlt und mit ihren kanonischen Gegenstücken verknüpft werden, ist wichtig, um die mobile Performance zu verbessern und von den Vorteilen von AMP zu profitieren.

Behebung identifizierter Probleme

Basierend auf den Erkenntnissen aus der Logfile-Analyse können gezielte Maßnahmen ergriffen werden, um die identifizierten technischen SEO-Probleme zu beheben:

- Optimierung der Seitenarchitektur: Die interne Verlinkung zu unterindizierten Seiten sollte verbessert werden, um sicherzustellen, dass diese Seiten von Suchmaschinen besser gefunden und indexiert werden.

- Konsolidierung von Duplicate Content: Es sollten korrekte Canonical-Tags implementiert oder 301-Weiterleitungen eingerichtet werden, um Suchmaschinen auf die bevorzugte Version einer Seite hinzuweisen und Duplicate Content zu vermeiden.

- Verbesserung der Serverperformance: Langsam ladende Ressourcen sollten optimiert und häufige Serverfehler behoben werden, um die Nutzererfahrung und das Crawling zu verbessern.

- Anpassung der robots.txt: Unwichtige Bereiche sollten blockiert und sichergestellt werden, dass kritische Ressourcen zugänglich sind, um das Crawl-Budget zu optimieren und sicherzustellen, dass Suchmaschinen auf alle wichtigen Inhalte zugreifen können.

- Mobile Optimierung: Es muss sichergestellt werden, dass die mobile Version der Website vollständig crawlbar und indexierbar ist und dass alle wichtigen Inhalte und Funktionen auch auf mobilen Geräten verfügbar sind.

Kontinuierliches Monitoring und Optimierung

Die Behebung technischer SEO-Probleme ist kein einmaliger Vorgang, sondern ein kontinuierlicher Prozess. Es ist von großem Vorteil, ein System zur kontinuierlichen Überwachung zu implementieren, um neue Probleme frühzeitig zu erkennen und zu beheben:

- Es sollten automatisierte Berichte erstellt werden können, die regelmäßig auf kritische Probleme hinweisen und es ermöglichen, schnell zu reagieren.

- Logfile-Daten sollten mit anderen SEO-Metriken verglichen werden, um den Einfluss von Änderungen zu messen und die Effektivität der SEO-Maßnahmen zu überprüfen.

- Die SEO-Strategie sollte basierend auf den gewonnenen Erkenntnissen kontinuierlich angepasst werden, um sicherzustellen, dass die Website optimal für Suchmaschinen und Nutzer optimiert ist.

Durch die gezielte Nutzung der Logfile-Analyse zur Identifizierung und Behebung technischer SEO-Probleme kann die Grundlage für eine optimale Sichtbarkeit in Suchmaschinen geschaffen werden.

Diese datengetriebene Herangehensweise ermöglicht es, präzise und effektive Optimierungen vorzunehmen, die über oberflächliche On-Page-Anpassungen hinausgehen und langfristig zu besseren Rankings und mehr organischem Traffic führen.

Im folgenden Abschnitt erläutere ich ihnen, wie die Logfile-Analyse speziell für die Verbesserung der Mobile - First - Indexierung genutzt werden kann - die mobile Optimierung ist heutzutage ein unverzichtbarer Bestandteil der Suchmaschinenoptimierung.

Mobile-First-Indexierung: Logfile-Analyse für mobile Optimierung

Wie bereits in früheren Abschnitten angedeutet, hat Google den Fokus stark auf mobile Nutzer verschoben.

Bedeutung der Mobile-First-Indexierung

Die Mobile-First-Indexierung bedeutet, dass Google primär die mobile Version einer Website für Ranking und Indexierung heranzieht. Dies unterstreicht die Notwendigkeit, mobile Performance und User Experience in den Mittelpunkt der SEO-Strategie zu stellen und sicherzustellen, dass die mobile Version der Website alle wichtigen Inhalte und Funktionen bietet.

Identifizierung des Mobile-First-Status durch Logfile-Analyse

Die Logfile-Analyse bietet einzigartige Einblicke in das Crawling-Verhalten von Googles mobilem Bot und ermöglicht es, den Mobile-First-Status einer Website zu identifizieren:

- Crawling-Verhältnis: Der Vergleich der Häufigkeit der Zugriffe des mobilen Googlebot mit dem Desktop-Pendant gibt Aufschluss darüber, ob Google die mobile Version der Website priorisiert. Ein deutlich höherer Anteil mobiler Zugriffe deutet auf Mobile-First-Indexierung hin.

- Crawling-Tiefe: Die Analyse, ob der mobile Bot tiefer in die Seitenstruktur vordringt als der Desktop-Bot, zeigt, ob Google alle wichtigen Seiten der mobilen Version crawlt und indexiert.

- Ressourcen-Zugriff: Es muss überprüft werden, ob mobile Bots auf alle kritischen Ressourcen wie CSS, JavaScript und Bilder zugreifen können, da dies für die korrekte Darstellung und Funktionalität der mobilen Version unerlässlich ist.

Optimierung basierend auf Logfile-Erkenntnissen

Die gewonnenen Erkenntnisse können genutzt werden, um gezielte Optimierungen vorzunehmen und die mobile Performance und User Experience zu verbessern:

- Responsive Design überprüfen: Es muss sichergestellt werden, dass alle von Bots gecrawlten URLs eine konsistente Erfahrung auf mobilen und Desktop-Geräten bieten und dass die Website auf allen Geräten korrekt dargestellt wird.

- Mobile Ladezeiten optimieren: Ressourcen, die auf mobilen Geräten langsam laden, sollten identifiziert und gezielt optimiert werden, um die Ladezeiten zu verkürzen und die Nutzererfahrung zu verbessern.

- Mobile Gleichwertigkeit sicherstellen: Es muss überprüft werden, ob mobile Bots Zugriff auf alle wichtigen Inhalte haben, die auch auf der Desktop-Version verfügbar sind, und dass keine Inhalte oder Funktionen auf der mobilen Version fehlen.

- Strukturierte Daten anpassen: Es muss sichergestellt werden, dass strukturierte Daten auch in der mobilen Version korrekt implementiert sind, damit Google die Inhalte der Website besser verstehen und in den Suchergebnissen Rich Snippets anzeigen kann.

Erweiterte Analysetechniken für Mobile-First

Für eine tiefergehende Analyse können folgende Techniken angewandt werden, um die mobile Performance weiter zu verbessern:

- Segmentierung nach Gerätetyp: Das Crawling-Verhalten kann für verschiedene mobile Geräte (Smartphones vs. Tablets) analysiert werden, um spezifische Probleme zu identifizieren und die Website für verschiedene Gerätetypen zu optimieren.

- AMP-Analyse: Falls AMP (Accelerated Mobile Pages) eingesetzt wird, kann das Crawling-Verhalten zwischen AMP- und Nicht-AMP-Seiten verglichen werden, um die Effektivität der AMP-Implementierung zu überprüfen.

- JavaScript-Rendering: Es muss überprüft werden, ob mobile Bots JavaScript-generierte Inhalte korrekt crawlen und indexieren können, da dies für Websites mit dynamischen Inhalten entscheidend ist.

Integration mit anderen Datenquellen

Um ein ganzheitliches Bild zu erhalten, sollten Logfile-Daten mit anderen Datenquellen kombiniert werden, um die mobile Performance umfassend zu analysieren:

- Google Search Console: Mobile Crawling-Daten sollten mit Indexierungs- und Performance-Berichten in der Google Search Console verglichen werden, um potenzielle Probleme zu identifizieren und die Effektivität der mobilen Optimierung zu überprüfen.

- Core Web Vitals: Mobile Crawling-Muster sollten mit Core Web Vitals-Metriken für mobile Geräte korreliert werden, um die Nutzererfahrung zu verbessern und sicherzustellen, dass die Website die von Google geforderten Performance-Standards erfüllt.

- Analytics-Daten: Es sollte analysiert werden, ob häufig gecrawlte mobile Seiten auch bei Nutzern beliebt sind und ob sie zu Conversions führen.

Kontinuierliche Überwachung und Anpassung

Die Mobile-First-Optimierung ist ein fortlaufender Prozess, der kontinuierliche Überwachung und Anpassung erfordert:

- Es sollte ein Monitoring-System implementiert werden, das Veränderungen im mobilen Crawling-Verhalten erkennt und es ermöglicht, schnell auf Probleme zu reagieren.

- Die mobile SEO-Strategie sollte basierend auf den Logfile-Erkenntnissen regelmäßig angepasst werden, um sicherzustellen, dass die Website optimal für mobile Nutzer und Suchmaschinen optimiert ist.

Durch die gezielte Nutzung der Logfile-Analyse für die mobile Optimierung kann sichergestellt werden, dass eine Website optimal für die Mobile-First-Indexierung positioniert ist. Dies verbessert nicht nur die Chancen auf gute Rankings in der mobilen Suche, sondern gewährleistet auch eine bessere User Experience für die wachsende Zahl mobiler Nutzer, was langfristig zu mehr Traffic, Conversions und Umsatz führt.Im folgenden Abschnitt erläutere ich Ihnen, wie Logfile-Erkenntnisse zur Verbesserung der allgemeinen Performance ihrer Websites genutzt werden können.

Verbesserung der Website-Performance durch Erkenntnisse aus dem Access Log

Jetzt geht es um einen weiteren kritischen Aspekt: Die Verbesserung der allgemeinen Website-Performance basierend auf den Erkenntnissen, die aus der Analyse von Logfiles gewonnen werden können.

Identifikation von Performance-Engpässen

Logfiles bieten detaillierte Einblicke in die serverseitige Performance einer Website, die über die Möglichkeiten herkömmlicher Web-Analytics-Tools hinausgehen und es ermöglichen, Performance-Engpässe zu identifizieren, die die Nutzererfahrung und das SEO beeinträchtigen können:

- Serverantwortzeiten: Die Analyse der Zeit, die der Server benötigt, um auf Anfragen zu reagieren, gibt Aufschluss darüber, ob der Server überlastet ist oder ob es ineffiziente Skripte gibt, die die Antwortzeiten verlängern.

- Ressourcen-Ladezeiten: Die Identifizierung von Ressourcen wie Bilder, CSS- oder JavaScript-Dateien, die besonders lange Ladezeiten aufweisen, ermöglicht es, diese zu optimieren und die Gesamtperformance der Website zu verbessern.

- Häufigkeit von 5xx-Fehlern: Ein Anstieg von Serverfehlern kann auf grundlegende Infrastrukturprobleme hinweisen, die behoben werden müssen, um die Stabilität und Zuverlässigkeit der Website zu gewährleisten.

Optimierung des Caching-Verhaltens

Logfile-Daten sind so ziemlich die einzige Datenquelle, die genutzt werden kann, um das Caching-Verhalten einer Website zu optimieren und die Serverlast zu reduzieren:

- Cache-Hit-Ratio: Die Überprüfung, wie oft gecachte Ressourcen direkt ausgeliefert werden, ohne den Server zu belasten, gibt Aufschluss darüber, wie effektiv das Caching ist.

- Cache-Lebensdauer: Die Analyse, ob statische Ressourcen häufig neu angefordert werden, ermöglicht es, die Cache-Einstellungen entsprechend anzupassen und die Cache-Lebensdauer zu verlängern, um die Serverlast zu reduzieren.

- CDN-Effizienz: Bei Nutzung eines Content Delivery Networks (CDN) können dessen Effektivität anhand der Logfile-Daten bewertet und die CDN-Konfiguration optimiert werden, um die Ladezeiten für Nutzer in verschiedenen Regionen zu verbessern.

Lastverteilung und Skalierung

Logfile-Analysen helfen bei der Optimierung der Serverinfrastruktur und der Lastverteilung, um sicherzustellen, dass die Website auch bei hohem Traffic schnell und zuverlässig erreichbar ist:

- Traffic-Spitzen: Die Identifizierung von Zeiten mit besonders hoher Last ermöglicht es, Ressourcen gezielt zu skalieren und sicherzustellen, dass die Website auch bei Traffic-Spitzen optimal performt.

- Bot-Traffic: Die Analyse des Anteils und des Verhaltens von Bot-Traffic ermöglicht es, Ressourcen effizient zu allokieren und sicherzustellen, dass legitime Nutzer nicht durch Bot-Traffic beeinträchtigt werden.

- Geografische Verteilung: Die Nutzung von IP-Informationen, um die geografische Verteilung der Zugriffe zu verstehen, ermöglicht es, regionale Server einzusetzen und die Ladezeiten für Nutzer in verschiedenen Regionen zu verbessern.

Integration mit Core Web Vitals

Wie in der Sektion zur mobilen Optimierung angedeutet, lassen sich Logfile-Daten mit Core Web Vitals verknüpfen, um die Nutzererfahrung und das SEO zu verbessern:

- Largest Contentful Paint (LCP): Die Identifizierung großer Ressourcen, die das LCP negativ beeinflussen könnten, ermöglicht es, diese zu optimieren und die Ladezeiten zu verkürzen.

- Interaction to Next Paint (INP): INP bewertet die Latenz aller Klick-, Touch- und Tastatur-Interaktionen, die während des gesamten Besuchs einer Seite auftreten. Es misst die Zeit zwischen dem Beginn einer Interaktion und dem nächsten visuellen Update (Paint) auf dem Bildschirm.

- Cumulative Layout Shift (CLS): Die Überprüfung, ob bestimmte Ressourcen häufig nachgeladen werden und Layout-Verschiebungen verursachen, ermöglicht es, diese zu beheben und die visuelle Stabilität der Website zu verbessern.

Sicherheitsoptimierung durch Logfile-Analyse

Neben Performance-Aspekten bieten Logfiles auch wertvolle Einblicke in Sicherheitsbelange und ermöglichen es, potenzielle Sicherheitsrisiken zu identifizieren:

- Erkennung von Angriffsmustern: Die Identifizierung ungewöhnlicher Zugriffsmuster, die auf Hacking-Versuche hindeuten könnten, ermöglicht es, rechtzeitig Maßnahmen zu ergreifen und die Website vor Angriffen zu schützen.

- Bot-Verifizierung: Es muss sichergestellt werden, dass sich als Googlebot ausgebende Anfragen tatsächlich von Google stammen und nicht von bösartigen Bots, die die Website schädigen könnten.

- Ressourcen-Missbrauch: Die Erkennung übermäßiger Zugriffe auf bestimmte Ressourcen, die auf Scraping oder andere missbräuchliche Aktivitäten hindeuten könnten, ermöglicht es, diese zu unterbinden und die Ressourcen der Website zu schützen.

Implementierung von Performance-Verbesserungen

Basierend auf den Logfile-Erkenntnissen sollten nun gezielte Optimierungen vorgenommen werden, um die Website-Performance zu verbessern:

- Ressourcen-Optimierung: Häufig angeforderte Ressourcen sollten komprimiert und optimiert werden, um die Ladezeiten zu verkürzen.

- Serverkapazität anpassen: Die Serverinfrastruktur sollte basierend auf identifizierten Lastspitzen skaliert werden, um sicherzustellen, dass die Website auch bei hohem Traffic optimal performt.

- Caching-Strategien verfeinern: Es sollten effektivere Caching-Richtlinien für statische Inhalte implementiert werden, um die Serverlast zu reduzieren und die Ladezeiten zu verkürzen.

- CDN-Einsatz optimieren: Die CDN-Konfiguration sollte basierend auf geografischen Zugriffsmustern angepasst werden, um die Ladezeiten für Nutzer in verschiedenen Regionen zu verbessern.

- Sicherheitsmaßnahmen verstärken: Es sollten zusätzliche Sicherheitskontrollen für identifizierte Schwachstellen implementiert werden, um die Website vor Angriffen zu schützen.

Kontinuierliches Performance-Monitoring

Um nachhaltige Verbesserungen zu erzielen und diese auch zu erhalten, ist ein fortlaufendes Monitoring angebracht:

- Es sollten automatisierte Alerts für Performance-Einbrüche oder Sicherheitsvorfälle implementiert werden, um schnell auf Probleme reagieren zu können.

- Es sollten regelmäßige Performance-Berichte erstellt werden, die Logfile-Daten mit anderen Metriken kombinieren, um ein umfassendes Bild der Website-Performance zu erhalten.

- Es sollten A/B-Tests durchgeführt werden, um den Einfluss von Optimierungen auf das Nutzerverhalten zu messen und die Effektivität der Maßnahmen zu überprüfen.

Durch die gezielte Nutzung von Logfile-Daten zur Performance-Optimierung können nicht nur die technische SEO verbessert, sondern auch die allgemeine Nutzererfahrung und Sicherheit der Website erhöht werden. Dies führt langfristig zu besseren Rankings, höherer Nutzerzufriedenheit und letztendlich zu mehr Conversions und Umsatz.

Die Sicherheit einer Website ist nicht nur für die Nutzer, sondern auch für die Suchmaschinenoptimierung von großer Bedeutung. Im folgenden Abschnitt wird erläutert, wie Logfile-Analysen zur Erkennung von Sicherheitsbedrohungen eingesetzt werden können.

Sicherheit und SEO: Logfile-Analyse zur Erkennung von Bedrohungen

Nachdem die Bedeutung von Logfiles für die Optimierung des Crawling-Verhaltens, der mobilen Performance und der allgemeinen Website-Leistung betrachtet wurde, wird nun ein oft übersehener, aber kritischer Aspekt behandelt: Die Nutzung von Logfile-Analysen zur Erkennung von Sicherheitsbedrohungen und deren potenziellen Auswirkungen auf die SEO-Performance einer Website.

Zusammenhang zwischen Sicherheit und SEO

Sicherheitsprobleme können sich direkt und indirekt auf die SEO-Performance einer Website auswirken:

- Malware-Warnungen: Google kann kompromittierte Websites mit Warnhinweisen in den Suchergebnissen versehen, was zu drastischen Traffic-Einbrüchen führt, da Nutzer abgeschreckt werden, die Website zu besuchen.

- Blacklisting: Bei schwerwiegenden Sicherheitsvorfällen können Suchmaschinen eine Website komplett aus dem Index entfernen, was zu einem Totalverlust des organischen Traffics führt.

- Reputationsschaden: Sicherheitsvorfälle können das Nutzervertrauen nachhaltig schädigen und indirekt die Rankings beeinflussen, da Nutzer weniger geneigt sind, eine Website zu besuchen, der sie nicht vertrauen.

Identifikation von Sicherheitsbedrohungen durch Logfile-Analyse

Logfiles bieten einzigartige Einblicke in potenzielle Sicherheitsrisiken und ermöglichen es, Bedrohungen frühzeitig zu erkennen:

- Ungewöhnliche Zugriffsmuster: Plötzliche Spikes in der Anzahl der Anfragen oder auffällige geografische Verteilungen können auf DDoS-Angriffe (Distributed Denial of Service) hindeuten, die die Website lahmlegen können.

- Verdächtige User-Agents: Bots, die sich als legitime Crawler ausgeben, aber nicht verifiziert werden können, sollten genauer untersucht werden, da sie möglicherweise bösartige Absichten haben.

- Zugriffe auf sensible Bereiche: Häufige Anfragen auf Admin-Bereiche oder Datenbank-Skripte können auf Hacking-Versuche hindeuten, bei denen Angreifer versuchen, Zugriff auf sensible Daten zu erlangen.

- SQL-Injection-Versuche: Ungewöhnliche Zeichenfolgen in URL-Parametern können auf Versuche hindeuten, die Datenbank zu kompromittieren und sensible Daten zu stehlen.

SEO-relevante Sicherheitsanalysen

Einige spezifische Analysen sind besonders relevant für die Schnittstelle zwischen Sicherheit und SEO und helfen, Bedrohungen zu erkennen, die sich direkt auf die Suchmaschinen-Performance auswirken können:

- Cloaking-Erkennung: Der Vergleich der Antworten des Servers für verschiedene User-Agents ermöglicht es, bösartiges Cloaking zu identifizieren, bei dem Angreifer nach erfolgreichem Eindringen in das System, Suchmaschinen andere Inhalte anzeigen als Nutzern, was zu Strafen durch Google führen kann.

- Hacked Content: Die Überwachung unerwarteter Änderungen in der Seitenstruktur oder plötzliche Anstiege neuer URLs, die auf eingeschleuste Inhalte hindeuten könnten, ermöglicht es, schnell auf Hacking-Angriffe zu reagieren und die Website zu bereinigen.

- Backlink-Spam: Die Analyse von Referrer-Daten, um unnatürliche Muster in der Backlink-Struktur zu erkennen, die auf negative SEO-Angriffe hindeuten könnten, ermöglicht es, diese zu unterbinden und die Website vor Schäden zu schützen.

Implementierung von Sicherheitsmaßnahmen

Basierend auf den Erkenntnissen aus der Logfile-Analyse können gezielte Sicherheitsmaßnahmen ergriffen werden, um die Website vor Bedrohungen zu schützen:

- IP-Blocking: Sie können automatisierte Systeme implementieren, um auffällige IP-Adressen temporär oder permanent zu blockieren und Angriffe abzuwehren.

- Web Application Firewall (WAF): Eine WAF (Web Application Firewall) sollte basierend auf identifizierten Angriffsmustern konfiguriert werden, um die Website vor bekannten Schwachstellen zu schützen.

- Bot-Management: Die robots.txt-Datei könnte verfeinert und strengere Bot-Verifizierungsmechanismen implementiert werden, um unerwünschte bzw. bösartige Bots abzuwehren.

- Content-Integritätsprüfungen: Es sollten regelmäßige Scans durchgeführt werden, um unerwartete Änderungen im Website-Content zu erkennen und sicherzustellen, dass die Website nicht manipuliert wurde.

Integration in die SEO-Strategie

Die Erkenntnisse aus der sicherheitsorientierten Logfile-Analyse sollten in die gesamte SEO-Strategie einfließen, um sicherzustellen, dass Sicherheit und SEO Hand in Hand gehen:

- Das SEO-Team sollte in grundlegenden Sicherheitsaspekten geschult werden, um eine ganzheitliche Herangehensweise zu fördern und sicherzustellen, dass alle Teammitglieder die Bedeutung von Sicherheit für SEO verstehen.

- Sicherheitsmetriken könnten in die regulären SEO-Berichte integriert werden, um die Verbindung zwischen Sicherheit und Performance hervorzuheben und sicherzustellen, dass die Sicherheitslage der Website kontinuierlich überwacht wird.

Durch die Nutzung von Logfile-Analysen zur Erkennung von Sicherheitsbedrohungen können nicht nur potenzielle SEO-Katastrophen abgewendet, sondern auch das Vertrauen von Nutzern und Suchmaschinen in die Website gestärkt werden. Dies schafft eine solide Grundlage für nachhaltigen SEO-Erfolg in einem zunehmend komplexen und bedrohlichen Online-Umfeld.

Fortgeschrittene Techniken: Logfile-Analyse für internationale und mehrsprachige Websites

Nachdem die grundlegenden Aspekte der Logfile-Analyse und ihre Bedeutung für technisches SEO, mobile Optimierung und Sicherheit betrachtet wurden, werde ich nun fortgeschrittene Techniken vorstellen, die besonders für internationale und mehrsprachige Websites relevant sind und es ermöglichen, die SEO-Performance in verschiedenen Ländern und Sprachen zu optimieren.

Herausforderungen internationaler Websites

Internationale Websites stehen vor einzigartigen Herausforderungen, die durch Logfile-Analysen adressiert werden können und es ermöglichen, die spezifischen Anforderungen verschiedener Märkte zu erfüllen:

- Sprachspezifisches Crawling: Wie crawlen Suchmaschinen verschiedene Sprachversionen einer Website? Werden alle Sprachversionen gleich behandelt?

- Geo-Targeting: Werden länderspezifische Versionen einer Website korrekt erkannt und priorisiert? Werden Nutzer aus verschiedenen Ländern auf die richtige Sprachversion weitergeleitet?

- hreflang-Implementierung: Funktionieren die hreflang-Tags wie beabsichtigt und helfen sie Suchmaschinen, die Beziehungen zwischen verschiedenen Sprachversionen einer Seite zu verstehen?

Sprachspezifische Crawling-Muster erkennen

Die Logfile-Analyse ermöglicht es, das Crawling-Verhalten für verschiedene Sprachversionen einer Website zu untersuchen und sicherzustellen, dass alle Sprachversionen korrekt gecrawlt und indexiert werden:

- Vergleichen Sie die Crawl-Frequenz und -Tiefe für verschiedene Sprachversionen, um festzustellen, ob bestimmte Sprachen vernachlässigt oder bevorzugt werden.

- Identifizieren Sie, ob Googlebot mit dem korrekten Ländercode (z.B. Googlebot-Mobile (en-US) für die US-englische Version) auf die Website zugreift.

Geo-Targeting und Serverstandort-Analyse

Für internationale SEO ist es wichtig zu verstehen, wie Suchmaschinen den geografischen Kontext einer Website interpretieren und wie der Serverstandort das Crawling-Verhalten beeinflusst:

- Überprüfen Sie, ob der Serverstandort das Crawling-Verhalten beeinflusst und ob ein CDN (Content Delivery Network) eingesetzt wird, um die Ladezeiten für Nutzer in verschiedenen Regionen zu verbessern.

- Identifizieren Sie potenzielle Probleme mit IP-basierten Geo-Redirects (von denen ich nur entschieden abraten kann), die möglicherweise nicht korrekt funktionieren und Nutzer auf die falsche Sprachversion weiterleiten.

hreflang-Implementierung überprüfen

Wie in der Sektion zu technischen SEO-Problemen angedeutet, sind hreflang-Tags entscheidend für mehrsprachige Websites. Die Logfile-Analyse kann hier zusätzliche Erkenntnisse liefern und helfen, Implementierungsfehler zu erkennen:

- Überprüfen Sie, ob alle hreflang-verlinkten Seiten tatsächlich gecrawlt werden und ob es Seiten gibt, die in den hreflang-Tags aufgeführt sind, aber nicht gecrawlt werden.

- Identifizieren Sie Inkonsistenzen zwischen hreflang-Tags und dem tatsächlichen Crawling-Verhalten, z.B. wenn eine Seite auf eine andere Sprachversion verlinkt, aber diese nicht gecrawlt wird.

- Analysieren Sie, ob Suchmaschinen die richtige Sprachversion für verschiedene Länder-Bots crawlen und ob Nutzer aus verschiedenen Ländern auf die richtige Sprachversion weitergeleitet werden.

Internationale Content-Duplizierung erkennen

Duplicate Content ist bei internationalen Websites ein häufiges Problem, da ähnliche Inhalte in verschiedenen Sprachen vorhanden sein können. Die Logfile-Analyse kann helfen, dieses Problem zu adressieren:

- Identifizieren Sie, ob ähnliche Inhalte in verschiedenen Sprachen als Duplikate behandelt werden und ob Canonical-Tags korrekt implementiert sind, um Suchmaschinen auf die bevorzugte Version hinzuweisen.

- Überprüfen Sie, ob Canonical-Tags für internationale Versionen korrekt interpretiert werden und ob Suchmaschinen die richtige Sprachversion indexieren.

- Analysieren Sie das Crawling-Verhalten für Länder mit gemeinsamer Sprache (z.B. Deutschland und Österreich), um sicherzustellen, dass die Inhalte nicht als Duplikate behandelt werden.

Fortgeschrittene Segmentierung und Analyse

Für tiefere Einblicke können folgende Analysetechniken angewandt werden, um die internationale SEO-Performance weiter zu verbessern:

- Bot-Vergleich nach Ländern: Analysieren Sie, wie sich das Verhalten von Google, Bing, Yandex und anderen regionalen Suchmaschinen unterscheidet und passen Sie die SEO-Strategie entsprechend an.

- Zeitzonenbasierte Analyse: Untersuchen Sie, ob es zeitliche Muster im Crawling verschiedener internationaler Versionen gibt und optimieren Sie die Serverressourcen entsprechend.

- Ressourcen-Lokalisierung: Überprüfen Sie, ob lokalisierte Ressourcen (Bilder, Videos) korrekt gecrawlt werden und ob sie für Nutzer in verschiedenen Ländern optimiert sind.

Implementierung internationaler SEO-Optimierungen

Basierend auf den Erkenntnissen aus der Logfile-Analyse können gezielte Optimierungen vorgenommen werden, um die internationale SEO-Performance zu verbessern:

- Crawl-Budget-Optimierung: Priorisieren Sie das Crawling wichtiger Sprachversionen durch gezielte interne Verlinkung und stellen Sie sicher, dass Suchmaschinen die wichtigsten Inhalte zuerst crawlen.

- hreflang-Verfeinerung: Passen Sie hreflang-Tags basierend auf dem tatsächlichen Crawling-Verhalten an und korrigieren Sie Fehler, um sicherzustellen, dass Suchmaschinen die Beziehungen zwischen verschiedenen Sprachversionen korrekt verstehen.

- Geo-IP-Konfiguration: Optimieren Sie Weiterleitungen basierend auf Erkenntnissen zum Bot-Verhalten aus verschiedenen Regionen und stellen Sie sicher, dass Nutzer auf die richtige Sprachversion weitergeleitet werden.

- Internationale Sitemap-Strategie: Entwickeln Sie sprachspezifische Sitemaps, die das Crawling effizienter gestalten und sicherstellen, dass alle wichtigen Seiten gecrawlt werden.

Integration mit internationalen SEO-KPIs

Um den Erfolg der internationalen SEO-Bemühungen zu messen, verknüpfen Sie Logfile-Erkenntnisse am sinnvollsten mit anderen Datenquellen und definieren Sie spezifische KPIs (Key Performance Indicators):

- Bringen Sie Crawling-Muster mit den Rankings in verschiedenen Ländern und Sprachen in Zusammenhang, um den Einfluss des Crawling-Verhaltens auf die Ranking-Performance zu verstehen.

- Analysieren Sie den Zusammenhang zwischen Crawling-Frequenz und organischem Traffic für verschiedene Sprachversionen, um die Effektivität der SEO-Maßnahmen zu messen.

- Überwachen Sie die Indexierungsrate neuer Inhalte in verschiedenen Sprachen, um sicherzustellen, dass neue Inhalte schnell von Suchmaschinen erfasst werden.

Durch die Anwendung dieser fortgeschrittenen Techniken der Logfile-Analyse können die komplexen Herausforderungen internationaler und mehrsprachiger Websites gezielt angegangen werden. Dies ermöglicht eine präzise Optimierung der globalen SEO-Strategie und stellt sicher, dass die Website in allen Zielmärkten optimal performt und die gewünschten Ergebnisse erzielt.

Fazit: Maximierung der SEO-Potenziale durch strategische Logfile-Analyse

Nach der umfassenden Betrachtung der verschiedenen Aspekte der Logfile-Analyse für SEO folgt nun eine Zusammenfassung der wichtigsten Aspekte und ein Ausblick auf die zukünftige Entwicklung dieses wichtigen Bereichs.

Zentrale Erkenntnisse

Wie in den vorherigen Abschnitten detailliert dargelegt, bietet die Logfile-Analyse einzigartige und wertvolle Einblicke in das Verhalten von Suchmaschinen auf einer Website:

- Sie ermöglicht ein tiefes Verständnis des Crawling-Verhaltens und hilft bei der Optimierung des Crawl-Budgets, um sicherzustellen, dass Suchmaschinen die wichtigsten Inhalte effizient crawlen.

- Für die Mobile-First-Indexierung liefert sie wertvolle Daten zur Anpassung der mobilen Strategie und zur Optimierung der Website für mobile Nutzer.

- In Bezug auf Website-Performance und Sicherheit deckt sie Schwachstellen auf, die sonst möglicherweise unentdeckt blieben und die Nutzererfahrung und das SEO beeinträchtigen könnten.

- Für internationale Websites bietet sie Einblicke in sprachspezifisches Crawling und hilft bei der Optimierung von hreflang-Tags, um sicherzustellen, dass Suchmaschinen die Beziehungen zwischen verschiedenen Sprachversionen korrekt verstehen.

Integration in die SEO-Gesamtstrategie

Um das volle Potenzial der Logfile-Analyse auszuschöpfen, sollte sie nicht als isoliertes Tool betrachtet werden, sondern als integraler Bestandteil der gesamten SEO-Strategie:

- Datenintegration: Kombinieren Sie Logfile-Daten mit Informationen aus Google Search Console, Analytics und anderen SEO-Tools, um ein ganzheitliches Bild der Website-Performance zu erhalten und fundierte Entscheidungen zu treffen.

- Kontinuierliches Monitoring: Implementieren Sie ein System zur regelmäßigen Überwachung kritischer Metriken aus den Logfiles, um Probleme frühzeitig zu erkennen und schnell darauf reagieren zu können.

- Agile Optimierung: Nutzen Sie die Erkenntnisse aus der Logfile-Analyse für schnelle Anpassungen der technischen SEO-Maßnahmen und optimieren Sie die Website kontinuierlich, um den sich ändernden Anforderungen von Suchmaschinen gerecht zu werden.

- Cross-funktionale Zusammenarbeit: Teilen Sie relevante Erkenntnisse mit Entwicklern, Content-Erstellern und Marketing-Teams, um sicherzustellen, dass alle an einem Strang ziehen und die Website gemeinsam optimieren.

Zukünftige Entwicklungen und Trends

Die Bedeutung der Logfile-Analyse für SEO wird in Zukunft voraussichtlich weiter zunehmen, da Suchmaschinen immer komplexer werden und die Anforderungen an Websites steigen:

- KI-gestützte Analysen: Maschinelles Lernen wird die Interpretation von Logfile-Daten revolutionieren und noch präzisere Einblicke ermöglichen, um Muster und Anomalien zu erkennen, die mit herkömmlichen Methoden schwer zu finden sind.

- Echtzeit-Optimierung: Fortschritte in der Datenverarbeitung werden es ermöglichen, SEO-Anpassungen basierend auf Logfile-Daten in Echtzeit vorzunehmen und die Website dynamisch an das Crawling-Verhalten von Suchmaschinen anzupassen.

- Erweiterte Bot-Erkennung: Mit der Zunahme von KI-gesteuerten Bots wird die präzise Identifikation und Differenzierung verschiedener Crawler-Typen noch wichtiger, um legitimen Traffic von schädlichem Bot-Traffic zu unterscheiden.

- Datenschutz und Compliance: Die Analyse von Logfiles wird sich an strengere Datenschutzbestimmungen anpassen müssen, was neue Herausforderungen, aber auch Chancen für datenschutzkonforme Analysen bietet und es erfordert, innovative Methoden zu entwickeln, um Daten zu analysieren, ohne die Privatsphäre der Nutzer zu verletzen.

Abschließende Empfehlungen

Um die SEO-Potenziale durch Logfile-Analyse maximal auszuschöpfen, werden folgende Empfehlungen gegeben:

- Investition in Expertise: Schulen Sie Ihr Team in fortgeschrittenen Logfile-Analysetechniken oder arbeiten Sie mit spezialisierten Experten zusammen, um sicherzustellen, dass Sie das Know-how haben, um die Daten effektiv zu interpretieren und zu nutzen.

- Tool-Optimierung: Wählen Sie Logfile-Analyse-Tools, die sich nahtlos in Ihre bestehende SEO-Toollandschaft integrieren lassen und die spezifischen Anforderungen Ihrer Website erfüllen.

- Experimentelle Herangehensweise: Nutzen Sie A/B-Tests und kontrollierte Experimente, um den Einfluss von Änderungen basierend auf Logfile-Erkenntnissen zu messen und sicherzustellen, dass Ihre Optimierungen tatsächlich die gewünschten Ergebnisse erzielen.

- Langfristige Perspektive: Betrachten Sie die Logfile-Analyse als langfristige Investition in Ihre SEO-Strategie, die kontinuierliche Aufmerksamkeit und Ressourcen erfordert, aber langfristig zu nachhaltigen Verbesserungen der Suchmaschinen-Performance führt.

Zusammenfassend lässt sich sagen, dass die strategische Nutzung der Logfile-Analyse ein entscheidender Faktor für den SEO-Erfolg in einer zunehmend komplexeren Suchlandschaft ist.

Sie bietet nicht nur tiefe Einblicke in das Verhalten von Suchmaschinen, sondern ermöglicht auch präzise, datengesteuerte Optimierungen, die Ihre Website an die Spitze der Suchergebnisse bringen können.

Indem Sie die in diesem Artikel vorgestellten Techniken und Strategien anwenden und kontinuierlich weiterentwickeln, schaffen Sie eine solide Grundlage für nachhaltige SEO-Erfolge und sichern sich einen Wettbewerbsvorteil in der Online-Welt.