Direct Traffic: Der ultimative SEO-Leitfaden zur Analyse und Optimierung

Direct Traffic ist mehr als nur ein Lesezeichen-Klick – es ist oft ein Mix aus unbekannten Quellen, der Ihre Marketing-Analyse verzerrt. Dieser Leitfaden entschlüsselt, was sich wirklich hinter dem direkten Traffic verbirgt, wie er Ihre SEO-Performance indirekt beeinflusst und wie Sie durch smarte Strategien die Kontrolle über Ihre Daten zurückgewinnen.

Das Missverständnis des direkten Traffics – Mehr als nur die URL-Eingabe

Direct Traffic ist eine sehr häufig zitierte, aber gleichzeitig auch tiefgreifend missverstandene Metrik in der täglichen SEO Arbeit. Auf den ersten Blick scheint die Definition einfach: Besucher, die die URL einer Website direkt in ihren Browser eingeben oder ein Lesezeichen verwenden. Dieses Verständnis führt oft zu der voreiligen Schlussfolgerung, dass ein hoher Anteil an Direct Traffic ein eindeutiges und positives Signal für eine starke Markenbekanntheit ist.

Die Realität ist jedoch weitaus komplexer und nuancierter. Der Kanal (direct) / (none) in Google Analytics 4 (GA4) ist weniger ein klar definierter Zugangsweg als vielmehr eine „Blackbox“ – ein Sammelbecken für eine Vielzahl von Traffic-Quellen, deren Herkunft aus technischen Gründen nicht eindeutig zugeordnet werden kann.

Für SEOs und Webanalysten stellt diese Mehrdeutigkeit eine erhebliche Herausforderung dar.

Die zentrale Aufgabe besteht darin, zwischen einem wertvollen Markensignal, das auf echter Nutzerloyalität und Bekanntheit beruht, und einem Symptom für technische Tracking-Fehler oder Datenlücken zu unterscheiden.

Eine Fehlinterpretation kann gravierende strategische Konsequenzen haben. Wird fehlerhaft zugeordneter Traffic fälschlicherweise als Zeichen von Markenstärke gewertet, könnten Investitionen in tatsächlich erfolgreiche, aber unsichtbar gewordene Kanäle wie Social Media oder E-Mail-Marketing fälschlicherweise gekürzt werden. Umgekehrt können unentdeckte technische Probleme in der Datenhygiene zu einer verzerrten Wahrnehmung der Marketingeffektivität führen und die Grundlage für datengestützte Entscheidungen untergraben.

Dieser Beitrag zielt darauf ab, diese Komplexität zu entwirren und einen umfassenden, referenztauglichen Leitfaden für den Umgang mit Direct Traffic aus SEO-Sicht zu bieten. Er führt Sie von der technischen Definition in GA4 über eine tiefgehende Analyse der wahren Quellen – einschließlich des Phänomens „Dark Traffic“ – bis hin zu den Auswirkungen moderner Datenschutztechnologien. Darauf aufbauend werden fortgeschrittene Analysemethoden in GA4 vorgestellt, Strategien zur Verbesserung der Datenhygiene entwickelt und die tatsächliche, oft indirekte Beziehung zwischen Direct Traffic und SEO-Rankings beleuchtet. Abschließend werden konkrete Handlungsstrategien aufgezeigt, um den wertvollen, echten Direct Traffic gezielt zu steigern und so nachhaltig zum Markenaufbau und zur SEO-Performance beizutragen.

Die Anatomie des „Direct Traffic“ am Beispiel von Google Analytics 4

Um Direct Traffic strategisch bewerten zu können, ist ein Verständnis seiner technischen Definition und seiner Rolle im Ökosystem von Google Analytics wichtig. Es ist grundlegend wichtig zu erkennen, dass dieser Kanal nicht das ist, was er auf den ersten Blick zu sein scheint.

Die offizielle Definition von (direct) / (none)

Google Analytics 4 klassifiziert eine Sitzung der Quelle (direct) und dem Medium (none) zu, wenn keine Informationen über die verweisende Quelle (den sogenannten "Referrer") verfügbar sind oder wenn die Sitzung auf eine Weise ausgelöst wird, die explizit als direkt gilt.

Der HTTP-Referrer ist ein Teil der technischen Kopfdaten, die ein Browser an eine Website sendet und der die URL der vorherigen Seite enthält, von der aus der Nutzer gekommen ist. Fehlt dieser Referrer, weiß GA4 nicht, woher der Besuch stammt, und ordnet ihn der Standardkategorie (direct) / (none) zu. Dies ist die grundlegende technische Gegebenheit, die erklärt, warum so viele unterschiedliche Besuchertypen in diesem einen Kanal zusammengefasst werden.

Entmystifizierung: Direct Traffic als Sammelbecken

Entgegen der landläufigen Meinung ist (direct) / (none) kein einzelner, klar definierter Marketingkanal wie "Organic Search" oder "Paid Social". Vielmehr fungiert er als eine Fallback-Kategorie oder ein Auffangbecken.

Jede Sitzung, deren Herkunft GA4 nicht eindeutig einem anderen Kanal zuordnen kann, landet im Kanal "Direct Traffic".

Diese Erkenntnis ist fundamental. Ein hoher Anteil an Direct Traffic, insbesondere wenn er über den üblichen Durchschnitt von 5% bis 20% hinausgeht, ist selten ausschließlich auf eine überragende Markenbekanntheit zurückzuführen. Viel wahrscheinlicher ist, dass ein Wert von über 20-25% auf zugrunde liegende Probleme im Tracking-Setup oder auf den Verlust von Referrer-Informationen aus anderen Kanälen hindeutet. Die Annahme, die verschiedenen Kanäle in GA4 seien saubere, voneinander getrennte Daten-Silos, ist ein Trugschluss. In der Realität sind diese Kanäle porös, und der Direct-Kanal absorbiert die "Lecks" aus den anderen.

Ein plötzlicher Anstieg des Direct Traffics sollte daher auch nicht isoliert betrachtet werden. Er fungiert oft als Frühwarnsystem für ein Problem in einem anderen Kanal. Beispielsweise kann eine fehlerhaft konfigurierte E-Mail-Kampagne, bei der die notwendigen UTM-Parameter zur Quellenverfolgung fehlen, dazu führen, dass Klicks aus diesen E-Mails nicht dem Kanal "Email" zugeordnet werden können. Da GA4 in diesem Fall keinen Referrer erhält, klassifiziert es diesen Traffic fälschlicherweise als "Direct". Ein Marketingmanager könnte nun die fehlerhafte Schlussfolgerung ziehen, dass die E-Mail-Kampagne wirkungslos war, während die Markenbekanntheit scheinbar gestiegen ist. Die strategische Konsequenz daraus ist, den Direct-Traffic-Bericht immer im Kontext der Performance aller anderen Kanäle zu analysieren. Ein unerklärlicher Anstieg im Direct Traffic sollte immer die Frage auslösen: "Welcher andere Kanal ist gleichzeitig und unerwartet in seiner Performance gesunken?".

Die grundlegende Zweiteilung

Um strategisch handlungsfähig zu werden, muss jede Analyse von Direct Traffic mit einer klaren Unterscheidung beginnen, die sich als roter Faden durch diesen gesamten Bericht zieht:

- Echter (oder intendierter) Direct Traffic: Dies sind Besuche, die tatsächlich auf Markenbekanntheit, Nutzerloyalität und bewusster Absicht beruhen. Nutzer in dieser Kategorie kennen die Marke, vertrauen ihr und haben die klare Intention, die Website direkt zu besuchen, sei es durch manuelle Eingabe der URL, die Nutzung von Lesezeichen oder Browser-Autofill-Funktionen. Dieser Traffic ist ein wertvolles Gut und ein starker Indikator für den Markenwert.

- Fehlerhaft zugewiesener (oder technischer) Direct Traffic: Dies umfasst alle Besuche, die eigentlich aus anderen Kanälen wie Organic Search, Social Media, Referral oder Email stammen, aber aufgrund technischer Limitierungen, Konfigurationsfehler oder Datenschutzmechanismen ihre ursprünglichen Quellinformationen verloren haben. Dieser Teil des Direct Traffics wird oft unter dem Begriff „Dark Traffic“ zusammengefasst. Er verzerrt die Marketing-Analyse und verschleiert die wahre Leistung anderer Kanäle.

Die Fähigkeit, diese beiden Komponenten zu trennen und zu quantifizieren, ist der Schlüssel zur korrekten Interpretation von Marketingdaten und zur Optimierung der SEO- und Marketingstrategie.

Abgrenzung zu "Unassigned" Traffic

Unassigned - Traffic ist das Ergebnis eines Klassifizierungsfehlers innerhalb von GA4. Direct Traffic die Folge eines Mangels an Herkunftsdaten. Unassigned Traffic tritt hauptsächlich auf, wenn GA4 die Quelle einer Sitzung nicht einer seiner vordefinierten Standard-Channel-Gruppen zuordnen kann, was fast immer auf ein behebbares Problem bei der Nachverfolgung oder beim Kampagnen-Tagging hindeutet.

❌ Falsch: utm_medium=mail

✅ Richtig: utm_medium=email

❌ Falsch: utm_source=stape&utm_medium=sst

✅ Richtig: utm_source=newsletter&utm_medium=email

Dazu können noch Probleme mit der kanalübergreifenden Verfolgung, fehlerhafte Weiterleitungen, Ad-Blocker, Probleme mit dem Google Tag Manager (GTM) oder dem Google Tag selbst, sowie falsch konfigurierte Ereignisse oder fehlende session_start - Ereignisse kommen.

Die wahren Quellen des Direct Traffic: Eine Tiefenanalyse

Die Vielfalt der Quellen, die sich im Kanal (direct) / (none) verbergen, ist enorm. Eine detaillierte Untersuchung dieser Ursachen ist der erste Schritt zur Diagnose und zur Entwicklung von Lösungsstrategien. Sie lassen sich grob in die Kategorien "Echter Direct Traffic" und "Dark Traffic" unterteilen.

Echter Direct Traffic: Ein Indikator für Markenautorität und Nutzerloyalität

Dieser Traffic ist das, was Marketer sich wünschen und aktiv fördern sollten. Er ist ein direktes Ergebnis erfolgreicher Markenführung und positiver Nutzererfahrungen.

- Manuelle URL-Eingabe, Lesezeichen und Browser-Autofill: Dies sind die "klassischen" und legitimsten Quellen für Direct Traffic. Sie signalisieren, dass ein Nutzer eine Marke so gut kennt und ihr so sehr vertraut, dass er den Umweg über eine Suchmaschine oder eine andere verweisende Seite nicht mehr benötigt. Dies ist ein starkes Zeichen für Brand Recall (Markenerinnerung) und eine hohe Kundenbindung. Ein Nutzer, der eine URL manuell eingibt oder ein Lesezeichen verwendet, hat eine bewusste Entscheidung getroffen, genau diese Website zu besuchen.

- Die Verbindung zu Offline-Marketing: Traditionelle Marketingkampagnen in Printmedien, Fernsehen, Radio oder auf Veranstaltungen enthalten naturgemäß keine klickbaren Links. Wenn ein potenzieller Kunde durch eine solche Maßnahme auf eine Marke aufmerksam wird, ist sein nächster Schritt oft die direkte Eingabe der beworbenen URL in den Browser. Dies macht den Direct-Traffic-Kanal zu einem wichtigen, wenn auch ungenauen, Key Performance Indicator (KPI) zur Messung der Wirkung und des ROI von Offline-Marketing-Investitionen. Ein Anstieg des Direct Traffics nach dem Start einer TV-Kampagne kann ein starkes Indiz für deren Erfolg sein.

„Dark Traffic“: Das Mysterium der fehlenden Referrer-Daten

Dark Traffic ist der Sammelbegriff für all jenen Traffic, der fälschlicherweise dem Kanal "Direct" zugeordnet wird, weil die Referrer-Informationen auf dem Weg zur Website verloren gegangen sind.

Dieses Phänomen führt zu einer massiven Unterbewertung der tatsächlichen Marketing-Kanäle und verzerrt die gesamte Leistungsanalyse. Die Zunahme von Dark Traffic ist nicht nur auf das private Teilungsverhalten der Nutzer zurückzuführen, sondern auch auf das technologische Design moderner Plattformen, die den Datenabfluss wie den Referrer aktiv unterbinden und versuchen Nutzer in ihrem Ökosystem zu halten.

Die wichtigsten Quellen für Dark Traffic sind:

Dark Social: Dies ist der größte und am schnellsten wachsende Treiber von Dark Traffic. Wenn Nutzer Links über private oder geschlossene Kommunikationskanäle teilen, werden in der Regel keine Referrer-Daten mitgesendet. Dazu gehören:

- Messaging-Dienste wie WhatsApp, Facebook Messenger, Telegram oder Signal.

- Direktnachrichten auf Social-Media-Plattformen wie Instagram DMs oder LinkedIn Messages.

- Team-Kollaborationstools wie Slack oder Microsoft Teams.

Da ein erheblicher Teil des Content-Sharings – Schätzungen zufolge über 80% – in diesen privaten Kanälen stattfindet, entsteht hier eine riesige Datenlücke, die die wahre virale Verbreitung von Inhalten verschleiert.

Mobile Apps: Viele mobile Anwendungen, insbesondere Social-Media-Apps wie Facebook, Instagram oder TikTok, verwenden sogenannte In-App-Browser. Diese internen Browser sind oft so konfiguriert, dass sie Referrer-Daten blockieren, um die Privatsphäre der Nutzer zu schützen oder sie innerhalb der App-Umgebung zu halten. Ein Klick auf einen Link in der Facebook-App kann daher in GA4 als direkter Besuch erscheinen. Ebenso kann die "Öffnen mit..."-Funktion in iOS die Referrer-Informationen entfernen.

Technische Ursachen für Referrer-Verlust: Hierbei handelt es sich um eine Reihe von technischen Gegebenheiten und Fehlern, die zum Verlust der Quellinformationen führen.

- HTTPS-zu-HTTP-Übergang: Dies ist ein fundamentaler Sicherheitsmechanismus des Internets. Wenn ein Nutzer von einer sicheren Seite (mit

https://- Protokoll) auf eine unsichere Seite (mithttp://- Protokoll) klickt, blockiert der Browser die Übermittlung des Referrers, um zu verhindern, dass potenziell sensible Informationen aus der sicheren URL an eine unsichere Umgebung weitergegeben werden. Obwohl die meisten Websites heute auf HTTPS umgestellt sind, bleibt dies ein potenzielles Problem bei der Verlinkung auf ältere Ressourcen oder bei fehlerhaften internen Verlinkungen. - Fehlerhafte oder fehlende Tracking-Codes: Dies ist ein häufiger und vermeidbarer Fehler. Wenn eine Landingpage (z.B. eine neue Kampagnenseite) keinen GA4-Tracking-Code enthält, wird der initiale Besuch nicht erfasst. Navigiert der Nutzer von dieser nicht getrackten Seite auf eine zweite Seite der Website, die den Code enthält, wird der Besuch erst dort registriert. Aus Sicht von GA4 ist die erste Seite (also die eigene Domain) der Referrer. Da die eigene Domain standardmäßig in der Verweisausschlussliste von GA4 steht, wird dieser sogenannte "Self-Referral" als Direct Traffic klassifiziert.

- Fehlerhafte Weiterleitungen (Redirects): Insbesondere clientseitige JavaScript-Weiterleitungen (

window.location.href) oder komplexe serverseitige Weiterleitungsketten können dazu führen, dass die ursprünglichen Referrer-Informationen oder angehängte UTM-Parameter verloren gehen. Serverseitige 301-Redirects sind hier die robustere Lösung. - Links aus nicht-webbasierten Dokumenten: Klicks auf Hyperlinks, die in PDF-Dateien, Word-Dokumenten, Excel-Tabellen oder PowerPoint-Präsentationen eingebettet sind, übermitteln keinen Referrer an den Browser. Alle Besuche aus diesen Quellen werden als Direct Traffic erfasst, es sei denn, die Links sind mit UTM-Parametern versehen.

- Meta Referrer Policy: Eine Website hat die Möglichkeit, über einen Meta-Tag im HTML-Header (

< meta name="referrer" content="..." >) oder einen HTTP-Header (Referrer-Policy) explizit zu steuern, welche Referrer-Informationen an Zielseiten gesendet werden. Eine restriktive Einstellung wieno-referrerauf einer verweisenden Seite unterdrückt die Übermittlung des Referrers vollständig, was auf der Zielseite zwangsläufig zu Direct Traffic führt.

Die Konsequenz aus dieser Vielfalt an technischen und nutzerbedingten Ursachen ist, dass die Verantwortung für eine saubere Traffic-Attribution nicht mehr allein beim empfangenden Analysesystem (GA4) liegen kann. Die Ära des passiven Trackings, das sich auf den automatisch übermittelten Referrer verlässt, geht zu Ende. Stattdessen muss der Marketer proaktiv handeln und die Quellinformationen selbst an die URL anhängen – mittels UTM-Parametern.

Tabelle: Quellen des Direct Traffic – Kategorisierung und Diagnose

Die folgende Tabelle dient als diagnostisches Werkzeug, um die Ursachen für hohen Direct Traffic im eigenen GA4-Konto zu identifizieren und erste Lösungsansätze zu entwickeln.

| Quelle des Direct Traffic | Kategorie | Typische Indikatoren in GA4 | Lösungsansatz / Strategie |

|---|---|---|---|

| Manuelle URL-Eingabe | Echter Direct Traffic | Landingpage ist meist die Startseite (`/`); hoher Anteil an wiederkehrenden Nutzern. | Markenaufbau, Offline-Marketing, Schaffung einprägsamer URLs. |

| Lesezeichen / Browser-Autofill | Echter Direct Traffic | Landingpages sind oft tieferliegende, nützliche Seiten (z.B. Login, Tools, wichtige Blogartikel); hohe Engagement-Rate. | Erstellung von "Bookmark-würdigem" Content, Optimierung der User Experience. |

| Links aus WhatsApp, Messenger etc. | Dark Social | Unvorhersehbare Spikes; Landingpages können sehr spezifisch sein; oft hoher Anteil an mobilem Traffic. | Konsequente Nutzung von UTM-Parametern für alle geteilten Links; Nutzung von URL-Shortenern, die UTMs beibehalten. |

| Klicks aus E-Mail-Clients (z.B. Outlook) | Dark Traffic (E-Mail) | Spikes im Direct Traffic korrelieren zeitlich mit dem Versand von E-Mail-Kampagnen; Rückgang im Kanal "Email". | Obligatorische Verwendung von UTM-Parametern für _alle_ Links in E-Mail-Kampagnen. |

| Klicks aus mobilen Apps | Dark Traffic (App) | Hoher Anteil an mobilem Traffic im Direct-Kanal; Landingpages entsprechen oft in Social Media beworbenen Inhalten. | Verwendung von UTM-getaggten Links in Social-Media-Profilen und Posts. |

| HTTPS -> HTTP Übergang | Technischer Fehler | Referral-Traffic von spezifischen HTTPS-Partnerseiten fehlt; Anstieg im Direct Traffic. | Vollständige Migration der eigenen Website auf HTTPS; Sicherstellen, dass alle internen und externen Links die `https`-Version verwenden. |

| Fehlender Tracking-Code | Technischer Fehler | Landingpage ist `(not set)`; Direct Traffic von der eigenen Domain (Self-Referral). | Regelmäßige technische Audits der Website; Sicherstellen, dass der GA4-Tag auf _jeder_ Seite implementiert ist. |

| Fehlerhafte Weiterleitungen | Technischer Fehler | Unerklärlicher Verlust von Referrer-Daten nach Website-Änderungen; Landingpages sind Zielseiten von Redirects. | Audit aller Weiterleitungsketten; Bevorzugung von serverseitigen 301-Redirects; Sicherstellen, dass UTMs weitergegeben werden. |

| Links in PDFs, Word, etc. | Dark Traffic (Dokument) | Traffic auf Landingpages, die in Offline-Materialien oder herunterladbaren Dokumenten beworben werden. | Verwendung von UTM-getaggten Links (ggf. mit URL-Shortener) in allen nicht-webbasierten Dokumenten. |

Die neue Realität: Wie Datenschutztechnologien die Traffic-Attribution verändern

Die Landschaft der Webanalyse wird zunehmend von Datenschutzbestimmungen und den darauf reagierenden Technologien der Browser-Hersteller geprägt. Diese Entwicklungen haben tiefgreifende Auswirkungen auf die Traffic-Attribution und verstärken die Herausforderungen bei der korrekten Zuordnung von Besuchern, was wiederum den Anteil des als "Direct" klassifizierten Traffics erhöht. Die Ära des einfachen, clientseitigen "Plug-and-Play"-Trackings neigt sich dem Ende zu; Datenschutz wird zu einer technischen Kernkompetenz im Marketing.

Apple's Intelligent Tracking Prevention (ITP)

Apple hat mit ITP in seinem Safari-Browser eine Vorreiterrolle im Kampf gegen Cross-Site-Tracking eingenommen. Die Auswirkungen gehen jedoch weit über das Blockieren von Drittanbieter-Cookies hinaus und beeinträchtigen auch die grundlegende Analyse des Nutzerverhaltens.

Funktionsweise: ITP schränkt die Lebensdauer von clientseitig gesetzten Cookies (also solchen, die durch JavaScript im Browser des Nutzers erstellt werden) drastisch ein. Ursprünglich auf 7 Tage begrenzt, kann diese Lebensdauer unter bestimmten Umständen auf nur 24 Stunden reduziert werden. Zusätzlich blockiert ITP standardmäßig alle Third-Party-Cookies und verfügt über eine "Link Tracking Protection", die bekannte Tracking-Parameter (wie gclid von Google Ads oder fbclid von Facebook) automatisch aus URLs entfernen kann, die in Safari geklickt werden.

Auswirkungen auf Direct Traffic und Attribution: Die Konsequenzen für die Datenanalyse sind gravierend.

- Zerstörte Attributionsketten: Stellen Sie sich einen typischen Customer Journey vor: Ein Nutzer klickt am Montag auf eine bezahlte Anzeige (z.B. Google Ads), landet auf der Website und ein Cookie zur Wiedererkennung wird gesetzt. Der Nutzer kauft nicht sofort, sondern kehrt acht Tage später (am Dienstag der Folgewoche) zurück, indem er die URL direkt eingibt. Durch ITP ist der ursprüngliche Cookie von Montag bereits gelöscht. Für GA4 ist der Besuch am Dienstag daher keine Rückkehr eines bekannten Nutzers aus dem Kanal "Paid Search", sondern der Besuch eines _neuen_ Nutzers aus dem Kanal "Direct". Die wertvolle Verbindung zwischen der ursprünglichen Werbeausgabe und der späteren Conversion geht verloren.

- Verfälschte Nutzer-Metriken: Diese unterbrochenen Nutzerreisen führen zu einer künstlichen Inflation der Metrik "Neue Nutzer" und einer Deflation bei den "Wiederkehrenden Nutzern". Das in den Analytics-Berichten gezeichnete Bild der Nutzerloyalität wird somit systematisch verzerrt und die Effektivität von Top-of-Funnel-Marketingmaßnahmen wird unterschätzt.

Google Consent Mode & Cookie-Banner

Als Reaktion auf Datenschutzgesetze wie die DSGVO hat Google den Consent Mode eingeführt, der das Verhalten von Google-Tags (einschließlich GA4) an die Zustimmung des Nutzers koppelt.

Funktionsweise: Wenn ein Nutzer eine Website besucht, wird ihm ein Cookie-Banner angezeigt. Lehnt der Nutzer die Zustimmung zur Speicherung von Analytics-Cookies ab (analytics_storage='denied'), setzt GA4 keine identifizierenden Cookies mehr auf dem Gerät des Nutzers. Stattdessen sendet GA4 nur noch anonymisierte, aggregierte Signale (sogenannte "Cookieless Pings") an seine Server, die grundlegende Informationen wie den Besuch selbst, aber keine individuellen Nutzerkennungen enthalten. Google versucht, die entstehenden Datenlücken durch statistische Modellierung (Behavioral Modeling) zu schließen, indem es das Verhalten von nicht zustimmenden Nutzern auf Basis des Verhaltens ähnlicher, zustimmender Nutzer schätzt.

Auswirkungen auf Direct Traffic: Wenn ein Nutzer ohne Zustimmung auf die Website gelangt, beispielsweise durch einen Klick auf ein organisches Suchergebnis, wird die Kette zwischen der Quelle (Google Suche) und der Sitzung auf der Website unterbrochen. GA4 kann den Besuch keiner spezifischen Quelle mehr sicher zuordnen. Obwohl die Verhaltensmodellierung versucht, diese Lücken zu füllen, kann dies, insbesondere in der Anfangsphase, bevor die Modelle ausreichend trainiert sind, zu einem Anstieg von nicht zuordenbarem und somit als "Direct" klassifiziertem Traffic führen. Die Genauigkeit der Attributionsdaten leidet, und die Abhängigkeit von modellierten statt gemessenen Daten steigt.

Serverseitiges vs. clientseitiges Tagging: Ein strategischer Lösungsansatz

Angesichts dieser Herausforderungen gewinnt serverseitiges Tagging als strategische Antwort an Bedeutung. Es stellt eine grundlegende Veränderung in der Architektur der Datenerfassung dar.

- Client-Side Tagging (Standardansatz): Der Browser des Nutzers kommuniziert direkt mit den Servern von Drittanbietern wie Google, Facebook oder anderen Marketing-Tools. Jeder Tag auf der Website stellt eine separate Verbindung her. Dieser Ansatz ist anfällig für Ad-Blocker, ITP und andere clientseitige Datenschutzmaßnahmen, die diese Verbindungen blockieren oder manipulieren können.

- Server-Side Tagging (Lösungsansatz): Der Browser des Nutzers sendet nur noch eine einzige, gebündelte Datenanfrage an einen eigenen, vom Unternehmen kontrollierten Server-Container (z.B. in der Google Cloud Platform). Dieser Server agiert als Proxy: Er empfängt die Daten, verarbeitet sie und leitet sie dann kontrolliert und nach definierten Regeln an die verschiedenen Drittanbieter-Endpunkte weiter.

Diese Verlagerung der Datenverarbeitung vom Client auf den Server ist nicht nur eine technische Lösung für ein Tracking-Problem, sondern eine strategische Neuausrichtung. Sie verlagert die Kontrolle über die Marketing-Daten vom unkontrollierbaren Browser des Nutzers und den Ad-Tech-Plattformen zurück zum Unternehmen selbst. Unternehmen, die in Server-Side Tagging und damit in ihre First-Party-Datenstrategie investieren, werden einen signifikanten Wettbewerbsvorteil erlangen. Ihre Daten werden genauer, ihre Attribution zuverlässiger und ihre Marketingausgaben effizienter sein. Diejenigen, die beim reinen Client-Side-Tracking verharren, werden zunehmend mit ungenauen, lückenhaften Daten arbeiten müssen, in denen "Direct Traffic" eventuell einen immer größeren und zunehmend unerklärlichen Anteil ausmacht.

Tabelle: Vergleich: Client-Side- vs. Server-Side-Tagging für die Datenattribution

Die folgende Tabelle stellt die beiden Ansätze gegenüber und dient als Entscheidungsgrundlage für die strategische Planung der zukünftigen Tracking-Infrastruktur.

| Vergleichskriterium | Client-Side Tagging (Browser) | Server-Side Tagging (Server) |

|---|---|---|

| Performance (Website-Geschwindigkeit) | Potenziell langsamere Ladezeiten durch viele JavaScript-Tags, die im Browser ausgeführt werden. | Schnellere Ladezeiten, da weniger Code im Browser ausgeführt wird. Der Server übernimmt die Last. |

| Datenkontrolle & Sicherheit | Geringere Kontrolle; Browser sendet Daten direkt an Drittanbieter. Risiko der Weitergabe von PII. | Volle Kontrolle über den Datenfluss. Daten können vor der Weitergabe validiert, bereinigt und anonymisiert werden. |

| Tracking-Genauigkeit (vs. Ad-Blocker/ITP) | Hochgradig anfällig für Ad-Blocker und Browser-Restriktionen (ITP), die Skripte und Cookies blockieren. | Deutlich robuster, da die Kommunikation vom eigenen Server ausgeht und viele clientseitige Blocker umgangen werden können. |

| Cookie-Lebensdauer (First-Party) | Clientseitig gesetzte JavaScript-Cookies werden von ITP (Safari) stark in ihrer Lebensdauer beschränkt (oft 7 Tage/24h). | Serverseitig gesetzte HTTP-Cookies unterliegen nicht den gleichen ITP-Beschränkungen und haben eine längere Lebensdauer, was die Nutzererkennung verbessert. |

| Implementierungskomplexität | Relativ einfach und weit verbreitet. Viele "Plug-and-Play"-Lösungen verfügbar. | Komplexer in der Einrichtung und Wartung; erfordert technisches Know-how und Server-Infrastruktur. |

| Kosten | In der Regel kostenlos (abgesehen von den Kosten für Tag-Management-Systeme). | Verursacht laufende Kosten für den Cloud-Server (z.B. Google Cloud Platform), die je nach Traffic-Volumen variieren. |

Strategische Analyse von Direct Traffic in GA4

Die Analyse von Direct Traffic ist weniger eine exakte Wissenschaft als vielmehr eine Form der digitalen Detektivarbeit. Es geht darum, Indizien zu sammeln, Hypothesen zu bilden und die wahrscheinlichste Erklärung für die beobachteten Datenmuster zu finden. GA4 bietet dafür leistungsstarke Werkzeuge, die von einfachen Berichten bis hin zu komplexen explorativen Analysen reichen.

Untersuchung im „Berichte“-Bereich

Der Standardbereich "Berichte" in GA4 ist der erste Anlaufpunkt für eine schnelle Diagnose.

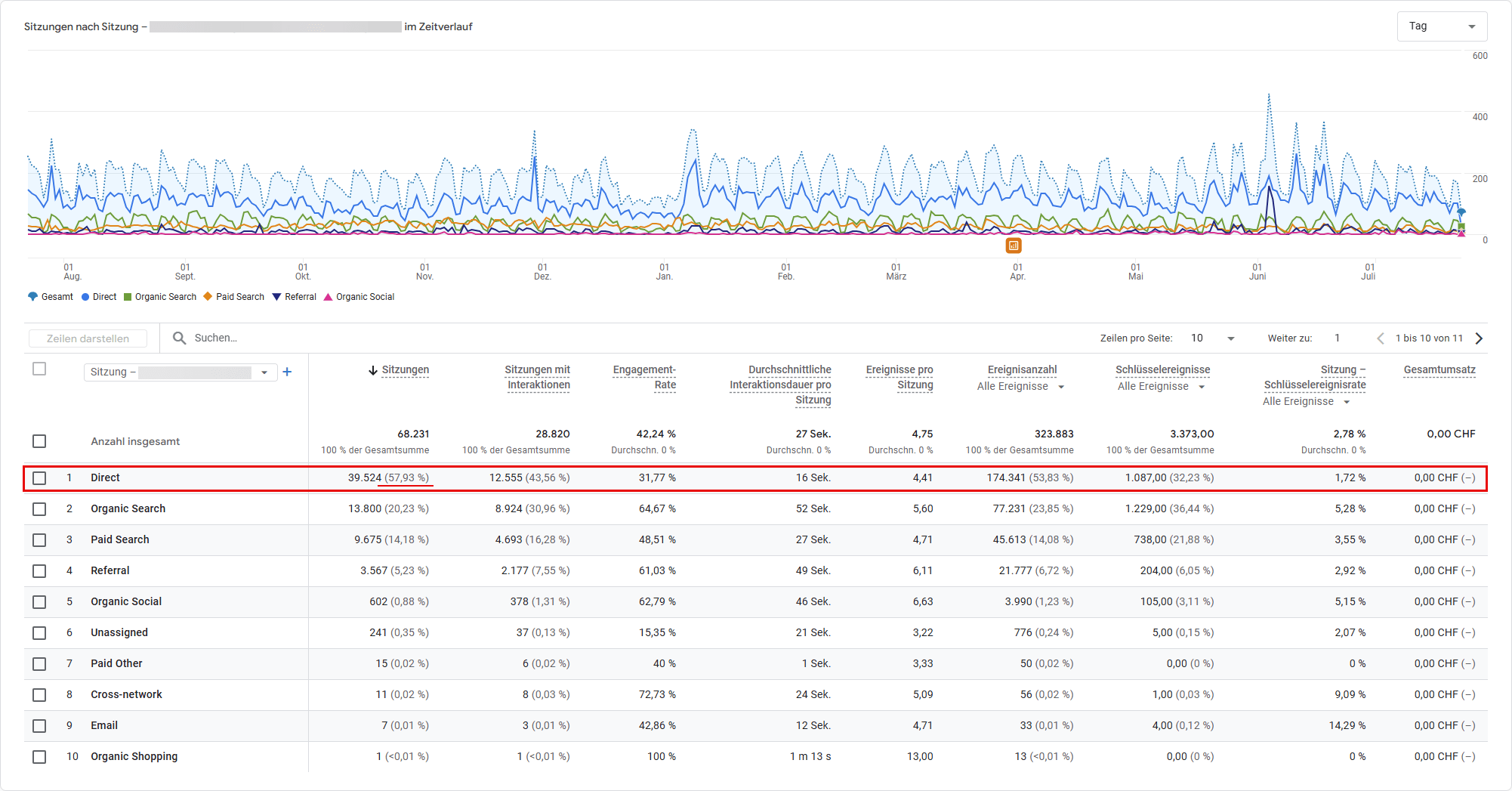

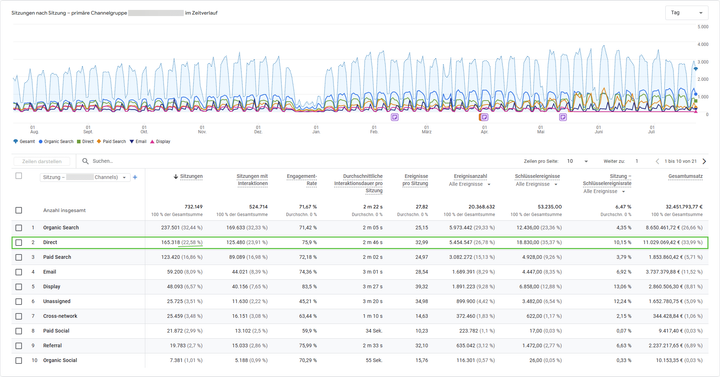

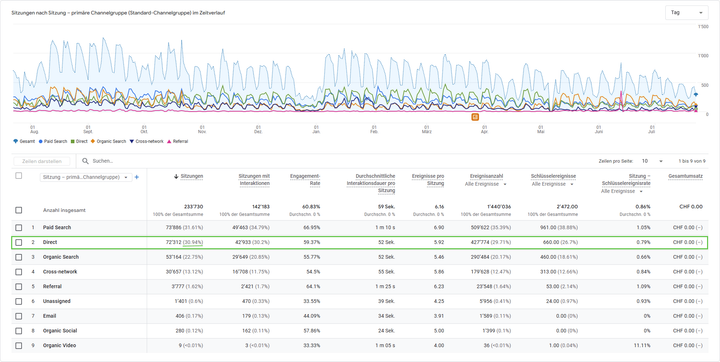

Traffic-Akquise-Bericht: Dieser Bericht (Berichte > Akquisition > Traffic-Akquisition) ist der Ausgangspunkt. In der Standardansicht zeigt die primäre Dimension Sitzung: Standard-Channelgroup den Anteil des Kanals "Direct" am Gesamt-Traffic. Ein erster Blick auf den prozentualen Anteil gibt einen Hinweis darauf, ob ein tiefergehendes Problem vorliegen könnte (typischerweise bei < 20-25%).

Anreicherung mit sekundären Dimensionen: Der eigentliche Analysewert entsteht durch das Hinzufügen von sekundären Dimensionen. Durch Klicken auf das + - Symbol neben der primären Dimension lassen sich weitere Datenebenen einblenden, die entscheidende Hinweise liefern:

Landingpage + Abfragestring: Dies ist wohl die wichtigste sekundäre Dimension zur Entschlüsselung von Direct Traffic. Sie zeigt die genaue URL, auf der die "direkte" Sitzung begonnen hat. Eine Sitzung, die direkt auf der Startseite (/) landet, ist plausibel. Eine Sitzung, die jedoch direkt auf einer langen, komplexen URL wie/blog/2024/07/ein-sehr-spezifischer-artikel-mit-langer-urllandet, ist es nicht. Es ist höchst unwahrscheinlich, dass ein Nutzer eine solche URL manuell eingibt. Dies ist ein klares Indiz für Dark Traffic, dessen Quelle (z.B. ein Link aus einer E-Mail oder einem Social-Media-Post) verschleiert wurde. Durch die Segmentierung nach Landingpages lässt sich der plausible Direct Traffic vom unplausiblen (also Dark Traffic) trennen.Gerätekategorie: Zeigt die Analyse einen überproportional hohen Anteil an Direct Traffic von mobilen Geräten? Dies könnte ein starker Hinweis auf Traffic aus mobilen Apps sein, die keine Referrer-Daten übermitteln.Browser: Ein auffällig hoher Anteil an Safari-Browsern im Direct-Traffic-Segment kann auf die Auswirkungen von Apples Intelligent Tracking Prevention (ITP) hindeuten, die Attributionsketten unterbricht.Land: Ein plötzlicher Spike an Direct Traffic aus einem bestimmten Land oder einer bestimmten Stadt kann auf Bot-Traffic hindeuten. Alternativ könnte er aber auch der Erfolg einer regional ausgerichteten Offline- oder PR-Kampagne sein.

Fortgeschrittene Analyse mit „Explorative Datenanalysen“ (Explorations)

Für tiefere Einblicke und flexible Analysen ist der Bereich "Explorative Datenanalysen" das Werkzeug der Wahl. Er ermöglicht die Erstellung benutzerdefinierter Berichte und die Anwendung von Segmenten.

Segmente erstellen: Dies ist die mächtigste Methode zur Analyse von Nutzergruppen. Man erstellt ein Segment, das ausschließlich Sitzungen oder Nutzer aus dem Kanal "Direct" enthält. Die Bedingung dafür lautet: Sitzung: Standard-Channelgroup enthält Direct .

Verhaltensvergleich: Dieses neu erstellte "Direct Traffic"-Segment kann nun auf beliebige Berichte und explorative Analysen angewendet werden, um das Verhalten dieser Nutzergruppe direkt mit dem Verhalten von Nutzern aus anderen Kanälen (z.B. "Organic Search") zu vergleichen. Wichtige Metriken für diesen Vergleich sind:

Engagement-RateundDurchschnittliche Interaktionsdauer: Sind direkte Besucher signifikant engagierter als andere? Ein Ja wäre ein starkes Indiz für hohe Markenloyalität und Nutzerabsicht.Conversions(Schlüsselereignisse): Weisen direkte Besucher eine höhere Conversion-Rate auf? Dies deutet auf eine hohe Kaufabsicht und eine fortgeschrittene Position im Customer Journey hin.- Trichter-Exploration: Wie verhalten sich direkte Besucher im Vergleich zu organischen Besuchern in einem definierten Conversion Funnel (z.B. vom Produkt zur Kasse zum Kauf)? Steigen sie an späteren Punkten ein oder brechen sie seltener ab?

Hypothesenbildung durch Korrelation

Da viele Quellen von Direct Traffic (insbesondere Offline-Maßnahmen, Dark Social, ungetaggte E-Mails) per Definition nicht direkt messbar sind, ist die Analyse von Korrelationen ein entscheidender Schritt, um ihre Wirkung dennoch abzuschätzen.

- Analyse von Zeitreihen: Der effektivste Ansatz ist die Überlagerung von Zeitreihendiagrammen. Man visualisiert den Verlauf des Direct Traffics über einen bestimmten Zeitraum und trägt die Start- und Enddaten von Marketing-Aktivitäten ein. Ein signifikanter Anstieg (Spike) des Direct Traffics, der zeitlich eng mit dem Versand eines Newsletters, dem Start einer TV-Kampagne oder einer viel beachteten PR-Meldung korreliert, ist ein starkes Indiz für einen kausalen Zusammenhang.

- Verwendung von Anmerkungen (Annotations): Obwohl die Annotations-Funktion in GA4 nicht mehr so prominent ist wie in Universal Analytics, bleibt das Prinzip gültig. Es sollte selbstverständlich sein, einen Marketingkalender zu führen, in dem alle Kampagnenstarts, PR-Aktivitäten und Offline-Events protokolliert werden. Dieser Kalender dient als Referenz, um spätere Spikes im Direct Traffic zu kontextualisieren und Hypothesen über deren Ursprung zu bilden.

Tun Sie sich den Gefallen und dehnen Sie diese Protokollierung auch auf SEO Maßnahmen sowie Layout- und technische Änderungen an ihren Websites aus. Viele SEO Tools bieten ebenfalls die Möglichkeit Notizen zu bestimmten Zeitpunkten zu hinterlegen. Ein plötzlicher Sichtbarkeitsverlust nach z. B. einem Serverwechsel lässt sich so leichter der möglichen Ursache zuordnen.

Die strategische Konsequenz aus diesen Analysemethoden ist die Etablierung eines standardisierten Prozesses. Jeder signifikante, unerklärliche Anstieg im Direct Traffic sollte einen vordefinierten Analyse-Workflow auslösen. Dieser Workflow muss die Überprüfung der Landingpages, der Geräte, der geografischen Herkunft und der zeitlichen Korrelation mit allen laufenden Marketingkampagnen umfassen. Dies wandelt eine passive Datenbeobachtung in ein proaktives System zur Qualitätssicherung des gesamten Marketings um.

Leitfaden zur Reduzierung von fehlerhaft zugewiesenem Direct Traffic

Die Reduzierung von fehlerhaft zugewiesenem Direct Traffic ist kein einmaliges Projekt, sondern ein kontinuierlicher Prozess der Datenhygiene. Das Ziel ist nicht, den Direct Traffic auf Null zu reduzieren – ein gesunder Anteil an echtem Direct Traffic ist wünschenswert. Das Ziel ist, den Anteil des unbekannten und fehlerhaft zugeordneten Traffics zu minimieren, um ein klares und genaues Bild der Marketingleistung zu erhalten. Dies erfordert eine Kombination aus proaktiver Kennzeichnung, technischer Sorgfalt und organisatorischer Disziplin.

UTM-Parameter: Die unverzichtbare Grundlage präziser Messung

Urchin Tracking Module (UTM)-Parameter sind die erste und wichtigste Verteidigungslinie gegen Dark Traffic. Sie sind kurze Code-Schnipsel, die an das Ende einer URL angehängt werden, um Google Analytics explizit mitzuteilen, woher ein Klick stammt. Sie überschreiben die Notwendigkeit, sich auf den oft fehlenden oder unzuverlässigen HTTP-Referrer zu verlassen.

Detaillierte Erläuterung der fünf Parameter:

utm_source: Identifiziert die spezifische Quelle des Traffics. Dies ist die Plattform oder der Ort, an dem der Link platziert wurde (z.B.google,facebook,newsletter_jul25,partner_blog).utm_medium: Beschreibt den allgemeinen Marketing-Kanal oder das Medium. Hier sollten standardisierte Begriffe verwendet werden (z.B.cpc,organic_social,email,affiliate).utm_campaign: Benennt die spezifische Marketingkampagne, zu der der Link gehört. Dies ermöglicht die Bündelung von Aktivitäten (z.B.winter_sale_2025,product_launch_q3).utm_term(optional): Wird hauptsächlich in der bezahlten Suche (Paid Search) verwendet, um das spezifische Keyword zu identifizieren, das den Klick ausgelöst hat.utm_content(optional): Dient der Differenzierung von Links oder Anzeigen innerhalb derselben Kampagne. Dies ist nützlich für A/B-Tests (z.B.blue_buttonvs.text_linkoderimage_ad_v1vs.image_ad_v2).

Anwendungsfälle: Die goldene Regel lautet: UTM-Parameter müssen für alle externen Marketing-Links verwendet werden, deren Performance gemessen werden soll. Dies umfasst, ist aber nicht beschränkt auf:

- Alle Links in E-Mail-Kampagnen und Newslettern.

- Alle Links in organischen und bezahlten Social-Media-Posts.

- Links in den Profilbeschreibungen von Social-Media-Konten.

- QR-Codes in Printanzeigen, auf Flyern oder auf Produktverpackungen.

- Links in herunterladbaren Dokumenten wie PDFs oder Präsentationen.

- Links, die an Affiliates oder Partner weitergegeben werden.

Eine ebenso wichtige Regel ist:

Interne Links (also Links, die von einer Seite Ihrer Website auf eine andere Seite derselben Website verweisen) dürfen niemals mit UTM-Parametern getaggt werden.

Dies würde die ursprüngliche Sitzung des Nutzers überschreiben und die Attributionskette zerstören. Ein Nutzer, der über die organische Suche kam und dann auf einen internen UTM-Link klickt, würde fälschlicherweise einer neuen Sitzung mit der im UTM-Link definierten Quelle zugeordnet werden.

Entwicklung einer UTM-Governance-Richtlinie für Teams

Die bloße Verwendung von UTMs reicht nicht aus. Ohne eine klare, unternehmensweit durchgesetzte Richtlinie führt ihre Nutzung schnell zu Datenchaos. Inkonsistenzen wie facebook vs. Facebook vs. FB führen dazu, dass GA4 drei separate Quellen anzeigt, was die Aggregation und Analyse der Daten unmöglich macht. Eine UTM-Strategie ist daher keine reine Marketing-Aufgabe, sondern eine organisationsübergreifende Disziplin, die eine klare Governance erfordert.

Elemente einer Governance-Richtlinie:

- Benennungskonventionen: Die wichtigste Regel ist Konsistenz. Die Richtlinie sollte festlegen: nur Kleinschreibung, Verwendung von Unterstrichen (

_) oder Bindestrichen (-) anstelle von Leerzeichen und das Verbot von Sonderzeichen. - Standardisierte Taxonomie: Es sollte eine feste, dokumentierte Liste von erlaubten Werten für

utm_mediumund häufig verwendeteutm_source- Werte geben. Dies stellt sicher, dass alle Teammitglieder und Agenturen dieselbe Sprache sprechen. - Verantwortlichkeiten: Es muss eine Person oder eine kleine Gruppe als "Taxonomy Guardian" benannt werden. Diese Rolle ist verantwortlich für die Erstellung und Pflege der Richtlinie, die Schulung von Teammitgliedern und die Überwachung der Datenqualität.

- Dokumentation und Tools: Alle erstellten UTM-Links sollten in einem zentralen, für alle zugänglichen Dokument (z.B. ein geteiltes Spreadsheet oder ein spezialisiertes Tool) protokolliert werden. Dies verhindert Duplikate und fördert die Konsistenz. Während Spreadsheets für den Anfang nützlich sein können, sind spezialisierte UTM-Management-Tools für größere Teams oft die bessere Wahl, da sie weniger fehleranfällig sind und eine bessere Kontrolle ermöglichen.

Tabelle: Beispiel einer UTM-Namenskonvention und Governance-Regeln

Diese Tabelle dient als anpassbare Vorlage für die Erstellung einer eigenen unternehmensinternen Richtlinie.

| Regel / Parameter | Richtlinie | Beispiel |

|---|---|---|

| Allgemeine Regeln | 1. Nur Kleinschreibung verwenden. 2. Leerzeichen durch `_` ersetzen. 3. Keine Sonderzeichen (`?`, `&`, `=`, etc.) in Werten verwenden. | `winter_sale` (nicht `Winter Sale`) |

| utm_medium | Feste Liste von Standardwerten verwenden, um die Kanalgruppierung von GA4 zu unterstützen. | `cpc`, `paid_social`, `organic_social`, `email`, `referral`, `affiliate`, `display`, `offline_media` |

| utm_source | Name der Plattform oder des spezifischen Ortes. Konsistent halten. | `google`, `bing`, `facebook`, `linkedin`, `instagram`, `newsletter_weekly`, `partner_xyz_blog` |

| utm_campaign | Strukturierte, beschreibende Namen verwenden. Format: `[ziel]_[produkt/thema]_[jahr]` | `leadgen_saas-tool_2024` oder `sale_winter-jackets_2024` |

| utm_content | Zur Differenzierung von Creatives oder Links innerhalb einer Kampagne. | `blue_banner_ad`, `header_link`, `video_ad_version_a` |

| Verantwortlichkeit | Der "Taxonomy Guardian" ist verantwortlich. Alle neuen Kampagnen müssen vor dem Start zur Überprüfung vorgelegt werden. | - |

| Tool | Alle UTM-Links müssen über das zentrale Tool generiert und dokumentiert werden. | - |

Technische Audits zur Sicherstellung der Datenhygiene

Neben der proaktiven Kennzeichnung sind regelmäßige technische Überprüfungen unerlässlich, um die Quellen von fehlerhaft zugewiesenem Traffic zu identifizieren und zu beheben.

- Überprüfung der Tracking-Code-Implementierung: Mithilfe von Tools wie dem Google Tag Manager Preview Mode, dem GA4 DebugView oder Browser-Erweiterungen (Empfehlung: Analytics Debugger) muss sichergestellt werden, dass der GA4-Tracking-Tag auf jeder einzelnen Seite der Website korrekt geladen und ausgeführt wird.

- Analyse von Weiterleitungsketten: Tools wie Screaming Frog oder die Entwicklertools des Browsers können verwendet werden, um Weiterleitungsketten zu identifizieren. Lange oder fehlerhafte Ketten, insbesondere solche mit JavaScript-Redirects, müssen korrigiert werden, um sicherzustellen, dass Referrer-Daten und UTM-Parameter nicht verloren gehen.

- Sicherstellung einer vollständigen HTTPS-Migration: Ein Audit muss sicherstellen, dass die gesamte Website ausschließlich über HTTPS erreichbar ist und dass alle internen Links auf die `https` Version verweisen. Dies eliminiert das Problem des Referrer-Verlusts beim HTTPS-zu-HTTP-Übergang.

- Konfiguration der Verweisausschlussliste: In den GA4-Einstellungen (

Admin > Datenstreams > Web > Tag-Einstellungen konfigurieren > Unerwünschte Verweise auflisten) muss überprüft werden, dass die eigene Domain korrekt eingetragen ist, um Self-Referrals zu verhindern. Gleichzeitig muss sichergestellt werden, dass keine legitimen Referrer (z.B. Subdomains von Zahlungsanbietern) fälschlicherweise ausgeschlossen werden.

Die Qualität der Marketing-Analyse-Daten ist direkt proportional zur Strenge der implementierten Tracking-Governance. Investitionen in Tools und Prozesse für saubere UTMs und regelmäßige technische Audits sind keine Kosten, sondern eine Investition in bessere, datengestützte Geschäftsentscheidungen.

Direct Traffic als SEO-Signal: Mythos, Realität und indirekte Hebelwirkung

Die Frage, ob Direct Traffic die SEO-Rankings beeinflusst, ist Gegenstand intensiver Debatten. Während eine direkte Kausalität weitgehend als Mythos gilt, ist die indirekte Hebelwirkung von echtem Direct Traffic auf die SEO-Performance ein entscheidender strategischer Faktor, der oft übersehen wird.

SEOs jagen häufig nach rein technischen Rankingfaktoren, verkennen dabei aber, dass Google zunehmend versucht, die Autorität und Vertrauenswürdigkeit einer Marke in der realen Welt algorithmisch abzubilden.

Korrelation vs. Kausalität: Warum Direct Traffic kein direkter Rankingfaktor ist

Die verbreitete Annahme: Eine oft zitierte Studie von SEMrush aus dem Jahr 2017 stellte einen starken Zusammenhang zwischen hohem Direct Traffic und guten Rankings bei Google fest. Diese Analyse führte dazu, dass viele daraus den Schluss zogen: Je mehr direkte Zugriffe eine Website erhält, desto besser wird sie von Google bewertet. Die These: Google werte Direct Traffic als unmittelbares Rankingsignal.

Die Realität sieht differenzierter aus – und widerspricht dieser Interpretation in zentralen Punkten:

- Google verneint die Nutzung entsprechender Datenquellen: Google hat mehrfach betont, dass Daten aus Google Analytics nicht in den Ranking-Algorithmus einfließen. Zwar hätte Google über andere Kanäle wie den Chrome-Browser theoretisch Zugriff auf Traffic-Daten – doch deren Verwendung als Rankingfaktor wäre aus Datenschutz- und Qualitätsgründen höchst fragwürdig. Zudem ist die Aussage von Google in diesem Punkt seit Jahren konsistent.

- Korrelation ist nicht Kausalität: Ja, es gibt eine Korrelation zwischen hohem Direct Traffic und starken Rankings. Aber das bedeutet nicht, dass der eine Wert den anderen verursacht. Viel wahrscheinlicher ist ein gemeinsamer zugrunde liegender Erfolgsfaktor: Markenstärke, Content-Qualität und Nutzervertrauen. Websites mit hoher Sichtbarkeit, Autorität und überzeugenden Inhalten erzielen automatisch mehr Direktzugriffe – und gleichzeitig bessere Rankings. Beide Effekte resultieren aus einer nachhaltigen digitalen Gesamtstrategie, nicht aus einer mechanischen Wechselwirkung.

- Signalqualität: Direct Traffic als Metrik ist zu "verrauscht" (noisy) und notorisch unpräzise, um als direktes Rankingsignal zu dienen. Wie in den vorherigen Kapiteln gezeigt, verbirgt sich dahinter eine Vielzahl von Quellen, von denen viele nichts mit Markenbekanntheit zu tun haben. Zudem wäre ein solches Signal extrem leicht zu manipulieren, beispielsweise durch den Kauf von Bot-Traffic, was es für Google unbrauchbar machen würde.

Die indirekte Macht von Direct Traffic

Der wahre SEO-Wert von Direct Traffic liegt nicht in einem direkten algorithmischen Input, sondern in seiner starken indirekten Wirkung. Echter, intendierter Direct Traffic ist ein Ergebnis einer erfolgreichen Marken- und Content-Strategie, dessen positive Nebeneffekte wiederum als wertvolle Signale für den Google-Algorithmus dienen können.

Brand Signals: Ein hoher und wachsender Anteil an echtem Direct Traffic ist eines der stärksten denkbaren Signale an Google, dass eine Website eine etablierte Marke und eine anerkannte Autorität in ihrer Nische ist. Wenn Nutzer den Umweg über die Suche bewusst vermeiden, um eine Seite direkt anzusteuern, demonstrieren sie ein Höchstmaß an Vertrauen und Bekanntheit. Google ist bestrebt, solche autoritativen Marken in den Suchergebnissen zu bevorzugen.

Positive Nutzersignale: Direkte Besucher, die eine Marke bereits kennen und ihr vertrauen, zeigen tendenziell ein deutlich positiveres Engagement-Verhalten auf der Website. Diese Nutzersignale kann Google (z.B. über den Chrome-Browser oder aggregierte Daten) erfassen und als Indikatoren für die Qualität und Relevanz einer Seite werten:

- Geringere Absprungrate / Höhere Engagement-Rate: Direkte Besucher wissen, was sie erwartet, es ist daher wahrscheinlicher, dass sie mit der Seite interagieren, mehrere Seiten aufrufen und länger bleiben (--> Long Clicks).

- Längere Verweildauer (Dwell Time): Eine längere Verweildauer signalisiert Google, dass der Inhalt für den Nutzer wertvoll und relevant ist und seine Suchintention erfüllt.

- Höhere Rate an wiederkehrenden Besuchern: Eine loyale, wiederkehrende Nutzerschaft ist ein klares Zeichen für eine qualitativ hochwertige Website.

E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness): Das Konzept von E-E-A-T ist ein zentraler Bestandteil von Googles Qualitätsrichtlinien. Eine starke, loyale und direkt zugreifende Besucherschaft ist der ultimative Beweis für Vertrauen (Trustworthiness) und Autorität (Authoritativeness). Wenn Nutzer eine Website als ihre primäre Anlaufstelle für ein bestimmtes Thema betrachten und sie direkt ansteuern, anstatt zu suchen, untermauert dies den E-E-A-T-Status der Seite auf eine Weise, die durch Backlinks allein kaum erreicht werden kann.

Die strategische Implikation dieser Erkenntnis ist tiefgreifend:

Die beste SEO-Strategie ist nicht nur, für Keywords zu optimieren, sondern eine Marke aufzubauen, die so stark und vertrauenswürdig ist, dass Nutzer die Suche aktiv umgehen, um direkt zur Website zu gelangen.

SEO und Branding sind keine getrennten Disziplinen mehr, sondern zwei Seiten derselben Medaille. Die Steigerung des echten Direct Traffics sollte daher ein explizites und zentrales Ziel jeder langfristigen, nachhaltigen SEO-Strategie sein.

Strategien zur Steigerung von echtem Direct Traffic und Markenwert

Nachdem die technischen Aspekte und die SEO-Implikationen von Direct Traffic beleuchtet wurden, konzentriert sich dieses letzte Kapitel auf konkrete, umsetzbare Strategien, um den "guten", intendierten Anteil des Direct Traffics aktiv zu fördern.

Diese Maßnahmen zielen nicht auf kurzfristige Hacks ab, sondern auf den langfristigen Aufbau von Markenwert und Nutzerloyalität. Interessanterweise sind die besten Strategien zur Steigerung des echten Direct Traffics gleichzeitig auch exzellente SEO-Praktiken, was die Symbiose zwischen Branding und SEO unterstreicht.

Aufbau von Markenbekanntheit (Brand Recall)

Das Fundament für echten Direct Traffic ist, dass sich Nutzer an die Marke und ihre URL erinnern können.

- Konsistentes und einprägsames Branding: Dies beginnt mit den Grundlagen. Ein kurzer, leicht zu merkender und zu buchstabierender Domainname ist von unschätzbarem Wert. Gepaart mit einem wiedererkennbaren Logo und einem konsistenten visuellen Auftritt (Farben, Schriftarten) über alle Kanäle hinweg – von der Website über Social Media bis hin zu E-Mail-Signaturen – schafft dies eine starke, einprägsame Markenidentität.

- Integration von Online- und Offline-Kanälen: Jede Offline-Interaktion ist eine Chance, die Marke im Gedächtnis zu verankern. Ob durch Printwerbung, Radio- oder TV-Spots, Sponsoring von Events oder PR-Arbeit – das Ziel ist immer, den Markennamen und die Website-URL so zu kommunizieren, dass sie im Gedächtnis bleiben und zu einer späteren direkten Eingabe im Browser führen.

- Storytelling und emotionale Verbindung: Marken, die eine fesselnde Geschichte erzählen und eine emotionale Verbindung zu ihrer Zielgruppe aufbauen, bleiben besser im Gedächtnis. Inhalte, die nicht nur informieren, sondern auch unterhalten, inspirieren oder berühren, schaffen eine tiefere Bindung, die über eine rein transaktionale Beziehung hinausgeht und Loyalität fördert.

Optimierung der User Experience (UX)

Eine positive Nutzererfahrung ist entscheidend dafür, dass Besucher nicht nur einmal kommen, sondern auch wiederkehren wollen.

- Website-Geschwindigkeit und Performance: Eine langsame Website ist einer der größten Konversions- und Loyalitätskiller. Studien zeigen, dass Nutzer mobile Seiten, die länger als drei Sekunden zum Laden benötigen, in großer Zahl verlassen. Eine schnelle, reaktionsfähige Website ist keine Option, sondern eine Grundvoraussetzung, um Besucher zum Wiederkommen zu bewegen.

- Intuitive Navigation und Informationsarchitektur: Nutzer müssen in der Lage sein, schnell und mühelos zu finden, was sie suchen. Eine klare, logische Menüstruktur, eine gut funktionierende interne Suche und eine durchdachte Informationsarchitektur reduzieren die Frustration und erhöhen die Wahrscheinlichkeit, dass ein Nutzer die Seite als nützlich empfindet und für zukünftige Besuche speichert.

- Mobile-First-Design: Da ein Großteil des Webtraffics heute über mobile Geräte erfolgt, ist eine exzellente mobile User Experience unerlässlich. Eine Website, die auf dem Desktop gut funktioniert, aber auf dem Smartphone unübersichtlich oder schwer zu bedienen ist, wird mobile Nutzer dauerhaft verprellen.

Content-Marketing-Strategien

Content ist der primäre Hebel, um Nutzer so sehr zu beeindrucken, dass sie eine Website als unverzichtbare Ressource betrachten.

Erstellung von "Bookmark-würdigem" Content: Dies geht über Standard-Blogposts hinaus. Es geht um die Erstellung von Inhalten mit außergewöhnlichem Wert, die Nutzer speichern und wiederholt aufrufen möchten. Beispiele hierfür sind:

- Umfassende Leitfäden und Whitepaper

- Interaktive Tools, Rechner oder Konfiguratoren

- Regelmäßig aktualisierte Daten-Ressourcen oder Branchenberichte

- Detaillierte Anleitungen und Tutorials.

Aufbau von Themenautorität (Topical Authority): Die systematische Anwendung des Pillar-Cluster-Modells ermöglicht es Websites, sich als zentrale Instanz für ein spezifisches Themenfeld zu positionieren. Dabei fungiert die Pillar Page als umfassender Einstiegspunkt, der das übergeordnete Kernthema strukturiert und einordnet. Ergänzend dazu vertiefen zahlreiche Cluster-Artikel einzelne Aspekte, Fragestellungen und Long-Tail-Keywords – und verlinken dabei konsequent zur Pillar Page sowie untereinander.

Dieses strukturierte Content-Ökosystem hat mehrere strategische Vorteile:

- Aus SEO-Sicht stärkt es die interne Verlinkung, erleichtert Suchmaschinen das Verständnis thematischer Zusammenhänge und erhöht die semantische Relevanz der Domain.

- Aus Nutzersicht entsteht ein konsistentes Informationsangebot, das nicht nur einzelne Fragen beantwortet, sondern ein Thema ganzheitlich erschließt.

Wenn Nutzer wiederholt erleben, dass eine Website zu einem bestimmten Themenkomplex die fundiertesten, aktuellsten und praxisnahsten Inhalte liefert, entsteht Vertrauen – und damit die Bereitschaft, beim nächsten Informationsbedarf direkt auf diese Quelle zuzugreifen, anstatt erneut über Google zu suchen.

Genau hier liegt der indirekte SEO-Effekt: Wiederkehrender Direct Traffic, hohe Verweildauer und positive Nutzersignale sind typische Begleiterscheinungen starker Themenautorität – und können langfristig die Sichtbarkeit in Suchmaschinen zusätzlich stützen.

Aufbau von Themenautorität

durch das Pillar-Cluster-Modell

Das Pillar-Cluster-Modell

Pillar Page

Kernthema Hub

Long-Tail Keywords

Spezifische Fragen

Detailaspekte

Vertiefende Inhalte

Themenerweiterung

Praxisbeispiele

Strategische Vorteile

SEO Maßnahmen

Stärkung der internen Verlinkung, besseres Verständnis thematischer Zusammenhänge für Suchmaschinen und erhöhte semantische Relevanz der Domain.

Nutzererfahrung

Konsistentes Informationsangebot, das nicht nur einzelne Fragen beantwortet, sondern ein Thema ganzheitlich und strukturiert erschließt.

Vertrauensaufbau

Durch fundierte, aktuelle und praxisnahe Inhalte entsteht Vertrauen und die Bereitschaft zu direktem Zugriff statt erneuter Google-Suche.

🎯 Indirekte SEO-Effekte der Themenautorität

Wiederkehrende Besucher

Längere Sitzungen

Positive Interaktionen

Bessere Rankings

"Starke Themenautorität führt zu messbaren SEO-Verbesserungen durch positive Nutzersignale"

Wenn Sie sich umfangreich über Content Marketing informieren wollen, klicken Sie bitte hier.

E-Mail-Newsletter und Community Building: Ein regelmäßiger, wertvoller Newsletter ist ein mächtiges Werkzeug, um eine direkte und persönliche Beziehung zur Zielgruppe aufzubauen. Er hält die Marke im Bewusstsein der Nutzer und liefert einen konstanten Anlass für wiederkehrende, direkte Besuche auf der Website. Die Schaffung einer Community, z.B. über ein Forum oder eine exklusive Gruppe, kann diesen Effekt noch verstärken.

Diese Strategien schaffen eine positive Rückkopplungsschleife: Exzellenter Content und eine starke Marke führen zu mehr echtem Direct Traffic. Die damit verbundenen positiven Nutzersignale (hohes Engagement, lange Verweildauer) verbessern die SEO-Rankings. Bessere Rankings führen zu mehr organischem Traffic. Ein Teil dieser neuen organischen Besucher lernt die Marke kennen und schätzen und wird in Zukunft zu loyalen, direkten Besuchern. Anstatt "Direct Traffic" und "Organic Traffic" als getrennte Ziele zu betrachten, sollten Unternehmen eine ganzheitliche Strategie verfolgen, die darauf abzielt, die beste und vertrauenswürdigste Ressource für ihre Zielgruppe zu werden.

Zusammenfassung und Ausblick: Die Zukunft der Attribution im Post-Cookie-Zeitalter

Die detaillierte Analyse des Direct Traffics offenbart ein komplexes und oft missverstandenes Feld der Webanalyse, das für eine erfolgreiche SEO- und Marketingstrategie von entscheidender Bedeutung ist. Die wichtigsten Erkenntnisse lassen sich wie folgt zusammenfassen:

- Direct Traffic ist ein zweischneidiges Schwert: Er ist gleichzeitig ein äußerst wertvoller Key Performance Indicator für Markenstärke, Nutzerloyalität und den Erfolg von Offline-Kampagnen, aber auch ein alarmierendes Symptom für technische Tracking-Schwächen, Datenlücken und die Grenzen der digitalen Messbarkeit. Eine undifferenzierte Betrachtung führt unweigerlich zu falschen strategischen Schlussfolgerungen.

- Die Unterscheidung ist eine Kernkompetenz: Die Fähigkeit, durch gezielte Analyse zwischen echtem, intendiertem Direct Traffic und fehlerhaft zugewiesenem "Dark Traffic" zu unterscheiden, ist eine entscheidende Kompetenz für moderne Marketer und SEOs. Die Analyse von Landingpages, Gerätekategorien und zeitlichen Korrelationen ist hierfür unerlässlich.

- Datenhygiene ist proaktiv, nicht reaktiv: Die Lösung für ungenaue Daten und einen aufgeblähten Direct-Kanal liegt nicht in der nachträglichen Korrektur, sondern in proaktiver Datenhygiene. Eine strenge, unternehmensweite UTM-Governance ist die wichtigste Maßnahme, ergänzt durch regelmäßige technische Audits der Website und des Tracking-Setups.

- Der SEO-Einfluss ist indirekt, aber immens: Während Direct Traffic kein direkter Rankingfaktor ist, ist sein indirekter Einfluss auf die SEO-Performance über Brand Signals und positive Nutzersignale gewaltig. Eine loyale, direkt zugreifende Nutzerschaft ist der stärkste Beleg für die Autorität und Vertrauenswürdigkeit (E-E-A-T) einer Marke – ein Faktor, den Google zunehmend zu bewerten versucht.

Ausblick:

Die Bedeutung des Verständnisses von Direct Traffic wird in der nahen Zukunft weiter zunehmen.

Wir bewegen uns unaufhaltsam in eine Ära mit zunehmenden Datenschutzbeschränkungen, dem Ende der Third-Party-Cookies und einer wachsenden Skepsis der Nutzer gegenüber Tracking. In diesem Umfeld werden traditionelle Attributionsmodelle, die auf der lückenlosen Verfolgung von Nutzern über verschiedene Websites hinweg basieren, an ihre Grenzen stoßen.

Die strategischen Implikationen sind klar:

- First-Party-Daten werden zum entscheidenden Gut: Die Fähigkeit, Daten direkt von den eigenen Nutzern (mit deren Zustimmung) zu sammeln und zu nutzen, wird zum zentralen Wettbewerbsvorteil.

- Server-Side Tagging wird zum Standard: Technologien wie serverseitiges Tagging, die eine größere Kontrolle über die eigenen Daten ermöglichen und die Auswirkungen von clientseitigen Blockern abmildern, werden von einer Nischenlösung zum Industriestandard für Unternehmen, die auf präzise Daten angewiesen sind.

- Der Fokus verschiebt sich zur Markenbildung: Wenn die granulare Attribution einzelner Touchpoints immer schwieriger wird, gewinnen übergeordnete Metriken an Bedeutung. Die Messung und Steigerung der Markenstärke, für die der echte Direct Traffic ein wichtiger Proxy-KPI ist, rückt ins Zentrum der Marketingstrategie.

Letztendlich ist die Auseinandersetzung mit Direct Traffic mehr als nur eine technische Übung. Sie zwingt Unternehmen dazu, sich auf das Wesentliche zu konzentrieren: eine starke Marke aufzubauen, eine herausragende Nutzererfahrung zu bieten und Inhalte von so hohem Wert zu schaffen, dass die Nutzer den Weg direkt zu ihnen finden – ohne den Umweg über eine Suchmaschine.

In einer zunehmend "dunklen" Tracking-Landschaft wird dies der hellste Leuchtturm für nachhaltigen Erfolg sein.