Schlechtes Webhosting: Der aktive Saboteur Ihrer SEO-Performance

Ihre SEO-Strategie ist nur so stark wie ihr technisches Fundament. Die Wahl des richtigen Hosters ist keine Nebensache, sondern die entscheidende Basis für Performance, Sicherheit und Top-Rankings.

Schlechtes Webhosting verhindert gute Rankings. Es untergräbt die drei entscheidenden Säulen der modernen, nutzerzentrierten SEO: Die technische Performance, die Sicherheit der Plattform und die Fähigkeit zur datengestützten Analyse.

Ein minderwertiges Hosting wirkt sich direkt auf messbare Rankingfaktoren aus, sendet negative Signale an Suchmaschinen wie Google und macht eine proaktive, strategische Optimierung unmöglich.

Das oft übersehene Standbein in der Suchmaschinenoptimierung

In der Suchmaschinenoptimierung fokusiert man häufig auf die bekannten Säulen hochwertiger Content und starkes Backlink-Profil. Das technische Fundament, auf dem eine Website aufgebaut ist – das Webhosting – wird hingegen fälschlicherweise häufig wenig beachtet und als austauschbare Ware betrachtet. Diese Fehleinschätzung ist strategisch fatal, da selbst die ausgefeilteste On-Page-Optimierung und die wertvollsten Inhalte durch eine mangelhafte oder unzureichende Serverinfrastruktur systematisch untergraben werden können.

Wir schauen uns die Zusammenhänge an Hand von vier Kernbereichen an:

- Performance & Verfügbarkeit: Wie Serverleistung direkt in Ranking-Signale übersetzt wird.

- Veraltete Technologie & Sicherheit: Wie Software-Mängel zu direkten Google-Abstrafungen und Ranking-Verlusten führen.

- Moderne Webtechnologien: Wie die fehlende Unterstützung für moderne Standards die Wettbewerbsfähigkeit untergräbt.

- Diagnostische Fähigkeiten: Wie das Fehlen von Log-Dateien eine strategische SEO unmöglich macht.

Teil I: Die Performance-Achse – Geschwindigkeit und Verfügbarkeit als Ranking-Faktoren

Dieser Teil analysiert, wie die Kernleistungskennzahlen eines Servers – seine Erreichbarkeit und Reaktionsgeschwindigkeit – direkte und indirekte Ranking-Faktoren für Suchmaschinen wie Google darstellen.

Die Performance des Hostings ist keine abstrakte technische Eigenschaft, sondern die unmittelbare Grundlage für die Nutzererfahrung und die maschinelle Bewertbarkeit einer Website.

Serververfügbarkeit (Uptime): Die Grundvoraussetzung für Sichtbarkeit

Die Serververfügbarkeit, oder Uptime, bezeichnet den prozentualen Anteil der Zeit, in der eine Website online und sowohl für menschliche Nutzer als auch für Suchmaschinen-Crawler erreichbar ist. Eine hohe Verfügbarkeit ist die absolute Grundvoraussetzung für jegliche Form von digitaler Sichtbarkeit.

Wenn der Googlebot versucht, eine Website zu crawlen, die nicht erreichbar ist, erhält er einen Server-Fehlercode. Typischerweise ist dies ein 503 Service Unavailable für temporäre Ausfälle, wie sie bei Serverwartungen oder Überlastungen auftreten. Google interpretiert 5xx-Fehler als kritisches Serverproblem.

Die direkte automatische Reaktion darauf ist eine Reduzierung der Crawl-Frequenz für die betroffene Domain. Dies geschieht, um den potenziell überlasteten Server zu schützen und keine weiteren Ressourcen zu verschwenden.

Während Google bei kurzen, vereinzelten Ausfällen die Seite zu einem späteren Zeitpunkt erneut besucht, signalisieren wiederholte oder länger andauernde Ausfälle eine fundamentale Unzuverlässigkeit. Dies führt unweigerlich zu negativen Konsequenzen. Bereits indexierte URLs, die wiederholt nicht erreichbar sind, werden aus dem Suchindex entfernt, da Google seinen Nutzern keine fehlerhaften oder nicht funktionierenden Ergebnisse präsentieren will. Der Schaden durch Downtime ist oft größer als angenommen. Der Unterschied zwischen einer scheinbar guten Uptime von 99 % und einer exzellenten Uptime von 99,9 % ist in der Praxis enorm. 99 % Uptime bedeuten fast 88 Stunden oder 3,7 Tage Ausfallzeit pro Jahr, während 99,9 % lediglich ca. 8,8 Stunden bedeuten. Diese Ausfallzeiten können, insbesondere wenn sie während Phasen hoher Crawl-Aktivität auftreten, zu massivem Traffic-Verlust und zur De-Indexierung führen.

Die Kausalkette ist hier eindeutig: Ein günstiger "Billighoster" setzt oft auf überlastete Server oder eine mangelhafte Infrastruktur, was zu häufigeren und längeren Ausfällen führt. Jeder dieser Ausfälle liefert dem Googlebot einen 5xx-Fehlercode. Googles eigene Dokumentation bestätigt, dass dies die Crawl-Rate drosselt. Kann der Crawler eine Seite wiederholt nicht erreichen, wird sie als unzuverlässig eingestuft und aus dem Index entfernt, um die Qualität der Suchergebnisse zu sichern. Folglich ist die in den Service Level Agreements (SLA) eines Hosters garantierte Uptime ein direkter Indikator für das Risiko einer De-Indexierung. Eine garantierte Uptime unter 99,9 % stellt ein inakzeptables SEO-Risiko dar.

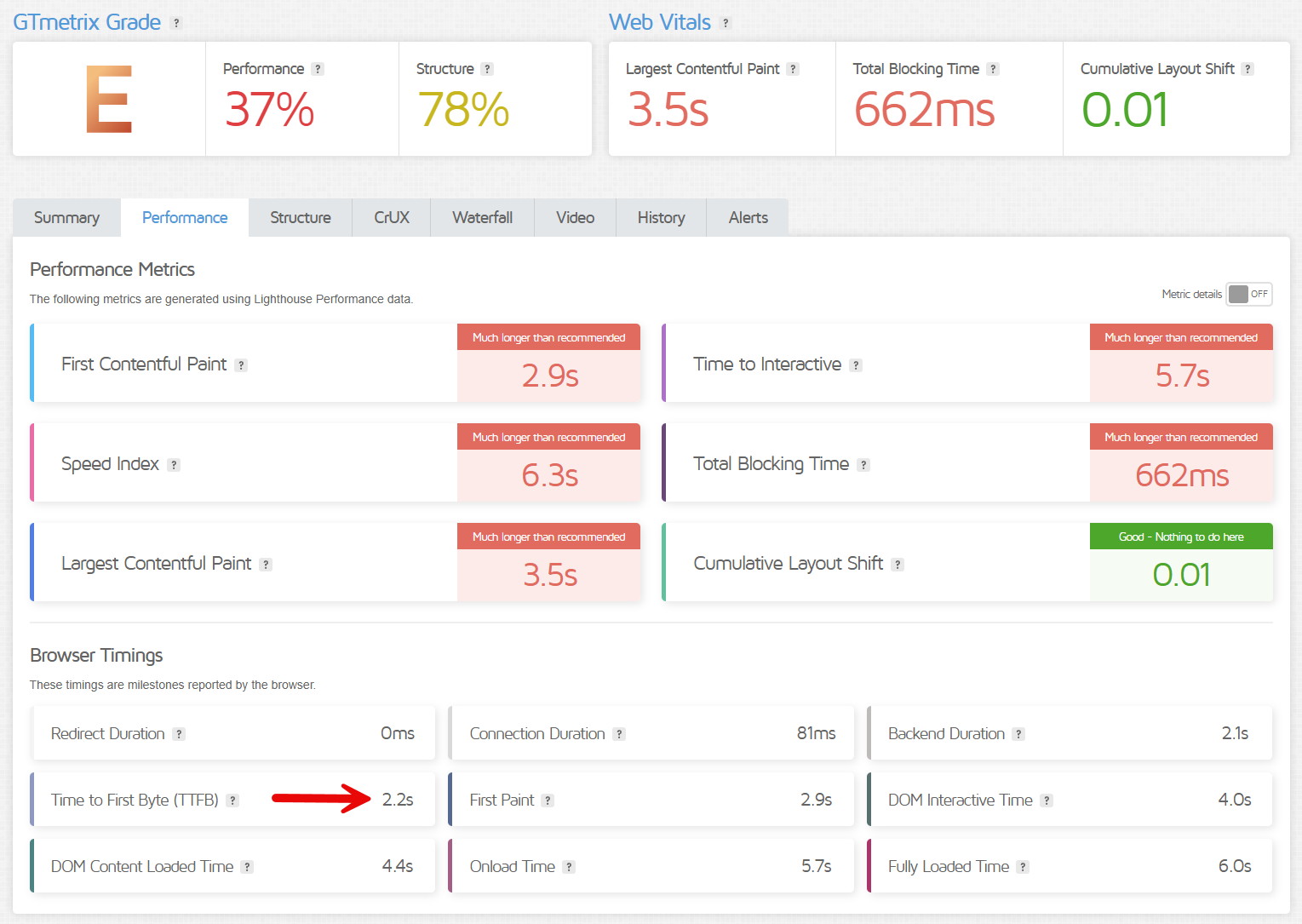

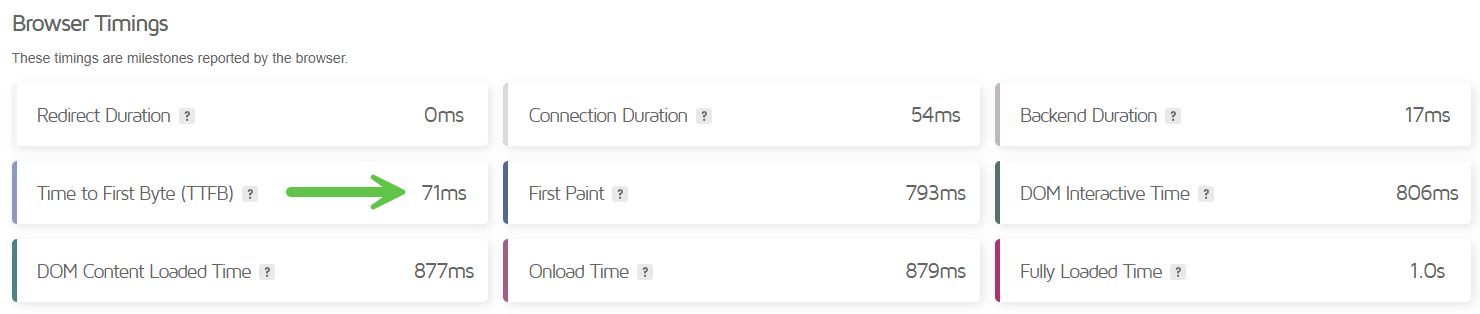

Time to First Byte (TTFB): Das erste Signal an Google und Nutzer

Die Time to First Byte (TTFB) misst die Zeitspanne von der initialen Anfrage eines Browsers bis zum Eintreffen des allerersten Datenbytes vom Server. Sie ist ein fundamentaler Indikator für die Reaktionsfähigkeit eines Servers und setzt sich aus mehreren Phasen zusammen: Der DNS-Lookup-Zeit, dem TCP-Verbindungsaufbau, der SSL/TLS-Verhandlung und der eigentlichen Serververarbeitungszeit. Ein hoher TTFB-Wert ist fast immer ein direktes Symptom eines langsamen, überlasteten oder schlecht konfigurierten Servers.

Bei minderwertigem Hosting sind die Ursachen für eine hohe TTFB vielfältig:

- Server-Überlastung: In typischen Shared-Hosting-Umgebungen teilen sich zahlreiche Websites begrenzte CPU- und RAM-Ressourcen. Ein Traffic-Anstieg auf einer "Nachbar-Website" kann die Leistung aller anderen Websites auf dem Server beeinträchtigen und deren TTFB massiv erhöhen.

- Ineffiziente Datenbanken: Langsame oder schlecht optimierte Datenbankabfragen sind eine der häufigsten Ursachen für lange Serververarbeitungszeiten.

- Fehlendes serverseitiges Caching: Ohne effektive Caching-Mechanismen muss der Server bei jeder einzelnen Anfrage die Webseite dynamisch neu aus Datenbanken und Code generieren. Dies ist extrem rechenintensiv und erhöht die TTFB dramatisch.

Die SEO-Implikationen einer hohen TTFB sind gravierend. Da der Browser erst mit dem Rendern der Seite beginnen kann, nachdem das erste Byte empfangen wurde, ist eine hohe TTFB ein direkter Vorläufer für einen schlechten Largest Contentful Paint (LCP), einen der drei Core Web Vitals.

Google empfiehlt als Richtwert eine TTFB von unter 800 Millisekunden (ms), während Werte über 1800 ms als "schlecht" gelten. Für den Nutzer bedeutet eine hohe TTFB eine lange Wartezeit vor einer leeren, weißen Seite. Dies führt zu Frustration und einer erhöhten Absprungrate, was wiederum ein starkes negatives Nutzersignal an Google sendet.

Ich empfehle, eine TTFB anzustreben, die unter 200 ms liegt. Das gilt besonders für den Ecommerce-Bereich. Lange Seitenladezeiten führen nachweislich zu deutlich schlechteren Conversions.

Eine hohe TTFB ist somit mehr als nur eine Geschwindigkeitsmetrik; sie ist ein wichtiger Gesundheitsindikator des gesamten Hosting-Stacks. Ein schlechter Wert entlarvt fast immer systemische Mängel auf dem Server.

Die Kausalkette ist hier doppelt schädlich: Ein langsamer Server führt zu einem hohen TTFB-Wert. Diese Verzögerung verschiebt den Startpunkt für alle nachfolgenden Lademetriken, was den LCP-Wert per Definition verschlechtert und die Core Web Vitals direkt beeinträchtigt. Gleichzeitig nimmt der Nutzer eine inakzeptable Verzögerung wahr und verlässt die Seite, was die Absprungrate erhöht. Google erhält somit zwei klar negative Signale: schlechte technische Metriken und schlechte Nutzersignale. Eine hohe TTFB ist daher ein doppelter Schlag gegen das Ranking.

Core Web Vitals (CWV): Die Übersetzung von Server-Performance in Google-Rankings

Die Core Web Vitals (CWV) sind von Google definierte Metriken, die reale Nutzererfahrungen in den drei Kernbereichen Ladezeit, Interaktivität und visuelle Stabilität messen. Sie sind ein offiziell bestätigter Bestandteil des "Page Experience"-Signals und somit ein direkter Rankingfaktor. Das Hosting hat einen grundlegenden Einfluss auf diese Metriken.

- Largest Contentful Paint (LCP): Misst die Ladezeit des größten sichtbaren Inhaltselements. Dieser Wert wird direkt von der Server-Antwortzeit (TTFB), der Geschwindigkeit der Ressourcen-Auslieferung (z.B. Bilder, CSS) und der Netzwerklatenz beeinflusst. Ein langsamer Server führt unweigerlich zu einem schlechten LCP-Wert.

- Interaction to Next Paint (INP): Misst die Reaktionsfähigkeit der Seite auf Nutzerinteraktionen (Klicks, Taps). Obwohl dies stark von clientseitigem JavaScript abhängt, kann ein überlasteter Server, der API-Anfragen oder Daten nur langsam verarbeitet, die gesamte Reaktionsfähigkeit einer Anwendung negativ beeinflussen.

- Cumulative Layout Shift (CLS): Misst die visuelle Stabilität einer Seite während des Ladens. Unerwartete Layout-Verschiebungen werden oft durch Ressourcen (Bilder, Werbebanner, Schriftarten) verursacht, die verzögert geladen werden und bereits gerenderte Inhalte verschieben. Ein langsamer Server, der diese Ressourcen nur zögerlich ausliefert, kann CLS-Probleme erheblich verschärfen.

Die Core Web Vitals sind die Brücke, die eine abstrakte Serverleistung (wie CPU-Kapazität oder I/O-Geschwindigkeit) in einen konkreten, messbaren und von Google für das Ranking genutzten Faktor übersetzt.

Ein Hoster verkauft nicht nur "Serverplatz", sondern die technische Grundlage für gute oder schlechte CWV-Werte. Ein minderwertiges Hosting-Paket mit unzureichenden oder geteilten Ressourcen führt zwangsläufig zu langsamen Server-Antwortzeiten und einer verzögerten Auslieferung von Ressourcen. Dies resultiert direkt in schlechten LCP- und CLS-Werten. Die Website besteht den Core Web Vitals-Test in der Google Search Console nicht und erhält einen Malus durch das Page Experience-Signal, was zu schlechteren Rankings führt, selbst wenn der Inhalt exzellent ist.

Die folgende Tabelle fasst die Metriken, ihre Schwellenwerte und die primären Hosting-Einflussfaktoren zusammen.

| Metrik | Definition | Grenzwert 'Gut' | Grenzwert 'Schlecht' | Primäre Hosting-Einflussfaktoren |

|---|---|---|---|---|

| LCP (Largest Contentful Paint) | Zeit bis zum Rendern des größten sichtbaren Elements (Bild, Textblock). Misst die wahrgenommene Ladezeit. | ≤2.5 Sekunden | >4.0 Sekunden | Server-Antwortzeit (TTFB), Server-Bandbreite, Ressourcen-Komprimierung, CDN-Nutzung, Serverstandort |

| INP (Interaction to Next Paint) | Latenzzeit aller Nutzerinteraktionen (Klicks, Taps) während des gesamten Besuchs. Misst die Reaktionsfähigkeit. | ≤200 Millisekunden | >500 Millisekunden | Server-Verarbeitungszeit für Backend-Anfragen, allgemeine Serverlast |

| CLS (Cumulative Layout Shift) | Summe aller unerwarteten Layout-Verschiebungen während des Ladens. Misst die visuelle Stabilität. | ≤0.1 | >0.25 | Geschwindigkeit der Auslieferung von Ressourcen (Bilder, Fonts, Ads), die Layout-Verschiebungen verursachen können |

Tabelle 1: Google Core Web Vitals - Metriken, Schwellenwerte und Hosting-Einflussfaktoren.

Der Faktor Serverstandort

Der physische Standort des Servers ist ein oft unterschätzter, aber kritischer Faktor mit dreifacher Wirkung auf die SEO-Performance.

Erstens beeinflusst die geografische Distanz zwischen Server und Nutzer direkt die Latenz. Jede Datenanfrage muss diese Distanz physisch überwinden. Für eine Website, die sich primär an ein deutsches Publikum richtet, bietet ein Serverstandort in Deutschland signifikant niedrigere Latenzzeiten und somit eine schnellere TTFB und Ladezeit als ein Server in den USA oder Asien.

Geografische Distanz = Höhere Latenz

Warum Serverstandorte für deutsche Websites entscheidend sind

TTFB: Spürbar langsamer

Nutzererfahrung: Verzögerung merkbar

TTFB: Optimal

Nutzererfahrung: Blitzschnell

TTFB: Deutlich schlechter

Nutzererfahrung: Frustrierend langsam

🎯 Fazit für deutsche Websites

Die physische Entfernung zwischen Server und Nutzer kann die Latenz um das 9-fache erhöhen. Ein deutscher Serverstandort bietet nicht nur die beste Performance für deutsche Nutzer, sondern auch signifikant bessere TTFB-Werte und damit bessere Core Web Vitals für Google Rankings.

Zweitens ist der Serverstandort ein Relevanzsignal für die lokale SEO. Suchmaschinen können die IP-Adresse des Servers geografisch zuordnen. Wenn eine Website mit einer .de-Domain und deutschsprachigem Inhalt auch auf einem Server in Deutschland gehostet wird, ist dies ein starkes, konsistentes Signal für die Relevanz für den deutschen Markt. Das geht noch weiter: Wenn ein Nutzer beispielsweise nach "Bäckerei in Berlin" sucht, werden Websites, die auf Servern in oder nahe Berlin gehostet werden, tendenziell als relevanter eingestuft, sofern andere Ranking-Faktoren ebenfalls stimmen.

Drittens spielen rechtliche Aspekte eine Rolle. Ein Serverstandort in Deutschland unterliegt den strengen Anforderungen der Datenschutz-Grundverordnung (DSGVO). Dies bietet eine höhere Rechtssicherheit im Vergleich zu Standorten außerhalb der EU, insbesondere den USA, wo Gesetze wie der CLOUD Act den Zugriff von US-Behörden auf Daten erleichtern können. Während dies kein direkter SEO-Faktor ist, ist es ein entscheidender Geschäftsfaktor.

Die anfängliche Kostenersparnis durch einen günstigeren Hoster im Ausland führt somit oft zu schlechterer Performance, potenziell schwächeren lokalen Rankings und rechtlichen Risiken. Für international agierende Websites kann ein Content Delivery Network (CDN) diese Nachteile teilweise ausgleichen, indem es Inhalte auf weltweit verteilten Servern zwischenspeichert. Schlechte Hoster bieten jedoch oft keine oder nur eine mangelhafte CDN-Integration an.

Teil II: Veraltete Software – es drohen Sicherheits- und Ranking-Katastrophen

Dieser Teil beleuchtet, wie veraltete Softwarekomponenten auf einem Server nicht nur ein Sicherheitsrisiko darstellen, sondern auch direkte und verheerende Auswirkungen auf die SEO-Performance haben können.

Sicherheitslücken als direktes SEO-Risiko

Günstige oder schlecht gewartete Hosting-Anbieter versäumen es oft, die Server-Software wie PHP-Versionen, Webserver (Apache, Nginx) oder Datenbanken zeitnah zu aktualisieren. Veraltete Software – sei es auf Serverebene oder auf Anwendungsebene wie bei einem veralteten WordPress-Core, Plugins oder Themes – ist der häufigste Angriffsvektor für Hacker, da die entsprechenden Sicherheitslücken öffentlich bekannt und leicht auszunutzen sind. Eine Studie zeigt, dass 60 % der gehackten WordPress-Websites auf veralteter Software liefen.

Die Konsequenzen eines Hacks für die SEO sind katastrophal. Angreifer schleusen Malware ein, die Besucher infiziert, oder platzieren versteckte Spam-Links und -Seiten zu Themen wie Glücksspiel oder Pharma auf der Website. Oft werden auch bösartige Weiterleitungen eingerichtet, die Nutzer unbemerkt auf Phishing-Seiten oder Fake-Shops umleiten.

Google reagiert auf solche Kompromittierungen schnell und rigoros. Der Googlebot erkennt gehackte Inhalte und die Website wird in den Suchergebnissen mit Warnhinweisen wie "Diese Website wurde möglicherweise gehackt" markiert. Diese Warnung zerstört die Klickrate (CTR) und das Vertrauen der Nutzer. Um seine Nutzer zu schützen, entfernt Google kompromittierte Seiten sehr schnell aus dem Suchindex oder straft sie massiv ab, was zu einem kompletten Verlust der organischen Sichtbarkeit führt. Die Wiederherstellung des Rankings nach einem solchen Vorfall ist ein langwieriger und mühsamer Prozess.

Die Kausalkette ist hier direkt und unmissverständlich: Ein Hoster spart an Wartungsaufwand und lässt eine veraltete PHP-Version auf dem Server laufen. Ein automatisierter Bot scannt das Web nach einer bekannten Schwachstelle in dieser Version und hackt die Website. Der Hacker fügt Spam-Inhalte ein. Der Googlebot crawlt die Seite, erkennt die Manipulation und entfernt die Seite zum Schutz der Nutzer aus dem Index. Die Entscheidung des Hosters, kein Update durchzuführen, führt somit direkt zur vollständigen Zerstörung der SEO-Sichtbarkeit der Kundenwebsite. Sicherheit und SEO sind untrennbar miteinander verbunden.

Das "Bad Neighborhood"-Problem beim Shared Hosting

Beim Shared Hosting, dem kostengünstigsten Hosting-Modell, teilen sich Hunderte oder Tausende von Websites die Ressourcen eines einzigen Servers und oft auch eine gemeinsame IP-Adresse. Dies birgt das Risiko der "schlechten Nachbarschaft" (Bad Neighborhood). Wenn eine oder mehrere Websites auf derselben IP-Adresse für Spam, Phishing oder andere illegale Aktivitäten missbraucht werden, kann die gesamte IP-Adresse einen schlechten Ruf erlangen und auf globalen Blacklists landen.

Die SEO-Nachteile sind hierbei meist indirekter Natur. Das primäre Risiko ist nicht eine direkte Abstrafung durch Google allein aufgrund der geteilten IP. Google ist in der Regel in der Lage, zwischen den einzelnen Websites auf einem Server zu differenzieren. Die realen Probleme entstehen durch Kollateralschäden:

- Performance-Verschlechterung: Spam-Aktivitäten oder ein DDoS-Angriff auf einen "Nachbarn" können die Server-Ressourcen (CPU, Bandbreite) so stark belasten, dass die eigene, legitime Website extrem verlangsamt wird oder komplett ausfällt. Dies verschlechtert direkt die Performance-Metriken (TTFB, CWV) und führt zu den in Teil I beschriebenen negativen Ranking-Effekten.

- Reputationsschaden der IP: Wenn die geteilte IP-Adresse auf Spam-Blacklists landet, kann dies die Zustellbarkeit von E-Mails, die von dieser IP gesendet werden (z.B. Transaktions-E-Mails eines Onlineshops), erheblich beeinträchtigen. Sie landen direkt im Spam-Ordner der Empfänger, was das Geschäft schädigt.

Das Risiko von Shared Hosting liegt also weniger in einer direkten "Bad Neighborhood"-Abstrafung durch Google, sondern in der unkontrollierbaren Umgebung, in der man den Problemen und Aktivitäten seiner "Nachbarn" ausgeliefert ist.

Performance-Beeinträchtigung durch veralteten Code

Die Weigerung eines Hosters, aktuelle Software bereitzustellen, ist eine bewusste Entscheidung gegen Performance. Neuere Softwaregenerationen, wie zum Beispiel PHP 8 im Vergleich zu älteren Versionen wie PHP 7, sind nicht nur sicherer, sondern auch signifikant performanter. Sie verarbeiten Code effizienter, benötigen weniger Server-Ressourcen und können Anfragen schneller beantworten.

PHP 7 vs PHP 8 Performance

Leistungsvergleich der PHP-Versionen im direkten Vergleich

Warum PHP 8 die bessere Wahl ist

Ein Hoster, der seine Kunden zwingt, auf einer veralteten technologischen Basis zu arbeiten, verursacht direkt eine höhere Serververarbeitungszeit. Dies führt zu einer schlechteren TTFB, was wiederum den LCP-Wert negativ beeinflusst und die Core Web Vitals verschlechtert. Darüber hinaus sind moderne Content-Management-Systeme, Themes und Plugins für aktuelle Softwareumgebungen optimiert. Der Betrieb auf veralteter Software kann zu Inkompatibilitäten, Fehlfunktionen und einer weiteren Verlangsamung der Website führen. Das Festhalten an veralteter Software ist somit ein klares Indiz für einen minderwertigen Hoster, der notwendigen Wartungsaufwand scheut und damit die Ranking-Fähigkeit seiner Kunden aktiv behindert.

Teil III: Mangelnde Unterstützung für moderne Webtechnologien

Ein modernes, performantes Webhosting zeichnet sich nicht nur durch Stabilität und Sicherheit aus, sondern auch durch die Unterstützung aktueller Technologien, die eine effiziente Datenübertragung und -verarbeitung ermöglichen. Das Fehlen dieser Technologien bei einem Hoster schränkt die Optimierungsmöglichkeiten erheblich ein und schafft einen klaren Wettbewerbsnachteil.

Effiziente Datenübertragung: Komprimierung und Protokolle

Die Größe der zu übertragenden Daten und die Effizienz des Übertragungsprotokolls sind entscheidend für die Ladezeit.

- Serverseitige Komprimierung: Technologien wie Gzip oder das modernere Brotli komprimieren textbasierte Dateien wie HTML, CSS und JavaScript vor der Übertragung an den Browser. Dies kann die Dateigröße um bis zu 90 % reduzieren. Kleinere Dateien bedeuten schnellere Downloadzeiten, was die Ladezeit der Seite und insbesondere den LCP direkt verbessert. Ein Hoster, der keine serverseitige Komprimierung standardmäßig aktiviert oder deren Konfiguration nicht erlaubt, verursacht unnötig langsame Ladezeiten.

- Moderne HTTP-Protokolle: Die Protokolle HTTP/2 und das neuere HTTP/3 sind dem veralteten HTTP/1.1 weit überlegen. Sie ermöglichen das parallele Laden mehrerer Ressourcen über eine einzige Verbindung (Multiplexing), was den Ladevorgang von Seiten mit vielen kleinen Dateien (wie CSS, JS, Icons) drastisch beschleunigt. Ein Hoster, der nur HTTP/1.1 unterstützt, schafft einen künstlichen Flaschenhals bei der Datenübertragung und bremst die Website systematisch aus.

Die Unterstützung für moderne Komprimierungs- und Übertragungsprotokolle ist keine optionale Zusatzleistung, sondern eine grundlegende Anforderung an ein performantes Hosting. Ihr Fehlen ist ein klares Zeichen für eine veraltete Infrastruktur, die aktiv die Ladezeitoptimierung und somit die Rankings sabotiert.

Intelligentes Caching: Reduzierung der Serverlast

Caching ist die effektivste Methode, um die Serverlast zu reduzieren und die Performance für wiederkehrende Anfragen zu maximieren. Ein guter Hoster muss mehrstufige Caching-Strategien ermöglichen.

- Browser-Caching: Durch das Setzen von `Expires`- oder `Cache-Control`-Headern auf dem Server kann der Browser angewiesen werden, statische Ressourcen (Bilder, CSS, JS) lokal zu speichern. Bei wiederholten Besuchen müssen diese nicht erneut vom Server geladen werden, was die Ladezeit für wiederkehrende Nutzer drastisch verkürzt. Ein Hoster, der die Konfiguration dieser Header, z.B. über die

.htaccess- Datei, nicht erlaubt, verhindert diese grundlegende Optimierung. - Serverseitiges Caching: Fortgeschrittene Technologien wie Varnish, Redis oder Memcached speichern häufig abgerufene Datenbankergebnisse oder ganze fertig gerenderte Seiten im schnellen Arbeitsspeicher des Servers. Anstatt bei jeder Anfrage die Seite neu aufzubauen, kann die gecachte Version blitzschnell ausgeliefert werden. Dies reduziert die Serverlast und verbessert die TTFB dramatisch, insbesondere bei hohem Traffic. Billig-Hoster bieten solche fortschrittlichen Caching-Lösungen selten an.

Server-side Caching Performance

Redis, Memcached & Varnish vs. Standard-Setup ohne Caching

🔄 Wie Server-side Caching funktioniert

Redis/Memcached: Datenbankabfragen werden im RAM zwischengespeichert.

Varnish: Komplette HTTP-Responses werden vor dem Webserver gecacht.

Ergebnis: Blitzschnelle Auslieferung ohne DB-Zugriff!

Warum Server-side Caching unverzichtbar ist

Ein Hosting-Paket ohne umfassende Caching-Möglichkeiten ist per Definition nicht für hohe Performance ausgelegt. Bei einem Traffic-Anstieg ohne serverseitiges Caching wird der Server schnell überlastet, was die TTFB für alle Nutzer exponentiell ansteigen lässt und im schlimmsten Fall zu einem Totalausfall mit 5xx-Fehlern führt. Dies löst wiederum die in Teil I beschriebene Kaskade der De-Indexierung aus.

Optimierung von Medien: Moderne Bildformate

Bilder sind oft die größten Dateien auf einer Webseite und damit ein Hauptverursacher für lange Ladezeiten. Moderne Bildformate wie WebP und insbesondere AVIF bieten bei gleicher oder sogar besserer visueller Qualität eine signifikant höhere Kompression als traditionelle Formate wie JPEG oder PNG. Eine AVIF-Datei kann beispielsweise bis zu 97 % kleiner sein als das ursprüngliche PNG-Bild.

Bildformat Performance Vergleich

Dateigröße und Ladezeiten: JPG vs PNG vs WebP vs AVIF

🌐 WebP - Der sichere Modernisierungsschritt

96% Browser-Support und 35% kleinere Dateien machen WebP zur idealen Wahl für die meisten Websites. Perfekte Balance aus Performance und Kompatibilität.

🚀 AVIF - Die Zukunft der Bildoptimierung

Modernste Kompression mit 55% Platzersparnis. Ideal für Progressive Enhancement mit WebP-Fallback für maximale Performance.

Da Bilder häufig das größte sichtbare Element "above the fold" sind, beeinflusst ihre Dateigröße direkt den Largest Contentful Paint (LCP). Die Verwendung moderner, kleinerer Bildformate ist einer der effektivsten Hebel zur Verbesserung der Core Web Vitals. Während die Konvertierung der Bilder oft durch ein CMS-Plugin (z.B. für WordPress) gesteuert wird, muss die Serverumgebung die dafür notwendigen Grafikbibliotheken (z.B. GD oder Imagick) in aktuellen Versionen unterstützen. Ein Billig-Hoster mit veralteten Bibliotheken kann hier Probleme bereiten. Die Nicht-Unterstützung moderner Bildformate durch die Serverkonfiguration beraubt Website-Betreiber somit eines der wichtigsten Werkzeuge zur Performance-Optimierung.

Teil IV: Fehlende Log-Dateien – SEO im Blindflug

Fehlende Zugriff auf Server-Log-Dateien macht bei vielen Billig-Hostern eine datengestützte technische SEO unmöglich und führt eventuell zu strategischen Fehlentscheidungen.

Die Anatomie von Server-Logs: Was sie verraten

Server-Logs sind unfiltrierte Textdateien, die jede einzelne Anfrage an einen Webserver protokollieren. Man unterscheidet primär zwischen

- Access-Logs, die alle Zugriffe von Nutzern und Bots aufzeichnen, und

- Error-Logs, die spezifische Server- und Anwendungsfehler protokollieren. Ein typischer Log-Eintrag enthält für die SEO-Analyse kritische Informationen: Die IP-Adresse des Anfragenden, den Zeitstempel, die angeforderte URL, den HTTP-Statuscode (z.B.

200,301,404,503), die übertragene Datenmenge, den User-Agent (der den Browser oder Bot, wie z.B. Googlebot, identifiziert) und die Antwortzeit des Servers.

Kritische SEO-Einblicke durch Log-File-Analyse

Log-Dateien sind die einzige Quelle, die zu 100 % verlässlich zeigt, wie Suchmaschinen-Bots eine Website tatsächlich crawlen und mit ihr interagieren. Die Analyse dieser Daten ermöglicht entscheidende Optimierungen:

- Crawl-Budget-Optimierung: Insbesondere für große Websites ist es entscheidend zu verstehen, wie Google sein Crawl-Budget – die Ressourcen, die es für das Crawlen einer Website aufwendet – verteilt. Log-Dateien zeigen exakt, welche Seiten wie oft besucht werden. So lässt sich erkennen, ob wertvolles Budget auf unwichtige Seiten (z.B. mit Filtern, Paginierung oder geringem Wert) verschwendet wird, anstatt auf die strategisch wichtigen Inhalte.

- Umfassende Fehlerdiagnose: Während Tools wie die Google Search Console nur eine Auswahl an Fehlern melden, erfassen Logs jeden einzelnen

4xx-Client-Fehler (z.B. "Not Found") und5xx-Server-Fehler. Dies ermöglicht die Identifizierung systematischer Probleme, wie fehlerhafte interne Links oder wiederkehrende Serverprobleme, die sonst unentdeckt bleiben und das Ranking schleichend untergraben. - Bot-Verifizierung und Sicherheit: Durch die Analyse von User-Agent-Strings und IP-Adressen lässt sich echter Suchmaschinen-Traffic von schädlichen Bots (Scraper, Spam-Bots) unterscheiden. Dies hilft, Sicherheitsrisiken zu erkennen und bösartigen Traffic gegebenenfalls zu blockieren, um Server-Ressourcen zu schonen.

Ein umfangreicher Artikel, wie man durch Logfileanalysen sein OnPage-SEO verbessern kann findet sich hier.

Die Konsequenzen fehlenden Zugriffs

Ein Hosting-Anbieter, der aus Kostengründen oder zur Vereinfachung seiner Verwaltung keinen Zugriff auf unbearbeitete Server-Logs gewährt, degradiert die technische SEO zur reinen Spekulation.

Ohne Log-Daten basieren Optimierungsentscheidungen auf Annahmen und den unvollständigen Berichten von Tools wie der Google Search Console. Ein SEO-Manager kann nicht verifizieren, ob eine Änderung an der robots.txt oder der internen Verlinkung das Crawl-Verhalten von Google tatsächlich positiv beeinflusst hat. Er operiert im Blindflug. Kritische Fehler, die nur sporadisch auftreten oder nur von Bots ausgelöst werden, bleiben verborgen.

Das Angebot von Log-File-Zugriff ist somit ein entscheidendes Qualitätsmerkmal eines professionellen Hosters. Dessen Fehlen ist nicht nur eine Unannehmlichkeit, sondern entwertet die Arbeit und die Investition in jedes professionelle SEO-Team, da ihnen das wichtigste Diagnosewerkzeug für technische SEO vorenthalten wird.

Teil V: Synthese und Handlungsempfehlungen – Vom Wissen zur Tat

Die vorangegangenen Analysen haben die komplexen Kausalitäten zwischen Hosting-Qualität und SEO-Performance aufgezeigt. Dieser abschließende Teil bündelt die Erkenntnisse und übersetzt sie in konkrete, umsetzbare Anleitungen für die Auswahl und Verwaltung eines SEO-freundlichen Hostings.

Checkliste zur Evaluierung der Hosting-Qualität

Die folgende Checkliste dient als praktisches Werkzeug zur Bewertung eines aktuellen oder potenziellen Hosting-Anbieters. Sie fasst die in diesem Bericht diskutierten technischen Anforderungen zusammen und hilft, fundierte Entscheidungen zu treffen.

| Kategorie | Prüfpunkt | Kriterium für gutes Hosting |

|---|---|---|

| Performance | Garantierte Uptime (SLA) | ≥99.9% |

| Serverstandort | Standort im primären Zielmarkt (z.B. Deutschland für DE-Markt) | |

| TTFB-Benchmark | Messbar unter 800 ms (besser < 500 ms) | |

| HTTP-Protokoll | Unterstützung für HTTP/2 und HTTP/3 | |

| CDN-Integration | Integriertes oder einfach zu konfigurierendes CDN | |

| Software & Technologie | PHP-Versionen | Zugriff auf die neuesten, stabilen PHP-Versionen (z.B. 8.x) |

| Serverseitiges Caching | Optionen wie Redis, Memcached oder Varnish verfügbar | |

| Komprimierung | Gzip und/oder Brotli standardmäßig aktiviert/konfigurierbar | |

| Sicherheit | Proaktive Sicherheitsmaßnahmen | Server-seitige Firewalls, regelmäßige Malware-Scans |

| Backups | Tägliche, automatische Backups mit einfacher Wiederherstellung | |

| SSL-Zertifikate | Kostenlose Let's Encrypt-Zertifikate inklusive und einfach zu installieren | |

| Zugriff & Kontrolle | Server-Zugriff | Voller FTP/SFTP-Zugriff |

| Konfigurationsdateien | Voller Schreibzugriff auf `.htaccess` (bei Apache-Servern) | |

| Log-Dateien | Uneingeschränkter Zugriff auf rohe Access- und Error-Logs | |

| Support & Vertrag | Technischer Support | 24/7 erreichbarer Experten-Support (kein reines Call-Center) |

| Vertragsbedingungen | Transparente Preisstruktur (auch nach der Erstlaufzeit), faire Kündigungsfristen |

Tabelle 2: Checkliste zur Evaluation eines Webhosting-Anbieters für optimale SEO-Performance.

Auswahl des richtigen Hosting-Modells

Die Wahl des Hosting-Modells ist eine strategische Entscheidung, die auf den spezifischen Anforderungen der Website basieren sollte.

- Shared Hosting: Die günstigste Option, bei der sich viele Websites einen Server teilen. Wie in diesem Bericht dargelegt, ist dieses Modell mit erheblichen SEO-Risiken verbunden: Unvorhersehbare Performance-Schwankungen, das "Bad Neighborhood"-Risiko und stark eingeschränkte Kontroll- und Konfigurationsmöglichkeiten. Es ist nur für sehr kleine, unkritische Projekte oder private Blogs ohne kommerzielle SEO-Ziele geeignet.

- VPS (Virtual Private Server): Ein guter Kompromiss zwischen Kosten und Leistung. Ein VPS stellt einer Website dedizierte virtuelle Ressourcen (CPU, RAM) auf einem physischen Server zur Verfügung. Dies gewährleistet eine stabilere Performance und bietet wesentlich mehr Kontrolle über die Software-Konfiguration als Shared Hosting. Ein VPS ist eine gute Wahl für wachsende Unternehmen, erfordert jedoch technisches Know-how für die Verwaltung oder die Buchung eines "Managed VPS"-Tarifs.

- Dedicated Server: Bietet maximale Performance, Sicherheit und Kontrolle, da der gesamte physische Server einer einzigen Website zur Verfügung steht. Dies ist die beste Lösung für große E-Commerce-Plattformen, hochfrequente Unternehmens-Websites oder Anwendungen mit speziellen Anforderungen. Die Kosten und der Verwaltungsaufwand sind entsprechend hoch.

- Managed Hosting (z.B. für WordPress): Eine zunehmend beliebte Option, bei der sich ein spezialisierter Anbieter auf die Optimierung der Hosting-Umgebung für ein bestimmtes CMS (wie WordPress, TYPO3 oder Magento) konzentriert. Diese Hoster übernehmen proaktiv Updates, Sicherheitspatches, Performance-Optimierungen und Caching-Konfigurationen. Für Unternehmen ohne eigene IT- oder DevOps-Abteilung ist dies oft die strategisch beste Wahl, da viele der in diesem Bericht genannten SEO-kritischen Aspekte vom Anbieter professionell abgedeckt werden.

Strategie für einen SEO-sicheren Hosting-Wechsel

Ein unvorbereiteter Hosting-Wechsel birgt erhebliche Risiken und kann zu Downtime, Datenverlust und massiven Ranking-Einbrüchen führen.

Eine sorgfältige Planung ist hier sehr wichtig.

- Vorbereitung: Erstellen Sie ein vollständiges Backup aller Website-Dateien und der Datenbank.

- Einrichtung und Migration: Richten Sie das neue Hosting-Paket ein und migrieren Sie die Daten der Website.

- Umfassende Tests: Bevor die Domain umgestellt wird, muss die migrierte Website auf einer temporären URL oder in einer Staging-Umgebung auf Funktionalität, Ladezeiten und korrekte Darstellung geprüft werden. Alle internen Links, Skripte und das SSL-Zertifikat müssen einwandfrei funktionieren.

- DNS-Umstellung: Reduzieren Sie die TTL (Time To Live) der DNS-Einträge Ihrer Domain im Vorfeld auf einen niedrigen Wert (z.B. 300 Sekunden), um die Propagierungszeit zu verkürzen. Stellen Sie dann die DNS-Einträge (insbesondere den A-Record) auf die IP-Adresse des neuen Servers um.

- Finale Überprüfung: Nach der Umstellung muss die Website unter der Live-Domain erneut umfassend getestet werden.

- 301-Weiterleitungen: Sollten sich im Zuge des Wechsels URL-Strukturen ändern (was unbedingt vermieden werden sollte), ist die Einrichtung lückenloser 301-Weiterleitungen von den alten auf die neuen URLs zwingend erforderlich, um den über Jahre aufgebauten "Linkjuice" und die bestehenden Rankings zu erhalten.

- Kündigung des alten Hosters: Der Vertrag mit dem alten Anbieter sollte erst dann gekündigt werden, wenn die Website auf dem neuen Server nachweislich stabil und fehlerfrei läuft.

Schlussfolgerung: Hosting als strategische SEO-Investition

Dieser Beitrag hat die tiefgreifenden und oft unumkehrbaren Auswirkungen der Hosting-Qualität auf die SEO-Performance einer Website aufgezeigt. Die Kausalketten von der Server-Hardware und -Konfiguration über messbare Performance-Metriken bis hin zum finalen Google-Ranking sind eindeutig.

Die Wahl des Webhostings ist keine nachgelagerte technische Entscheidung, sondern eine fundamentale strategische Weichenstellung, die über den Erfolg oder Misserfolg im organischen Such-Kanal mitentscheidet.

Unternehmen und Website-Betreiber müssen einen Paradigmenwechsel vollziehen: Hosting darf nicht länger als reiner Kostenfaktor betrachtet werden, der minimiert werden muss. Es ist vielmehr eine strategische Investition in Performance, Sicherheit, Datenanalysefähigkeit und letztlich in die eigene Sichtbarkeit. Die kurzfristige Ersparnis durch einen "Billighoster" wird mittel- und langfristig durch Ranking-Verluste, Sicherheitsrisiken, Reputationsschäden und hohe Opportunitätskosten mehr als aufgezehrt.

Mit der verstärkten Fokussierung von Google auf die User Experience, manifestiert in den Core Web Vitals und dem Page Experience Update, wird die Bedeutung der technischen Infrastruktur weiter zunehmen. Ein leistungsstarkes, sicheres und modernes Hosting ist keine Option mehr, sondern die Eintrittskarte, um im intensiven Wettbewerb um die Top-Rankings überhaupt teilnehmen zu können.