Strategische Analyse von Dark Keywords, Datenverschleierung und der Zukunft der Suche im KI-Zeitalter

Der meiste Traffic kommt von Keywords, die Sie in Ihren Analysetools gar nicht sehen können. Dieser "Dark Traffic" ist eine der größten ungenutzten Chancen im modernen SEO. Erfahren Sie, warum diese unsichtbaren Suchanfragen – die sogenannten "Dark Keywords" – entscheidend für Ihren Erfolg sind und wie Sie sie strategisch nutzen, noch bevor die KI-gestützte Suche die Spielregeln komplett verändert.

tl;dr

Die Kernaussagen auf einen Blick.

Der Großteil des organischen Traffics stammt von unsichtbaren "Dark Keywords" – Suchanfragen, die Google aus Datenschutzgründen verschleiert und die in Analyse-Tools nicht erfasst werden. Die KI-Revolution verstärkt diese Intransparenz zusätzlich.

Kernfakten:

- 15% aller täglichen Google-Suchanfragen wurden noch nie zuvor gestellt – genau diese Zero-Volume-Keywords landen als anonymisierte Anfragen in der GSC.

- AI Overviews erscheinen bei 86-91% der Suchanfragen und können organischen Traffic um 18-64% reduzieren, ohne dass dies in der GSC segmentierbar ist.

- SEO-Tools arbeiten mit Third-Party-Schätzungen und sind strukturell blind für Dark Keywords – nur die GSC-API liefert reale First-Party-Daten.

- Query Fan-Out zerteilt Nutzeranfragen hinter den Kulissen in synthetische Unterabfragen – die gemeldeten Keywords sind nicht mehr die ursprünglichen Nutzereingaben.

Handlungsempfehlung:

Wechsel von reaktiver Keyword-Optimierung zu proaktivem Aufbau thematischer Autorität durch Pillar-Cluster-Content. Content für KI-Systeme strukturieren (Listen, Tabellen, Schema-Markup, klare Überschriften). GSC-API nutzen und Fokus auf Seiten-Trends statt einzelne Keywords legen.

→ Im Hauptartikel: Keyword-Taxonomie, GSC-Limitierungen, Query Fan-Out-Mechanik, GEO-Strategien, E-E-A-T für KI-Zitierbarkeit

Entmystifizierung von "Dark Keywords": Eine Taxonomie der unsichtbaren Suchlandschaft

Etablierung einer Arbeitsdefinition

Der Begriff Dark Keywords ist in der SEO-Branche kein standardisierter Fachterminus wie "Long-Tail-Keywords" oder "Seed-Keywords". Seine Bedeutung ist kontextabhängig und wird oft lose verwendet, um sich auf vieles zu beziehen, von statistisch unsichtbaren Suchbegriffen bis hin zur allgemeinen Verschleierung von Keyword-Daten durch Google. Für die Zwecke dieses Beitrags fasse ich den Begriff in Form einer zweiteiligen Definition zusammen, um die Komplexität des Phänomens zu erfassen.

- Datenschutzverschleierte Keywords: Dies sind Suchanfragen, die Impressionen und Klicks generieren, aber in Analysetools wie der Google Search Console (GSC) aufgrund von Datenschutzschwellen absichtlich verborgen oder aggregiert werden. Dies ist die primäre Bedeutung und eine direkte Folge der Entwicklung von Googles

(not provided)- Politik. - Statistisch unsichtbare Keywords: Dies bezieht sich auf Hyper-Long-Tail- und Zero-Search-Volume-Keywords. Diese Suchanfragen sind so selten oder neu, dass sie in den Datenbanken von Drittanbieter-Tools nicht erfasst werden, was sie aus Planungssicht effektiv "dunkel" macht.

Diese beiden Konzepte sind untrennbar miteinander verbunden. Die statistisch unsichtbaren Keywords sind genau die Suchanfragen, die am ehesten in der Google Search Console zu datenschutzverschleierten Keywords werden, da sie die Schwellenwerte für die Berichterstattung nicht erreichen.

Der Schleier des Datenschutzes: Googles Begründung und ihre Auswirkungen

Google begründet die eingeschränkte Verfügbarkeit von Keyword-Daten offiziell mit dem Schutz der Privatsphäre seiner Nutzer. Ziel sei es, zu verhindern, dass Rückschlüsse auf das Suchverhalten einzelner Personen gezogen werden können. Diese Argumentation wurde mit der Einführung datenschutzbedingter Schwellenwerte formalisiert: Nur Suchbegriffe mit einem ausreichend hohen, aggregierten Suchvolumen werden noch ausgewiesen. Begriffe mit geringem Volumen oder potenziell personenbezogenem Kontext bleiben verborgen – sie erscheinen in Analyse-Tools als (not provided) oder werden gar nicht übermittelt.

Doch diese Praxis wirft Fragen auf:

Während Google selbst weiterhin uneingeschränkten Zugriff auf sämtliche Suchanfragen hat – und diese aktiv zur Optimierung seiner Werbeprodukte, Personalisierung und dem Training eigener KI-Modelle nutzt – werden genau diese Daten externen Akteuren systematisch vorenthalten. Websitebetreiber, SEOs und Marketingverantwortliche erhalten nur fragmentierte Einblicke.

Kritiker werten das nicht nur als Datenschutzmaßnahme, sondern als gezielte Strategie: Durch die künstlich erzeugte Intransparenz wird die Abhängigkeit von Google-Produkten wie Ads, Analytics oder der Search Console verstärkt – und die Kontrolle über den digitalen Informationsfluss bleibt fest in Googles Hand.

Diese Maßnahme ist die direkte Ursache für das Phänomen der dunklen oder anonymisierten Daten in der Suchanalyse.

Die Dark Keywords erschweren eine präzise Suchanalyse, beeinflussen die Messbarkeit von SEO-Erfolgen und erschweren die Optimierung auf Longtail-Traffic.

Der Abgrund des Long Tail: Die Beziehung zu Hyper-Long-Tail- und Zero-Search-Volume-Keywords

Um die Natur von Dark Keywords zu verstehen, ist eine klare Abgrenzung der Keyword-Typen erforderlich. Keywords lassen sich grob in Short-Tail (auch Head oder Seed genannt), Long-Tail und fragebasierte Keywords einteilen. Während Short-Tail-Keywords eher aus ein bis drei Wörtern bestehen, allgemeiner gehalten sind und ein hohes Suchvolumen aufweisen, sind Long-Tail-Keywords spezifischer.

Die Definition von Long-Tail ist jedoch nuanciert. Sie kann sich auf die Länge der Phrase beziehen (typischerweise drei oder mehr Wörter ), aber eine genauere Definition beschreibt sie als jedes Keyword mit geringem monatlichem Suchvolumen, unabhängig von seiner Länge. Das Konzept stammt aus der Suchnachfragekurve, die zeigt, dass die überwiegende Mehrheit der einzigartigen Suchanfragen in den langen, niedrigvolumigen Schwanz (Tail) der Verteilung fällt.

Suchnachfragekurve (Long-Tail-Konzept)

Long-Tail-Keywords verstehen:

Head Keywords: Wenige Keywords mit sehr hohem Suchvolumen (z.B. "Auto kaufen" - 100.000+ Suchanfragen/Monat)

Middle Keywords: Moderate Anzahl mit mittlerem Volumen (z.B. "gebrauchtes Auto München" - 1.000-10.000 Suchanfragen/Monat)

Long-Tail Keywords: Viele spezifische Keywords mit niedrigem Volumen (z.B. "günstiger blauer BMW 3er München Automatik" - <100 Suchanfragen/Monat)

Die Kurve zeigt: Obwohl jedes Long-Tail-Keyword wenig Traffic hat, bilden sie zusammen die Mehrheit aller Suchanfragen und des organischen Traffics.

Hyper-Long-Tail- und Zero-Search-Volume-Keywords stellen das äußerste Ende dieses Spektrums dar. Es handelt sich um extrem spezifische Suchanfragen, für die Keyword-Recherche-Tools ein monatliches Suchvolumen von Null angeben.

Null Volumen bedeutet jedoch nicht, dass niemand sucht. Es bedeutet vielmehr, dass die Suchhäufigkeit unter der Meldeschwelle des Tools liegt oder die Anfrage völlig neu ist. Diese Keywords spiegeln oft aufkommende Trends, Nischenthemen oder sehr spezifische Nutzerbedürfnisse wider.

Die Verbindung wird deutlich, wenn man bedenkt, dass laut Google 15 % der täglichen Suchanfragen noch nie zuvor gestellt wurden.

Genau diese neuen und seltenen Anfragen fallen in die Kategorie der Zero-Search-Volume-Keywords. Da sie per Definition kein ausreichendes Suchvolumen haben, werden sie in der GSC anonymisiert. Dies schafft eine direkte Verbindung zwischen der statistischen Realität der Suche und den durch Datenschutz gefilterten Daten. Die Dunkelheit ist somit kein Fehler im System, sondern eine systemische Bedingung, die aus dem Zusammentreffen der unendlichen Ausdrucksmöglichkeiten der Nutzer (dem Long Tail) und dem plattformgetriebenen Gebot des Datenschutzes entsteht. Dies stellt eine fundamentale Herausforderung für eine rein keyword-zentrierte SEO dar. Wenn die Mehrheit der Suchanfragen von Natur aus unsichtbar ist, müssen sich Strategien von der Optimierung auf das Messbare (den Kopf der Nachfragekurve) hin zur Adressierung des unermesslichen, aber riesigen Potenzials des Long Tails verschieben.

| Konzept | Definition | Ursprung | Primäre Herausforderung |

|---|---|---|---|

| Datenschutzverschleierte Keywords (Anonymisierte Anfragen der GSC) | Suchanfragen, die Traffic generieren, aber in der GSC nicht einzeln ausgewiesen werden, um die Privatsphäre der Nutzer zu schützen. | Datenschutzgetriebene Filterung durch Google. | Datendiskrepanz & Attributionslücke. |

| Hyper-Long-Tail-Keywords | Hochspezifische Suchanfragen mit mehreren Wörtern und sehr geringem individuellem Suchvolumen. | Statistische Natur des Suchverhaltens der Nutzer. | Entdeckung & Skalierbarkeit. |

| Zero-Search-Volume-Keywords | Suchanfragen, die von SEO-Tools mit 0 monatlichen Suchen angegeben werden, oft weil sie neu, nischenhaft oder unter den Meldeschwellen liegen. | Statistische Beschränkungen von Drittanbieter-Tools & aufkommende Trends. | Rechtfertigung & Priorisierung. |

Die Black Box: Datenbeschränkungen in der Google Search Console

Das Problem der anonymisierten Anfragen im Detail

Die Google Search Console (GSC) ist das primäre Werkzeug zur Analyse der organischen Suchleistung, aber sie ist nicht besonders transparent. Aus Datenschutzgründen lässt sie absichtlich Suchanfragen weg, die potenziell eine Person identifizieren könnten. Diese werden als anonymisierte Anfragen bezeichnet. In der Praxis handelt es sich dabei um sehr seltene oder extrem spezifische Long-Tail-Suchen, die über einen Zeitraum von zwei bis drei Monaten nur von wenigen Dutzend Nutzern gestellt werden.

Dies führt zu einer kritischen Datendiskrepanz: Die Summe der Klicks oder Impressionen für alle einzeln aufgeführten (sichtbaren) Suchanfragen wird fast nie mit den Gesamtklicks oder -impressionen übereinstimmen, die für eine Seite oder die gesamte Website gemeldet werden. Die Differenz ist der Traffic, der von diesen dunklen, anonymisierten Keywords stammt.

Googles eigene Datenexporte veranschaulichen dies: Wenn die Summe der Klicks aus den aufgelisteten Anfragen 4500 beträgt, der Gesamtwert aber 5500 ist, bedeutet das, dass 1000 Klicks von nicht sichtbaren, anonymisierten Anfragen stammen.

Dieses Problem verschärft sich erheblich, sobald in der GSC-Oberfläche Filter angewendet werden. Die Anwendung jedes beliebigen Filters – sei es nach Suchanfrage, Land oder Gerät – führt dazu, dass alle Daten von anonymisierten Anfragen aus den Gesamtsummen entfernt werden. Dies resultiert in plötzlichen und oft verwirrenden Rückgängen der angezeigten Zahlen, was die Analyse erschwert.

Die 1.000-Zeilen-Mauer und API-Workarounds

Die Benutzeroberfläche der GSC ist strikt auf die Anzeige von nur 1.000 Datenzeilen beschränkt, sei es für Suchanfragen, Seiten oder andere Dimensionen. Diese Daten sind immer nach Klicks und Impressionen absteigend sortiert. Für große Websites stellt dies eine erhebliche Einschränkung dar. Es verhindert die Analyse potenziell wertvoller Daten jenseits dieser Grenze, wie zum Beispiel die Identifizierung aller Keywords, die auf Seite 2 der Suchergebnisse ranken und Optimierungspotenzial bieten.

Die einzige Möglichkeit, auf einen größeren Datensatz zuzugreifen, ist die Search Analytics API. Sie ermöglicht den Abruf von bis zu 50.000 Zeilen pro Tag und Property. Es ist jedoch wichtig zu verstehen, dass auch die API denselben Datenschutzfiltern unterliegt. Sie enthüllt nicht die verborgenen, anonymisierten Suchanfragen, sondern liefert lediglich eine größere Stichprobe der sichtbaren Anfragen.

Die Integrität sekundärer Metriken

Über die Datenlücken hinaus sind auch einige der Kernmetriken der GSC mit Vorsicht zu genießen, da sie systemischen Verzerrungen unterliegen.

- Durchschnittliche Position: Diese Metrik kann für Suchanfragen mit wenigen Impressionen äußerst irreführend sein. Sie berücksichtigt personalisierte und lokalisierte Ergebnisse. Das bedeutet, dass ein Website-Betreiber, der wiederholt nach seiner eigenen Marke sucht, die durchschnittliche Position künstlich auf 1,0 anheben kann. Die Metrik wird erst bei einer hohen Anzahl von Impressionen statistisch aussagekräftig.

- Aufgeblähte Impressionen: Die Impressionszahlen können durch Sitelinks, die bei Markensuchen erscheinen, künstlich erhöht werden. Sowohl die Homepage als auch mehrere Sitelink-URLs erhalten dabei eine Impression. Nutzer klicken jedoch fast immer auf den Hauptlink zur Homepage, was die Klickrate (CTR) für die als Sitelinks angezeigten Unterseiten systematisch nach unten verzerrt.

- Datenverzögerung und Umfang: Die in der GSC verfügbaren Daten sind auf die letzten 16 Monate beschränkt; ältere Daten werden gelöscht. Zudem liefert das Tool ausschließlich Daten für die Google-Suche und ignoriert andere Suchmaschinen. Geografische Filter sind auf Länderebene beschränkt und erlauben keine Analyse auf Städteebene, was für lokale Unternehmen eine Einschränkung darstellt.

Die Kombination aus harten Datenlimits, absichtlicher Verschleierung von Anfragen aus Datenschutzgründen und systemischen Ungenauigkeiten bei sekundären Metriken zeigt, dass die GSC nicht als umfassendes, lückenloses Analysetool konzipiert ist.

Vielmehr sollte sie als ein "Gesundheitsmonitor" betrachtet werden. Sie liefert die genauesten verfügbaren Richtungsdaten direkt von der Quelle, aber ihre Zahlen als absolute Wahrheit zu behandeln, ist ein strategischer Fehler. SEO-Experten müssen daher eine Methodik entwickeln, die diese Unsicherheit akzeptiert. Dies erfordert den Einsatz der GSC-API, um die größtmögliche Datenstichprobe zu erhalten, den Abgleich mit Drittanbieter-Tools zur Validierung von Trends und vor allem die Konzentration auf die Analyse von Leistungs-Trends auf Seiten- und Themenebene, anstatt sich in den Details einzelner, potenziell irreführender Keyword-Daten zu verlieren.

Ein verzerrter Spiegel: Warum SEO-Plattformen (Sistrix, Ahrefs) nicht im Dunkeln sehen können

Die fundamentale Datentrennung: First-Party vs. Third-Party

Um die Rolle von SEO-Plattformen wie Ahrefs, Sistrix oder SEMrush zu verstehen, muss man die grundlegende Unterscheidung zwischen ihren Daten und denen der Google Search Console kennen.

- First-Party-Daten (GSC): Die GSC liefert Daten aus erster Hand. Es handelt sich um reale, beobachtete Klicks und Impressionen aus den eigenen Protokollen von Google. Obwohl diese Daten einer Stichprobe unterliegen und gefiltert sind, stammen sie direkt von der Quelle.

- Third-Party-Daten (SEO-Plattformen): Diese Tools verwenden Daten von Drittanbietern. Ihr Geschäftsmodell basiert darauf, das Web kontinuierlich zu durchsuchen (Ahrefs crawlt fast eine Milliarde Webseiten), riesige Keyword-Datenbanken aufzubauen und zu beobachten, welche Website für welches Keyword rankt. Basierend auf der Ranking-Position und einem geschätzten Suchvolumen berechnen sie dann den geschätzten organischen Traffic.

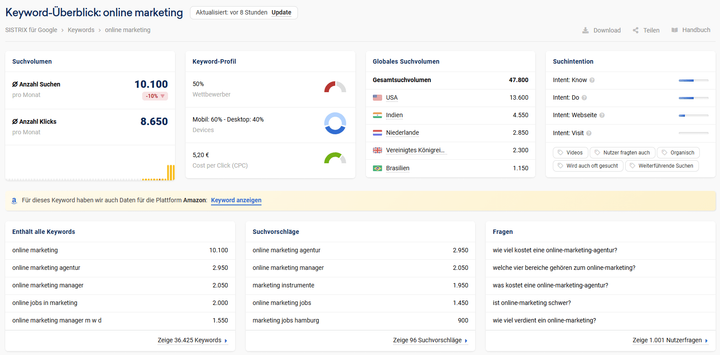

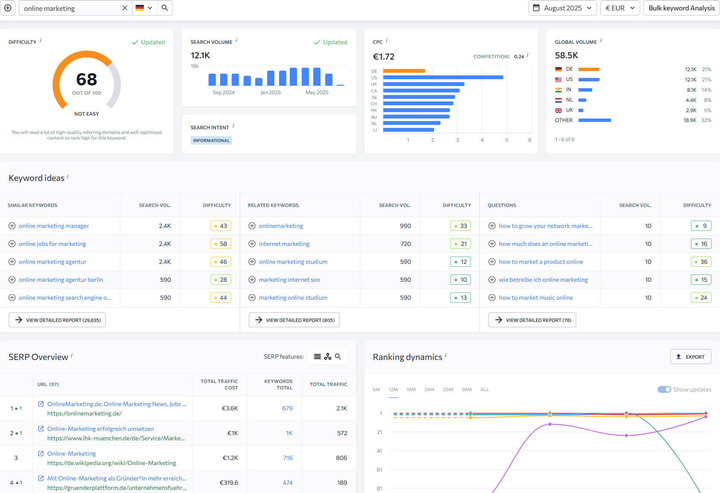

Diese unterschiedlichen Datenquellen und Modelle führen zwangsläufig zu Diskrepanzen. Die Tools zeigen oft unterschiedliche Ergebnisse untereinander und weichen von den Daten der GSC ab, da ihre Datenbanken, Crawling-Methoden und Berechnungsmodelle variieren.

Der Trugschluss des Suchvolumens

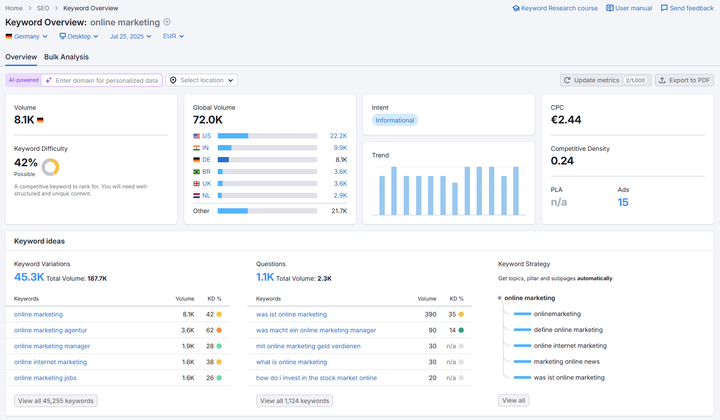

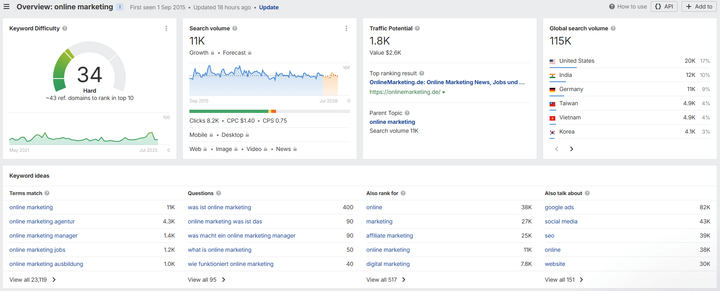

Das Suchvolumen, eine zentrale Metrik in allen Drittanbieter-Tools, ist keine direkte Messung von Google. Es ist eine Schätzung, die oft auf Daten aus dem Google Ads Keyword Planner basiert. Dieses Tool ist jedoch für Werbetreibende konzipiert, nicht für die Analyse des organischen Suchverhaltens, siehe hier.

Ein entscheidender Schwachpunkt dieser Modelle ist ihre Blindheit gegenüber Zero-Search-Volume-Keywords und aufkommenden Trends. Da ihre Datenbanken auf historischen Daten beruhen, kann ein neuer Begriff, der an Popularität gewinnt, noch wochen- oder monatelang ein Suchvolumen von "0" aufweisen.

Dies macht sie ungeeignet für die Identifizierung von Chancen im Bereich der "Dark Keywords". Die Tools können nur zeigen, was bereits bekannt ist und eine messbare Vergangenheit hat.

Der strategische Einsatz von Drittanbieter-Tools

Trotz ihrer Einschränkungen sind diese Plattformen für bestimmte Aufgaben, bei denen die GSC schwach ist, von unschätzbarem Wert. Ihre Stärke liegt nicht in der Messung der absoluten Performance, sondern in der Wettbewerbsbeobachtung und der strategischen Planung.

- Wettbewerbsanalyse: Sie sind hervorragend geeignet, um die Keyword-Strategie eines Konkurrenten zu verstehen, Content-Lücken zu identifizieren und herauszufinden, für welche Keywords Wettbewerber ranken, man selbst aber nicht. Dies ist ihre primäre Stärke.

- Backlink-Recherche: Insbesondere Ahrefs gilt als Marktführer in der Backlink-Analyse und bietet einen weitaus umfassenderen Überblick als die begrenzten Daten in der GSC.

- Keyword-Ideenfindung: Sie sind leistungsstarke Werkzeuge, um aus einem Seed-Keyword eine Fülle von verwandten Ideen zu generieren, diese nach Metriken wie Keyword-Schwierigkeit zu filtern und verwandte Fragen zu entdecken.

Drittanbieter-SEO-Tools beleuchten also nicht die dunklen Keywords; sie operieren in einer anderen Art von Dunkelheit – der Dunkelheit der Schätzung.

Sie sind mächtig für die Analyse des sichtbaren Webs, aber strukturell nicht in der Lage, die wahren, ungefilterten Nutzeranfragen aufzudecken, die die GSC verbirgt. Die Daten, die die GSC ausblendet (die seltenen Long-Tail-Anfragen), sind genau die Daten, die Drittanbieter-Tools aufgrund ihrer Methodik ohnehin nie sehen konnten.

Eine fortschrittliche SEO-Strategie erfordert daher einen hybriden Ansatz:

- Drittanbieter-Tools werden genutzt, um die bekannte Wettbewerbslandschaft zu kartieren und breite Themen zu identifizieren.

- Die GSC wird verwendet, um die tatsächliche Leistung für den sichtbaren Teil dieser Themen zu messen.

- Qualitative Methoden, die später behandelt werden, dienen schließlich dazu, den "dunklen" Raum zu erforschen, den beide Tool-Sets verfehlen.

| Attribut | Google Search Console | Drittanbieter-Plattformen (Ahrefs, Sistrix, etc.) |

|---|---|---|

| Datenquelle | First-Party-Daten aus Google-Protokollen. | Third-Party-Daten aus Web-Crawling und Clickstream-Panels. |

| Schlüsselmetriken | Tatsächliche Klicks & Impressionen. | Geschätzter Traffic & geschätztes Suchvolumen. |

| Genauigkeit | Hoch (für das, was angezeigt wird), aber als Stichprobe und datenschutzgefiltert. | Richtungsweisend nützlich, aber basierend auf Modellen und Schätzungen. |

| Umfang | Nur die eigene Website. | Jede beliebige Website (Wettbewerber). |

| Primärer Anwendungsfall | Messung der tatsächlichen Website-Performance, Identifizierung technischer Probleme. | Wettbewerbsanalyse, Backlink-Recherche, Keyword-Ideenfindung. |

| "Dark Keyword" Blind Spot | Anonymisiert Suchanfragen mit geringem Volumen. | Meldet keine Zero-Volume- oder aufkommenden Suchanfragen. |

Die KI-Revolution: Wie die generative Suche die Schatten vertieft

AI Overviews (AIOs) und die "Zero-Click"-Bedrohung

Die Einführung von Googles Search Generative Experience (SGE), jetzt als AI Overviews (AIOs) bekannt, markierte einen fundamentalen Wandel.

Google transformiert sich von einer Suchmaschine zu einer "Antwortmaschine".

AIOs sind KI-generierte Zusammenfassungen, die direkt an der Spitze der Suchergebnisseite (SERP) erscheinen und die Anfrage des Nutzers oft vollständig beantworten. Dies verstärkt den "Zero-Click"-Trend, bei dem Nutzer ihre Informationen erhalten, ohne jemals eine Website besuchen zu müssen.

Studien zeigen, dass AIOs bei einer überwältigenden Mehrheit der Suchanfragen (86-91 %) erscheinen und das Potenzial haben, den organischen Traffic erheblich zu reduzieren. Schätzungen reichen von einem Rückgang von 18 % bis zu 64 %. Der Grund dafür ist, dass die AIOs die traditionellen organischen "blauen Links" weit nach unten auf der Seite verdrängen, oft um mehr als eine gesamte Bildschirmhöhe.

Neue Paradoxien bei der Berichterstattung in der GSC

Die Integration von KI-Funktionen in die Suche schafft neue und komplexe Herausforderungen für die Datenanalyse in der GSC. Google hat bestätigt, dass Klicks und Impressionen aus AIOs und dem neuen "AI Mode" in den Standard-Leistungsbericht unter dem Suchtyp "Web" einfließen.

Entscheidend ist dabei, dass es keine Möglichkeit gibt, diesen Traffic zu filtern oder zu segmentieren. Man kann die Leistung von AIOs nicht von der Leistung traditioneller organischer Links isolieren. Dies führt zu einem neuen Paradoxon:

Query Fan-Out: Die Abstraktion der Nutzerabsicht

Ein weiteres grundlegendes Konzept, das die generative Suche antreibt, ist der "Query Fan-Out". Wenn ein Nutzer eine komplexe, konversationelle Frage stellt, zerlegt Googles KI (Gemini) diese Anfrage hinter den Kulissen in mehrere kleinere, synthetische Suchanfragen. Die KI führt diese Unterabfragen aus und synthetisiert die Ergebnisse zu einer einzigen, kohärenten Antwort im AIO.

Dies ist ein Paradigmenwechsel für die Keyword-Analyse.

Das Keyword, das im GSC-Bericht erscheint, ist möglicherweise nicht mehr die ursprüngliche Eingabe des Nutzers, sondern eine der von Google generierten synthetischen Unterabfragen.

Dies durchtrennt die Verbindung zwischen der ursprünglichen Nutzerabsicht und den gemeldeten Daten weiter und macht die "Dunkelheit" der Keyword-Daten noch undurchdringlicher.

Die Dämmerung der Generative Engine Optimization (GEO)

Diese Veränderungen erzwingen eine neue Disziplin: die Generative Engine Optimization (GEO), auch bekannt als AI Search Optimization (AISO). Das neue Ziel ist nicht mehr nur, zu ranken, sondern als vertrauenswürdige Quelle in der KI-generierten Antwort zitiert zu werden.

Die Erfolgsmetriken verschieben sich von der Klickrate (CTR) hin zur "Referenzrate" und zur allgemeinen Markensichtbarkeit. Erfolg kann nun bedeuten, in einer AIO erwähnt zu werden, auch wenn dies keine direkten Klicks generiert, da es die Markenbekanntheit und Autorität stärkt. Dies signalisiert den Übergang in eine "Post-Keyword-Ära", in der der Fokus auf thematischer Tiefe, Autorität und der Optimierung von Textpassagen liegt, damit große Sprachmodelle (LLMs) Inhalte leicht verarbeiten und verwenden können.

Generative KI stellt somit die ultimative Verschleierungsschicht dar. Sie verbirgt nicht nur die ursprüngliche Anfrage des Nutzers (durch Query Fan-Out), sondern maskiert auch die Auswirkungen auf die Leistung (durch die Bündelung von Daten in der GSC). Dies erzwingt eine vollständige Neubewertung dessen, was "SEO-Erfolg" bedeutet. Das alte Modell (Nutzer tippt Keyword X -> Website rankt -> Klicks werden gemessen) ist zerbrochen.

Die gesamte SEO-Praxis muss sich neu ausrichten. Reaktive, keyword-basierte Optimierung wird obsolet. Die Zukunft gehört der proaktiven, themenbasierten "Relevanz-Entwicklung" (Relevance Engineering) und der Generative Engine Optimization (GEO). Ziel ist es, ein Content-Ökosystem zu schaffen, das so maßgeblich und gut strukturiert ist, dass die KI es unabhängig von der spezifischen Anfrage als grundlegende Quelle auswählt.

Strategische Rahmenwerke für die Navigation im Dunkeln: Von der Keyword-Obskurität zur thematischen Autorität

Angesichts der zunehmenden Verschleierung von Keyword-Daten und des Aufstiegs der generativen KI müssen SEO-Strategien grundlegend neu ausgerichtet werden. Der Fokus verschiebt sich von der Jagd nach einzelnen Keywords hin zum Aufbau umfassender thematischer Autorität.

Das Modell der thematischen Autorität: Die Kernstrategie

Die effektivste Strategie, um in dieser neuen Ära erfolgreich zu sein, ist der Wechsel von der Optimierung auf einzelne Keyword-Phrasen zur Entwicklung von Themen und Themenclustern. Das Ziel ist es, umfassende Content-Hubs zu schaffen, die ein Thema in seiner Gesamtheit abdecken.

Dies wird durch das "Pillar-Cluster"-Modell erreicht: Eine zentrale "Pillar-Seite" behandelt ein breites Thema, während zahlreiche "Cluster-Seiten" spezifische Unterthemen, Long-Tail-Fragen und Nischenaspekte vertiefen.

Dieser Ansatz fängt auf natürliche Weise Traffic von einer Vielzahl unterstützender Long-Tail- und "dunkler" Keywords ab, da die Website als die maßgebliche Ressource zum Thema positioniert wird. Indem man die umfassendste und am besten strukturierte Antwort auf ein ganzes Themengebiet bietet, wird die Abhängigkeit von der Sichtbarkeit einzelner Keywords reduziert.

Unkonventionelle Recherche: Fragen in den Schatten finden

Da traditionelle Tools die "dunklen Keywords" nicht aufdecken können, sind qualitative Analysemethoden zur Erforschung der Nutzerabsicht unerlässlich.

- Google SERP-Funktionen: Eine systematische Analyse der SERP-Funktionen "People Also Ask" (PAA), Google Autocomplete und "Ähnliche Suchanfragen" liefert direkte Einblicke in reale Nutzerpfade und verwandte Fragen. Tools wie AlsoAsked können dabei helfen, die hierarchischen Beziehungen zwischen PAA-Fragen zu visualisieren und für die Content-Struktur zu nutzen.

- Community-Plattformen: Foren wie Reddit und Quora sind Goldgruben für die Keyword-Recherche. Hier findet man die exakte Sprache, die Schmerzpunkte und die unbeantworteten Fragen der Zielgruppe, oft in Form von Zero-Volume-Anfragen. Diese Plattformen offenbaren die Nutzerabsicht in ihrer rohesten und authentischsten Form und bieten unschätzbare Einblicke für die Erstellung hochrelevanter Inhalte.

- Interne Website-Suche: Die Analyse der Suchprotokolle der eigenen Website ist eine Quelle reiner, ungefilterter Nutzerabsicht von Besuchern, die bereits auf der Seite sind. Sie deckt Content-Lücken, Produktinteressen und die genaue Terminologie auf, die die Nutzer bevorzugen. Suchanfragen, die zu keinen Ergebnissen führen ("zero-result queries"), sind ein direkter Hinweis auf fehlende Inhalte oder Produkte.

Content-Architektur für den KI-Konsum (GEO-Taktiken)

Um von LLMs und AIOs als Quelle zitiert zu werden, muss der Inhalt für die maschinelle Verarbeitung optimiert sein.

- Klare Struktur: Inhalte müssen eine klare, logische Hierarchie mit aussagekräftigen Überschriften (H1, H2, H3 etc.) aufweisen. Dies hilft LLMs, die Struktur und die Wichtigkeit von Informationen zu verstehen.

- Verwendung von Listen und Tabellen: Daten, Prozesse oder Vergleiche sollten in Listen (Aufzählungen, nummerierte Listen) und Tabellen strukturiert werden. Diese Formate machen Informationen für LLMs leicht extrahierbar und wiederverwendbar in AIOs.

- Optimierung für Textpassagen: Inhalte sollten in modulare, in sich geschlossene Abschnitte unterteilt werden, die jeweils eine spezifische Unterabsicht beantworten können. Sprunglinks oder ausklappbare FAQ-Bereiche können diese Struktur weiter verbessern und sowohl die Nutzererfahrung als auch das maschinelle Parsen erleichtern.

- Implementierung von strukturierten Daten (Schema Markup): Durch die Verwendung von Schema-Typen wie

FAQPage,HowTo,ArticleoderRecipekann man der KI explizit mitteilen, worum es in den Inhalten geht. Dies erleichtert die korrekte Interpretation und erhöht die Wahrscheinlichkeit, in Rich Snippets und AIOs gefeatured zu werden.

Die Vorherrschaft von E-E-A-T und Markensignalen

In einer KI-gesteuerten Suchwelt, in der Algorithmen Quellen auswählen, werden die E-E-A-T-Kriterien (Expertise, Experience, Authoritativeness, Trustworthiness) zu einem entscheidenden Rankingfaktor. Es geht darum, reale Erfahrung nachzuweisen, glaubwürdige Quellen zu zitieren, Experten als Autoren zu präsentieren und einen starken Markenruf durch positive Bewertungen, Testimonials und Erwähnungen auf anderen vertrauenswürdigen Websites aufzubauen.

Die Markenautorität selbst wird zu einem Schlüsselsignal. Eine starke, konsistent referenzierte Marke wird von KI-Modellen eher als vertrauenswürdig eingestuft und zitiert.

| Taktik | Begründung (Warum es für KI/GEO funktioniert) | Implementierungsbeispiel |

|---|---|---|

| Themencluster aufbauen | Demonstriert umfassende Autorität zu einem Thema und deckt zahlreiche "dunkle" Anfragen ab. | Erstellen einer Pillar-Seite zu "Digitales Marketing" und Cluster-Seiten für "SEO", "PPC", "Content Marketing". |

| 'People Also Ask' analysieren | Zielt direkt auf nachweislich verwandte Nutzerfragen ab, die KI-Modelle zur Kontextualisierung verwenden. | Mit AlsoAsked Fragen rund um "wie pflanzt man Tomaten" finden und einen FAQ-Abschnitt erstellen. |

| Konversationelle Überschriften verwenden | Passt zu den natürlichen Sprachanfragen, die bei der Sprachsuche und im KI-Chat üblich sind. | Statt "Schuhhaltbarkeit" die Überschrift "Wie lange halten Laufschuhe?" verwenden. |

| HowTo-Schema implementieren | Bietet ein maschinenlesbares Schritt-für-Schritt-Format, das LLMs leicht für Anleitungen wiederverwenden können. | Eine Rezeptseite mit `Recipe`-Schema auszeichnen und jeden Schritt detailliert beschreiben. |

| Daten in Tabellen strukturieren | Erzeugt leicht verdauliche, strukturierte Datenpunkte für Vergleichsanfragen. | Eine Vergleichstabelle mit den Preisen und Funktionen verschiedener Software-Tarife erstellen. |

| Interne Verlinkung nutzen | Stellt semantische Beziehungen zwischen Inhalten her und hilft der KI, die Struktur und Expertise der Website zu verstehen. | Von einem Blogbeitrag über "Keyword-Schwierigkeit" auf die Hauptseite zum Thema "Keyword-Recherche" verlinken. |

Das Toolkit des modernen SEO: Instrumente zur Beleuchtung des Unsichtbaren

Um die strategischen Rahmenwerke erfolgreich umzusetzen, ist ein modernes, hybrides Toolkit erforderlich, das die Stärken verschiedener Datenquellen kombiniert.

Fundamentale Plattformen

- Google Search Console: Unverzichtbar für den Zugriff auf First-Party-Leistungsdaten. Der Fokus sollte auf der API-Extraktion liegen, um die Beschränkungen der Benutzeroberfläche zu umgehen. Die Analyse sollte sich auf Trends auf Seiten- und Verzeichnisebene konzentrieren, anstatt auf einzelne Keywords, da diese Daten, wie dargelegt, unvollständig sind.

- Ahrefs/Sistrix/SEMrush: Diese Plattformen sind unerlässlich für die Wettbewerbsanalyse, die Entdeckung von Themen und die Backlink-Analyse. Ihre Funktionen zur Analyse von Keyword-Lücken und zur Themenrecherche sind die ideale Grundlage für die Entwicklung eines Modells der thematischen Autorität.

Tools zur Themen- & Fragen-Entdeckung

- AlsoAsked, AnswerThePublic: Spezialisierte Tools zur Visualisierung und Sammlung von PAA- und Autocomplete-Daten. Sie helfen, die Pfade der Nutzeranfragen zu verstehen und Content-Strukturen zu planen, die diese Fragen beantworten.

- Forum-/Community-Analyse: Dies kann durch spezialisierte Tools wie den Quora-Scraper von SEO Scout oder einfach durch manuelle Recherche in relevanten Subreddits und Quora-Themen erfolgen. Ziel ist es, die authentische Sprache und die ungelösten Probleme der Zielgruppe zu finden.

- Interne Suchanalytik: Die Konfiguration der Website-Suche in Google Analytics 4 (GA4) ist entscheidend. Sie liefert einen direkten Datenstrom der Nutzerabsichten auf der eigenen Plattform und deckt Content-Lücken schonungslos auf.

Tools zur KI-Sichtbarkeit und -Optimierung

- AIO-Tracking: Da die GSC keine segmentierten Daten für AIOs anbietet, sind Drittanbieter-Tools zur Messung der Sichtbarkeit in diesem neuen SERP-Feature unerlässlich geworden. Führende Plattformen wie Ahrefs, Sistrix und SEOmonitor bieten inzwischen Funktionen an, um zu identifizieren, welche Keywords AIOs auslösen und welche Websites darin zitiert werden.

- Content-Optimierungsplattformen: Tools wie SurferSEO oder Frase helfen dabei, Inhalte basierend auf einer detaillierten SERP-Analyse zu strukturieren. Sie analysieren die Top-Ranking-Seiten und geben Empfehlungen zur Inhaltsstruktur, zu semantisch verwandten Begriffen und zur Formatierung, was für die Anpassung an die von KI-Modellen bevorzugten Formate immer wichtiger wird.

Datenintegration und Analyse

Der moderne SEO-Workflow erfordert die Verknüpfung von Daten aus diesen unterschiedlichen Quellen. Ein effektiver Prozess könnte wie folgt aussehen:

- Identifizieren: Mit einem Drittanbieter-Tool (z.B. Semrush) die Keywords identifizieren, die häufig AIOs auslösen und für das eigene Geschäft relevant sind.

- Priorisieren: Diese Keyword-Liste mit den leistungsstärksten Seiten (hohe Impressionen, aber vielleicht sinkende CTR) aus der GSC abgleichen, um die Seiten mit dem größten Optimierungsbedarf zu finden.

- Optimieren: Die priorisierten Seiten gemäß den GEO-Prinzipien (klare Struktur, Listen, Tabellen, Schema-Markup) überarbeiten, um sie für die KI-Verarbeitung attraktiver zu machen.

- Überwachen: Die Leistungs-Trends dieser Seiten auf aggregierter Ebene (Gesamtimpressionen und -klicks der Seite) in der GSC weiter beobachten, um die Auswirkungen der Optimierung zu bewerten, da eine Überwachung auf Keyword-Ebene irreführend wäre.

Abschließende Analyse und Zukunftsausblick

Synthese der wichtigsten Erkenntnisse

Die Analyse hat gezeigt, dass Dark Keywords kein vorübergehendes Phänomen sind, sondern ein dauerhafter Bestandteil des Such-Ökosystems, der aus dem Zusammenspiel von Datenschutzrichtlinien und der statistischen Natur des Long Tail resultiert. Die Fähigkeit, die Leistung auf der Ebene einzelner Keywords zu verfolgen, wird durch die Datenverschleierung in der GSC und die Funktionsweise der generativen KI zunehmend unzuverlässig und obsolet.

Daraus ergibt sich ein klarer strategischer Imperativ: Eine Abkehr von der reaktiven Keyword-Optimierung hin zum proaktiven Aufbau umfassender thematischer Autorität. Erfolg im Zeitalter der KI wird nicht mehr allein durch Rankings und Klicks definiert, sondern durch die Fähigkeit, eine zitierfähige, maßgebliche Quelle zu sein. Neue Metriken wie Sichtbarkeit in AIOs und die "Referenzrate" werden an Bedeutung gewinnen.

Die Zukunft der Suchmessung und -optimierung

Die Rolle des SEO-Experten wird sich weiterentwickeln. Der Fokus wird sich noch stärker von rein technischen Manipulationen auf strategische Content-Entwicklung, Markenaufbau und den Nachweis echter Expertise, Erfahrung, Autorität und Vertrauenswürdigkeit (E-E-A-T) verlagern.

Die Prinzipien der "Generative Engine Optimization" (GEO) werden zur Standardpraxis. Das SEO-Toolkit wird zunehmend auf KI-gestützte Plattformen angewiesen sein, die in der Lage sind, die Ausgaben von LLMs zu überwachen und möglicherweise sogar zu beeinflussen. Das ultimative Ziel ist nicht mehr nur, gefunden zu werden, sondern die Grundlage der Antwort zu sein. Diejenigen, die lernen, im Dunkeln zu navigieren, indem sie sich auf Themen, Nutzerabsicht und Autorität konzentrieren, werden die Gewinner dieser neuen Ära der Suche sein.